編輯:桃子 好困

【新智元導讀】 就在剛剛,Ilya創業新公司SSI完成一筆10億美元融資。公司僅僅成立3個月,10位成員,如此神速地拿到巨額融資。目前,公司估值高達50億美金。

時隔三個月,失蹤人口再次回歸!

Ilya官宣,自家公司SSI(Safe Superintelligence)完成10億美元首輪融資,估值高達50億美金。

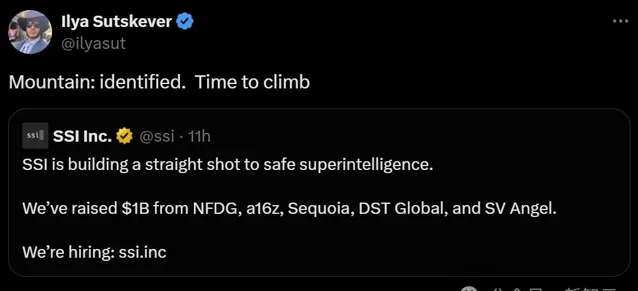

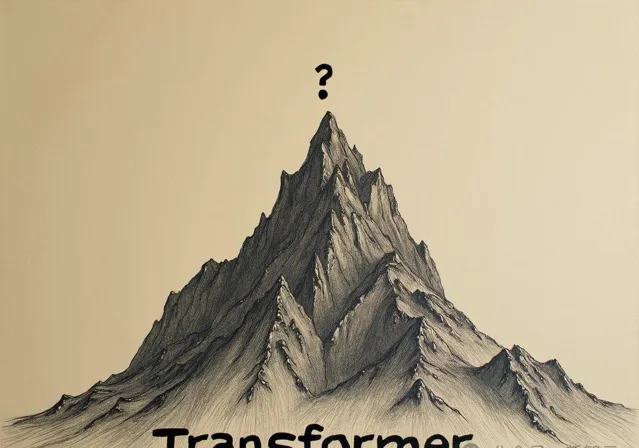

他發文稱,「高山已確定,是時候往上爬了」。

另一位聯創 Daniel Levy 表示,是時候開幹了!

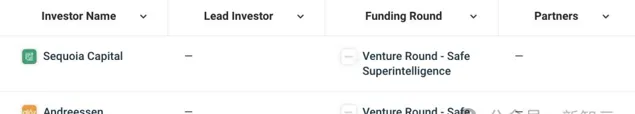

SSI首輪融資的投資者包括,Andreessen Horowitz、紅杉資本、 DST Global 、SV Angel。

由Nat Friedman和SSI執行長Daniel Gross營運的投資合作夥伴關系NFDG,也參與了此次投資。

根據檔顯示,SSI透過多輪融資活動,才籌集的這筆資金。公司已經授權了種子輪、種子擴充套件輪和A輪股份。

值得一提的是,SSI目前僅有10名員工,僅僅成立3個月,便深受資本的青睞。這背後,與最大的IP——Ilya有著密切關系。

想當初,「AI教母」李飛飛也是創業3個月,創造出估值10億美金獨角獸。

不得不說,Ilya帶領SSI一開局,就強的一批。

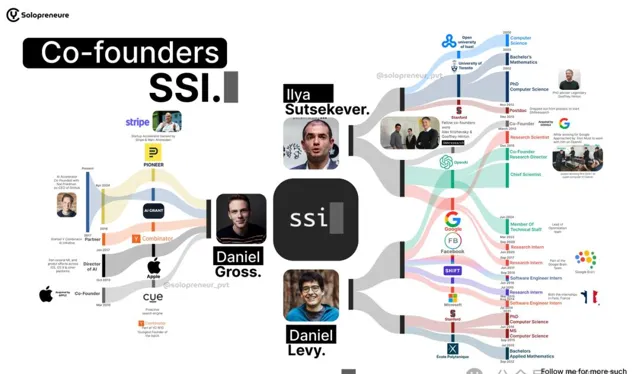

三位聯創:Daniel Gross、Ilya Sutskever、Daniel Levy

3個月,50億美金獨角獸

路透獨家報道稱,此次融資最重要的目的,便是購買算力、聘請頂尖人才。

這家公司自成立伊始,性質便是一家傳統的盈利性公司。

相比之下,OpenAI和Anthorpic都采用了創新的架構——前者是「利潤封頂」模式,而後者是「長期利益信托」。

6月19日,離職OpenAI一個多月的Ilya,終於現身正式宣布了新公司。

他與前蘋果AI計畫負責人Daniel Gross,以及前OpenAI研究員Daniel Levy共同創立了SSI。

Ilya和Levy擔任首席科學家,而Gross負責算力和公司的融資。

在SSI的官方介紹中,Ilya這樣解釋了公司的宗旨和願景——目標唯有一個,就是「實作安全的超級智慧」。

並且,Ilya同時廣發英雄令,召集世界上最優秀的工程師和研究者前來。

有網友調侃道,快把 Greg 招過去,他正好在休假。

目前,SSI已經在兩地——加利福尼亞 Palo Alto ,以及以色列Tel Aviv,建立了一個小型且高度可信的研究團隊。

聯創Daniel Gross在采訪中再次表示:

對我們來說,擁有理解、尊重和支持我們使命的投資者是很重要的。這個使命是直接實作「安全的超級智慧」,並在將產品推向市場之前花費幾年進行研發。

從另一方面可以看出,一些資本家們仍願意對,專註於基礎AI研究的傑出人才投入巨資。

所有人更加關心的是,SSI究竟要打造出什麽樣的計畫。

新的山峰

在OpenAI工作十年後,37歲的Ilya對創業愈加充滿熱情。

他認為,全新的創業計畫是非常有意義的,因為發現了一座與之前工作,略有不同的山峰。

去年,作為OpenAI非盈利母公司董事會成員,他曾參與投票,決定罷免Sam Altman,理由便是「溝通破裂」。

幾天後,他又改變了決定。

一起與幾乎所有OpenAI員工一起簽署了聯名信,要求Altman回歸和董事會辭職。

但這一系列事件,削弱了Ilya在OpenAI的角色。先是被移出董事會,然後在今年5月離職OpenAI。

Ilya離職後,OpenAI解散了他的「超級對齊」團隊。該團隊致力於確保AI與人類價值觀保持一致,以為AI超越人類智慧的那一天做準備。

因此,與OpenAI出於AI安全考慮,而采用的公司結構不同(這使得Altman罷免成為可能),SSI采用了傳統的盈利性結構。

SSI對招聘的人才,也提出了一定的要求——必須與公司文化理念契合。

Gross表示,他們花費數小時評估候選人是否具有「良好品格」,並尋找具有非凡能力的人,而不過分強調AI領域的資歷和經驗。

他補充道,當我們找到對工作感興趣,而不是對場景、炒作感興趣的人時,才最令人興奮。

算力候選

在算力方面,SSI計劃與雲服務提供商,以及芯片大廠合作,來滿足計算能力的需求。

不過現在,他們尚未決定與哪些公司展開合作。

一直以來,OpenAI、 xAI 等初創公司都與微軟、輝達等公司合作,來滿足對基礎設施的需求。

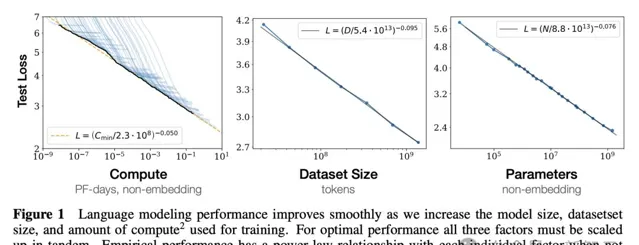

作為大模型Scaling的早期倡導者,Ilya認為AI模型效能,與算力的提升呈正比 。

正是這個想法施展,引發了AI在芯片、數據中心和能源方面的投資浪潮,為ChatGPT這樣的生成式AI進步,奠定了基礎。

與眾不同

創業後的Ilya對Scaling Law有了不同的看法,並表示,他們將以不同於OpenAI的技術來處理Scaling,但並未透露出細節。

現在,他更願將其稱之為「Scaling Hypothesis」。

每個人都只是在說Scaling Hypothesis,卻都忽略了要問:我們在Scaling什麽?

有些人可以工作很長時間,他們只是沿著同一條路走得更快。這不太符合我們的風格。但如果你正做一些不同的事情,那麽就有可能做出一些特別的事情。

更遠的暢想是,未來一些人可能會與AI合並。

幾年前,Ilya在一期播客采訪中預測,與AGI互動可能幫助我們更好地觀察世界,並認識提升自己。

隨著世界的變化,一些人可能會選擇與AI合並,以便理解這些變化,並去解決一些棘手的問題。

人類與AI合並的這個問題,也只有Ilya能回答。

「安全超級智慧」的時代來了

超級智慧,如何安全?看似一個矛盾的話題,Ilya團隊如何實作?

所謂「安全的超智慧」,意味著AI有著驚人的智慧,但不會被「天網接管」。

想象一下,一個如此強大的AI,它可以應對氣候變遷、治愈癌癥……並將人類視為真正的問題。這可不是我們想要的未來,對吧?

至於SSI,他們表示自己將安全放在了首位。這裏沒有「快速行動和打破常規」,一切都是關於「和平擴充套件」。就像訓練你的狗:在放它出門之前,首先教會它遵守規矩。

但問題在於,構建安全超智慧就像試圖訓練霸王龍使用茶杯,技術障礙巨大。其中就有我們熟知的「對齊問題」——確保AI的目標與我們的目標一致。你懂的 ,就是「不要淪陷人類」那件事。

那麽,SSI是遊戲規則改變者還是只是一個幻想?只有時間會告訴我們。但他們對安全的承諾以及與其他研究人員的合作,可以說是AI世界中的一股「清流」。

誰知道呢,也許他們就是最終破解程式碼,並開啟AI黃金時代的人。

順便,可以隨時關註一下事情的進展,沒準還可以藉此提升與機器人談判技巧(以防萬一)。