GPT模型在持續叠代過程中,能力持續增強,算力需求同樣也呈幾何倍增長。

現階段的 ChatGPT 是在擁有 3000 億個單詞的語料基礎上預訓練擁有 1750 億參數的模型。

據 OpenAI 測算,2012 年以來全球頭部 AI 模型訓練算力需求 3-4 個月翻一番,每年頭部訓練模型所需算力增長振幅高達 10 倍,遠超莫耳定律的增長速度。

據 IDC 預測, 預計到 2025 年,中國數據圈將增長至 48.6ZB,占全球數據圈的 27.8%,成為全球最大的數據圈。

AI 大算力的高需求將提升伺服器效能,AI 伺服器需搭載多個 CPU 和 GPU 處理器,同時伺服器 CPU效能不斷升級,要求記憶體技術同步升級。

DDR5、HBM、CXL、NVLink 等新興技術有望加速滲透,並充分受益於 AI 帶來的算力需求增長。

AI 伺服器

伺服器一般可分為通用伺服器、雲端運算伺服器、邊緣伺服器、AI伺服器等型別。

AI伺服器專為人工智慧訓練和推理套用而設計,大模型帶來算力的巨量需求,有望進一步推動AI伺服器市場的增長。其中,訓練任務對伺服器算力要求較高,需要訓練型伺服器提供高密度算力支持,典型產品有中科曙光X785-G30和華為昇騰Atlas 800(型號9000、型號9010)。

一個典型的人工智慧伺服器的 DRAM 容量是普通伺服器的 8 倍,NAND 容量是普通伺服器的 3 倍。

根據IDC數據, 2022年全球AI伺服器市場規模202億美元,同比增長29.8%,占伺服器市場規模的比例為16.4%,同比提升1.2pct。

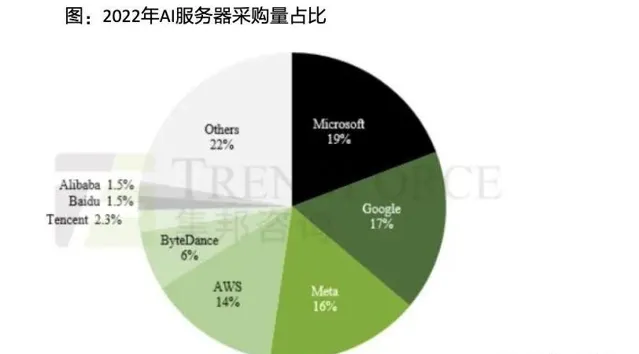

TrendForce集邦咨詢統計,2022年AI伺服器采購占比以北美四大雲端業者Google、AWS、Meta、Microsoft合計占66.2%為最,而中國近年來隨著國產化力道加劇。

國內AI伺服器頭部廠商包括:浪潮資訊、超融合、紫光股份(新華三)、中興通訊、中科曙光、工業富聯等。

資料來源:TrendForce

根據 TrendForce,2023 年 ChatGPT 相關套用有望再度刺激 AI 相關領域,預計 2023 年出貨量增長率可達8%,2022-2026 年復合成長率將達 10.8%。

01

DDR5: 新一代記憶體介面芯片

海量數據對儲存的需求持續推動記憶體介面芯片量價齊升和市場高速擴容。持續受益於伺服器出貨量增長和單台伺服器記憶體模組用量不斷上升。

記憶體介面是伺服器 CPU 與記憶體橋梁,當前正迎來DDR5 升級。

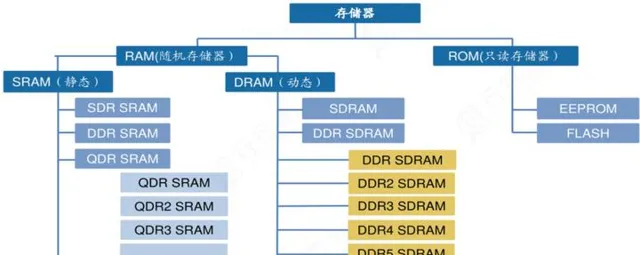

從儲存的分類看,儲存主要可分為RAM(隨機記憶體)和ROM(唯讀記憶體)。

RAM可分為SRAM(靜態隨機記憶體)和DRAM(動態隨機記憶體)。SDRAM(同步動態隨機存取記憶體)是在DRAM的基礎上發展而來,為DRAM的一種。

DDR SDRAM(雙倍速率同步動態隨機記憶體)又在SDRAM的基礎上發展而來,為具有雙倍傳輸率的SDRAM,其數據傳輸速度為系統時脈的兩倍,由於速度增加,其傳輸效能優於傳統的SDRAM。

DDR SDRAM經歷了DDR2、DDR3、DDR4等幾代技術更叠,其差異性主要體現記憶體的電源電壓值越來越低,而數據傳輸速率卻是呈幾何倍數增長,同時儲存容量也隨之大幅增加。

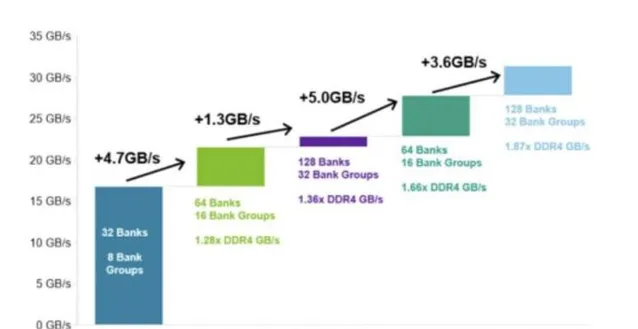

DDR5 記憶體效能遠超 DDR4 的規格上限,配套記憶體介面芯片效能及技術難度隨之提升。根據市場調研機構推測,DDR5 已占據整個 DRAM 市場份額的 10%,2024年則將進一步擴大至 43%。

伺服器市場對高效能有著絕對的需求,可能最先推廣DDR5。隨著新一代DDR產品的升級,記憶體介面芯片有望迎來量價齊升,DRAM市場有望開啟新一輪增長。

數據來源:EEtop

記憶體介面芯片行業壁壘高,競爭格局相對較好。

國內瀾起科技正在拓展津逮@伺服器平台&PCIe Retimer 和 AI 芯片產品線;聚辰股份SPD 受益於算力需求增加及 DDR5 升級。SPD 用於伺服器等領域,受益於算力需求增加及 DDR5 升級。

聚辰和瀾起科技合作開發配套新一代 DDR5 記憶體條的 SPD 產品,該產品系列內建 SPD EEPROM,系 DDR5 記憶體模組不 可或缺元件。

02

HBM:為大算力芯片提供支撐

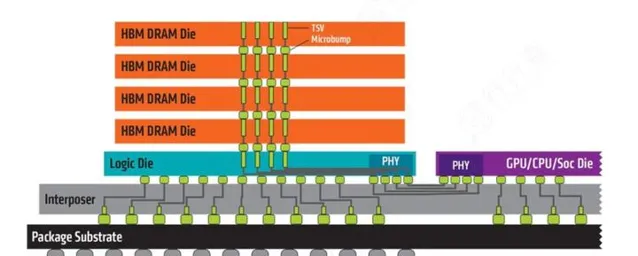

高頻寬記憶體(HBM)是一款新型的CPU/GPU 記憶體芯片,透過將多個DDR芯片堆疊在一起,實作大容量,高位寬的DDR組合陣列。

HBM可支持更高速率的頻寬,並實作高於256GBps 的突破性頻寬,單顆粒的頻寬遠超過DDR4 和GDDR6。HBM將為大算力芯片提供能力支撐,同時生成類模型也會加速 HBM記憶體進一步增大 容量和增大頻寬。

如今搭載於新興AI套用的記憶體芯片亟待升級,這種設計能夠大大提升資訊交換的速率。

資料來源:AMD

從競爭格局來看, 全球範圍內,HBM2記憶體核心廠商主要包括SK海麗仕、三星、Altera、英特爾和超微半導體等。

全球第一梯隊廠商主要有SK海麗仕、三星、Altera和英特爾;第二梯隊廠商有超微半導體和美光。

海麗仕HBM技術起步早,占據較大市場,2018年釋出HBM2,2021年釋出全球首款HBM3,目前在研HBM4。三星從HBM2開始布局,2016年量產HBM2,2021年2月,三星電子推出了HBM-PIM(存算一體),將記憶體半導體和AI處理器合二為一,2022年HBM3已量產。

國內布局廠商中, 通富微電在Chiplet、WLP、SiP、Fanout、2.5D、3D堆疊等方面均有布局和儲備;深科技是國內最大的獨立DRAM記憶體芯片封測企業,全球第二大硬碟磁頭制造商 , 全資子公司沛頓科技封裝技術包括 wBGA/FBGA 等,具備先進封裝 FlipChip/TSV 技術(DDR4 封裝)能力;長電科技具有高整合度的晶圓級WLP、2.5D/3D、系統級(SiP)封裝技術和高效能的Flip Chip和引線互聯封裝技術;兆易創新是國記憶體儲龍頭,是國內技術最為先進的儲存廠商,NORFlash、NAND Flash及MCU為主要產品的業務板塊。

TrendForce 預估 2023-2025 年 HBM 市場年復合成長率有望成長 至 40-45%以上。

03

CXL:儲存芯片界的CPO

隨著儲存成本不斷增加,傳統的PCI-e技術逐漸乏力。

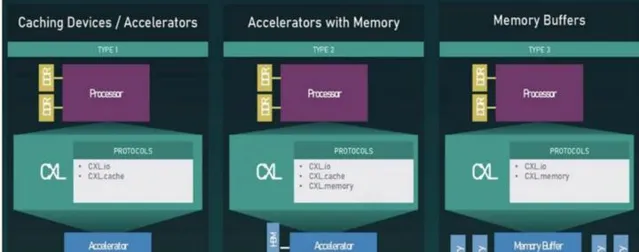

在此背景下,基於PCI-e協定的CXL技術應運而生。CXL全稱為ComputeExpressLink,是由英特爾於2019年3 月在 Interconnect Day 2019 上推出的一種開放性互聯協定,能夠讓 CPU 與 GPU、FPGA 或其 他加速器之間實作高速高效的互聯,從而滿足高效能異構計算的要求。

快速成長的人工智慧(AI)與機器學習(ML)新興任務,持續激增的雲端運算以及網路和邊緣的「雲端化」將成為推動CXL發展的重要因素之一。CXL技術用途:

資料來源:CXL Consortium

CXL聯盟董事會成員包括Intel、Google、IBM、Facebook等科技巨擘,發起者Intel擁有80%伺服器CPU市場份額。

CXL聯盟成員:

根據TrendForce,CXL匯入將隨著未來CPU內建CXL功能而普及化。

同時CXL建立數據高速互聯性的優點,有助於擴充套件AI算力,未來AI伺服器將能見到更多采用CXL的設計。

瀾起科技推出首款支持CXL的MXC芯片並研發支持CXL的PCIe Retimer芯片。

美光科技在 22 年 5 月與投資者交流 時曾預測 CXL 相關產品的市場規模,到 2025 年預計將達到 20 億美金,到 2030 年 可能超過 200 億美金。

04

NVLink:芯片互連技術

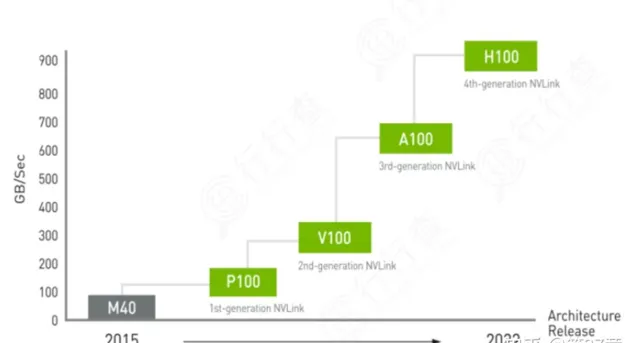

NVLink 是為了解決伺服器內部 GPU 之間點到點通訊的一種協定。

輝達在2023年美國消費電子展(CES)上,釋出了數據中心專屬CPU——「Grace CPU超級芯片」。該芯片由兩顆CPU芯片組成,其間透過NVLink-C2C技術進行互連。

NVLink-C2C技術是一種新型的高速、低延遲、芯片到芯片的互連技術,可最大化提升系統吞吐量。與Chiplet技術有異曲同工之妙,可支持客製裸片與GPU、CPU、DPU、NIC、SoC實作互連。

第四代 NVIDIA® NVLink®技術可為多 GPU 系統 配置提供高於以往 1.5 倍的頻寬,以及增強的可延伸性,進而實作超快速的深度學習訓練。

隨著模型參數數量增大,訓練所需要算力不斷增長,輝達有望進一步鞏固公司龍頭 地位。

國內廠商浪潮推出的NF5688M6是新一代NVLink AI 伺服器,在超大規模數據中心研發的同時擁有高效能,高相容,強擴充套件效能。 在6U空間內支持2顆Intel最新的Ice Lake CPU和8顆NVIDIA最新的NVSwitch全互聯 A800 GPU,結合AI算力資源排程平台AIStation,能夠釋放強大AI計算效能。

隨著人工智慧、機器學習、高效能計算、數據中心等套用市場的興起,記憶體產品設計的復雜性正在快速上升,並對頻寬提出了更高的要求。

海量的算力數據和不斷上升的寬頻需求持續驅動人工智慧新技術發展。