来源:FAIR 编辑:yaxin, LQ

【新智元导读】马斯克坚信,世界只是「矩阵模拟」!他用自己推崇的思维模式「第一性原理」来思考这个物理世界。近日,Facebook科学家Sho Yaida撰写的一书从「第一性原理」解释了深度神经网络。LeCun表示,这是首批致力于DL理论的书。

还记得马斯克常常挂在嘴边的「第一性原理」吗?

简之,追本溯源。

人工智能的无限发展,以及我们对量子物理的不断认识,让我们不断怀疑自己生存的世界。

马斯克坚信,世界只是「矩阵模拟」,我们都生活在这个模拟中。

一次访谈中他表示,「神经网络主要是从现实中获取大量信息,很多来自无源光学方面,并创建矢量空间,本质上将大量光子压缩成矢量空间。」

至今,人们还无法从理论层面解释神经网络的「第一性原理」。

如大脑神经元一样,神经网络复杂而无法从基本原理中理解。

这个难题,有人已帮你解决。

Facebook 人工智能研究中心(FAIR)的科学家Sho Yaida撰写了一本关于如何从「第一性原理」来理解深度神经网络(DNN)的书籍。

这本书名为 The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks ,将于2022年初由剑桥大学出版社出版,手稿现在已经公开。

△ 自取地址:https:// arxiv.org/pdf/2106.1016 5.pdf

本书序言开篇引用了量子力学的奠基人、诺贝尔物理学奖得主狄拉克在【量子力学原理】一书序言中的一句话:

This has necessitated a complete break from the historical line of development, but this break is an advantage through enabling the approach to the new ideas to be made as direct as possible.(这就需要完全脱离历史的发展路线,但这种脱离是一种优势,因为它使人们能够尽可能直接地接近新的思想。)

另辟蹊径?这本书要告诉我们什么?

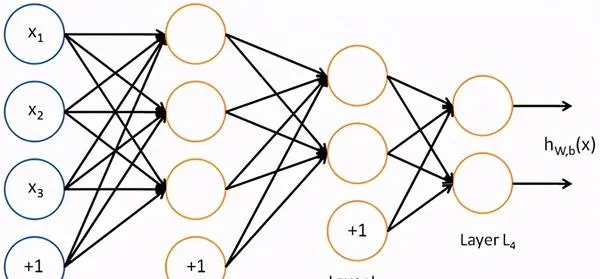

相互作用的神经元

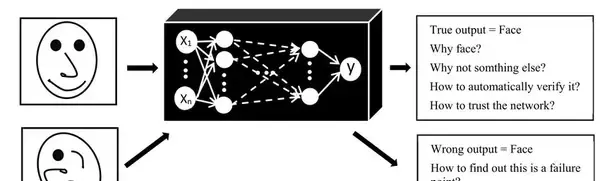

深度神经网络是现代 AI 研究的重要组成部分,但它们或多或少被视为「黑匣子」。

虽然人工智能从业者取得了实质性进展,但 DNN 通常被认为太复杂而无法从基本原理来理解。

对于他们来讲,这种理解可以大大减少训练DNN所需的试错次数。

比如,它可以揭示任何给定模型的最佳超参数,而无需经过当今所需的时间和计算密集型实验。

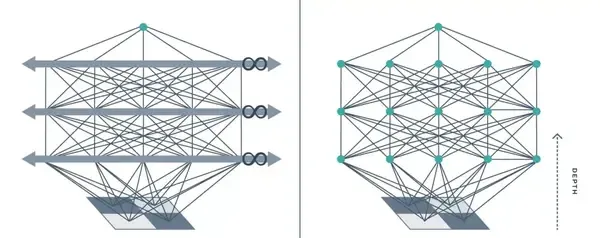

到目前为止,试图理解 DNN 的理论家通常依赖于对此类网络的理想化,即所谓的「无限宽度」限制。

其中,DNN 以每层无限数量的神经元进行建模。

从物理学家的角度解决这个问题,The Principles of Deep Learning Theory 通过在有限宽度上提出有效的 DNN 理论,改进了这个无限宽度的限制。

用物理学的语言来说,这意味着对单层和跨层神经元之间的微小相互作用进行建模。

想象两个台球向着对方前进。

如果你使用类似于无限宽度限制的非交互模型来计算将要发生的事情,就会发现球会相互穿过并继续朝同一方向前进。

但事实并非如此。

球中的电子不能占据相同的空间,因此它们会相互作用碰撞弹跳。

这些相互作用在现实生活中很重要,在物理学中很重要,对 DNN 同样如此。

无限宽度导致神经元的相互作用可能性降低,只有有限宽度才提供神经元碰撞的上下文。

△ 训练DNN示例

考虑到神经元之间的类似相互作用,该书的理论发现:

DNN 的真正威力——它们从数据中学习世界表征的能力——与其纵横比(即深度与宽度之比)成正比。

对于无限宽度模型,该比率为零,因此这些玩具模型无法捕捉深度,并且随着 DNN 深度的增加,它们的描述变得越来越不准确。

相比之下,使用有限宽度层,有效理论实际上会影响深度——这对于表征学习和DNN的 D 真正重要的其他应用至关重要。

通过第一性原理理解DNN

虽然书中描述的框架可以扩展到现代人工智能社区使用的现实世界DNN,并为此提供了一个蓝图,但书本身主要侧重于用于教学目的、最简单的深度学习模型(深度多层感知器) 。

应用于这种最简单的结构,可以系统地求解有效理论方程。这意味着可以对整个训练轨迹的DNN行为有一个「第一性原理理解」。

尤其是我们可以明确地写下一个完全训练的 DNN 所计算的函数,来对新的测试例子做出预测。

有了这个新的有效的理论,我们希望理论家能够推动对神经网络的更深入和更完整的理解。虽然还有很多计算工作等待完成,但是这项工作可能会使这个领域更加接近于理解让模型运行的是哪些特定属性。

研究人员也希望这本书将帮助人工智能社区减少时而出现的限制当前进展的试错周期。希望帮助从业者迅速设计出更好的模型——更高效、性能更佳、训练更快,或者同时具备所有这些优点。

特别是那些DNN不用任何训练就能够挑选最佳的超参数,并为实现最佳结果选择最佳算法和模型结构。

这些问题多年来一直被认为无法回答或解释。本书证明了人工智能并不是一门无法解释的艺术,实用的人工智能可以通过基本的科学原则来理解。

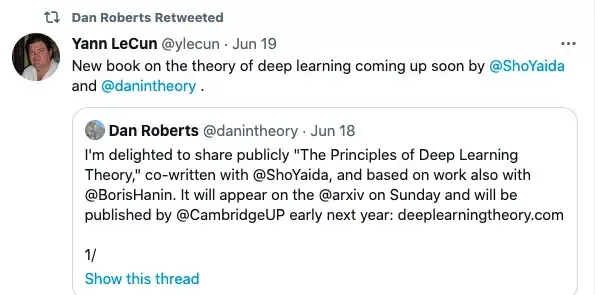

LeCun为同事站台

Facebook VP,首席AI科学家的LeCun也来为同事的新书站台,他说:在科学技术史上,工程实践结果往往首当其冲: 望远镜、蒸汽机、数字通信。而解释其功能和局限性的理论往往出现在后面: 折射定律、热力学定律和信息理论。

随着深度学习的出现,以人工智能为动力的工程奇迹进入了我们的生活,但我们对深度学习的力量和局限性的「理论认识」仍然是片面的。这是首批致力于深度学习理论的书籍之一,本书以连贯的方式列出了近期理论方法和结果。

近年来实证研究的结果将人工智能推向了新的高度,尽管如此我们仍坚信,建立在理论基础上的实践能帮助加速人工智能研究,并可能导致目前无法想象的新领域的出现,正如一个多世纪以前统计力学导致了信息时代的到来一样。

作者介绍

本书由Daniel A. Roberts和Sho Yaida所写,另外还有研究合作者Boris Hanin。

Sho Yaida是Facebook AI的研究科学家,研究方向是将理论物理学方法应用于理解神经网络的实际利益。

加入FAIR之前,他在斯坦福大学攻读博士学位时,主要研究黑洞;

而在MIT和杜克做博后研究期间,他又转向了有关玻璃的物理学研究上。

△ 个人主页 https:// ai.facebook.com/people/ sho-yaida/

这本书的共同作者还有Dan Roberts,FAIR前研究科学家。

目前,他是麻省理工学院理论物理中心的研究员,也是Salesforce的首席研究员,同时还是美国国家科学基金会人工智能与基础互动研究所(IAIFI)的成员。

研究方向集中于如何将理论物理学的工具和观点应用到人工智能中。

参考资料:

https:// ai.facebook.com/blog/ad vancing-ai-theory-with-a-first-principles-understanding-of-deep-neural-networks/

—完—

欢迎点赞~ 关注 新智元 及时了解人工智能新动态~