我在其他评论中说过,绝大多数人没有真正玩过激光雷达,更别提用激光雷达解决工程问题。

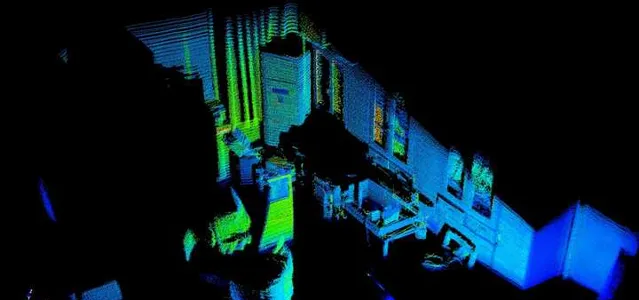

下图是刚刚用激光雷达扫的一张办公室点云图,你能看出来我办公室有什么吗?估计能看出来有一个空调柜机,似乎有个桌子,桌子上好像放了些什么东西。你能分辨出来空调柜机是什么牌子吗?能看出来空调现在启动没有?我不告诉你的话,你能知道我的窗帘上面有什么图案吗?

这是一台400线激光雷达扫描出来的点云图,这台雷达价值4万5。你愿意花这个钱装在你的汽车上吗?

有人肯定要说,现在车载激光雷达几千块而已。当然了,几千块也能买来,32线或者充其量64线的。那么,现在我把这张图里的点云仅仅保留十分之一,你还能分辨出来我办公室里的桌子吗?更不要说,我的办公室很小,所以以扇形方式扫描的激光点云还很密集。放在户外,几十米外的物体所形成的点云会更加稀疏。

这个雷达不仅贵,上电后还会嗡嗡嗡直想,吵得脑瓜疼。为什么不能安静一点?因为里面有微振镜,那玩意是个机械运动部件,以非常高的速率上下左右扫描。任何做过工程的人都会想到,机械运动部件意味着机械磨损和可靠性低,至少与完全没有运动部件的相机相比。

即使这么贵,这么重,这么精密,它最多也就是10个FPS,即每100ms完成一帧扫描。一辆120km/h的汽车在这个时间内能够移动3.33m。更糟糕的是,它是以扫描方式获得点云,因此汽车的移动造成点云中不同区域并不同步。与之相比较,我常用的双目相机在1920*1080分辨率条件下能够以30FPS速率输出点云图和RGB图像,分辨率升高到2208*1242时速率为15FPS。这台相机3000出头吧,而且跟车载相机的精度差距应该不小。

我的空调旁边是柜子,上面有玻璃窗。你大概注意到了,一部分玻璃窗看上去是纯黑色的,因为激光被玻璃镜面反射走了,没有反射到雷达中,所以雷达没法识别透明的、镜面反射的物体。

现在给你一张仅有上面那张图十分之一点云密度的点云图,然后告诉你,你的汽车严重依赖于这个人眼都看不大清楚的点云图保障自动驾驶安全,你的感觉如何?

当然了,你会说激光雷达要和视觉相融合。Talk is cheap!请问,你怎样把两种传感器数据对同一场景所生成的数据融合在一起?

你可以求平均,或者加权平均,但是权值怎么取?

你可以说,只要激光雷达认为路面有危险,那就立刻停止驾驶。那么天上如果下起大雪,雪花反射产生大量错误激光点云,你的自动驾驶还能用吗?

你说,现在有神经网络了,把原始数据送进去训练就好了。事情要是这么简单,那自动驾驶早都成功了。

很多人在嘲笑这一段,那我们展开一下

数据融合本质上就是多种信息源的加权平均而已(假设数据已经对齐)。经典的卡尔曼滤波器,算了半天的卡尔曼增益,不就是一个权值矩阵嘛。神经网络本质上也是一个巨大的权值矩阵,从原始数据中提取特征,用权值组合。

核心难点是权值怎么定。经典方法本质上就是基于先验知识调超参数,比如卡尔曼滤波器里面的协方差阵,最终还是靠人工调参。

神经网络依靠学习逐渐计算权值,对先验知识的依赖并没有改变,这些先验知识包括超参数设置,数据标签,学习样本,只是看上去更隐蔽一些。

我们把这个问题简化一下:

假设对同一个事件,有两个传感器获得了两个观测结果,A和B。假设它们已经完全对齐,显然这是对实际情况的理想化。

我们如何把他俩融合为最终结论?

第一种方案,令C=a A + (1-a)*B

即固定权值的加权平均。卡尔曼滤波器本质上就是这样子。

你觉得这样子太糟糕了,应当区分不同情况下,两个传感器的置信度,用不同权值平均。那么,如何区分不同情况呢?

显然不可能再增加一个超越这两个传感器的更高层传感器。

你说我们要用神经网络,让ai自己学习去。

但是不论如何学习,信息源只有两个。也就是说,决定如何取信传感器,如何混合它们信息的决策层,仍然依赖这两个传感器的信息。也就是说

C=a(A,B)* A + (1-a(A,B))*B

这不就是所谓的,即使运动员,又是裁判员吗?更进一步,你该如何用A,B传感器信息计算a呢?显然还得有权值,这变成了一个递归问题,到最后,你还是得有一个固定的,来源于先验知识和人工调参的权值。

再说一点,双目相机本身就是能够测距的,跟AI没有任何关系,算法非常经典。我们甚至给空军做过基于双目视觉的对接演示试验。双目生成的点云图和图像是像素匹配的,因此你可以直接把点云图当做一个通道,和rgb通道一起送入神经网络训练。

制约双目相机的主要因素是算力,因为需要做稠密纹理匹配,放在二十年前处理一帧起码是秒级耗时。激光雷达实际上是种取巧方式,机电要求高(但可以做到),算力要求很低,数据很稀疏,信息量低。但是现在用GPU做计算,双目的更新速率和信息量远大于激光雷达。如果二十年前有GPU,自动驾驶不会走上激光雷达这条路线的。

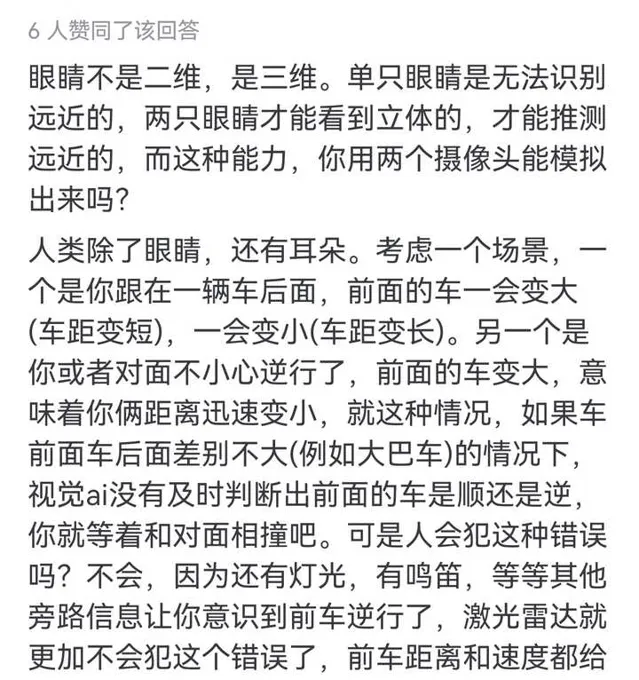

似乎很多人不知道双目相机和人眼一样具有深度检测能力

至于用蝙蝠论证的。。。的确,绝大多数我们日常能见到的蝙蝠都是依赖声纳(雷达)定位。但是有一类蝙蝠,食果狐蝠,因为总是白天出行寻找水果,则是完全依赖双目视觉。有趣的是,早期蝙蝠为了占据夜间生态位,进化出了声纳定位,但是当狐蝠演化为白昼行动后,它们又抛弃了声纳,重新拾起视觉。这恰好说明,生物更倾向于视觉感知,只有在条件不允许时(蝙蝠在暗夜捕食,海豚在昏暗的海洋中捕食),才会进化出雷达感知模式。当生态环境允许视觉时,生物会在生存竞争压力下,快速回到视觉正途上。

不止一个人用「飞机空战时用雷达而非视觉」来论证激光雷达有用,例如这位,专门@我

那么请问,雷达这么好,为什么坦克不用来搜索敌人,引导火炮瞄准设计,还要以视觉为基础对战场环境进行感知?

原因很简单,但是我要去开会了

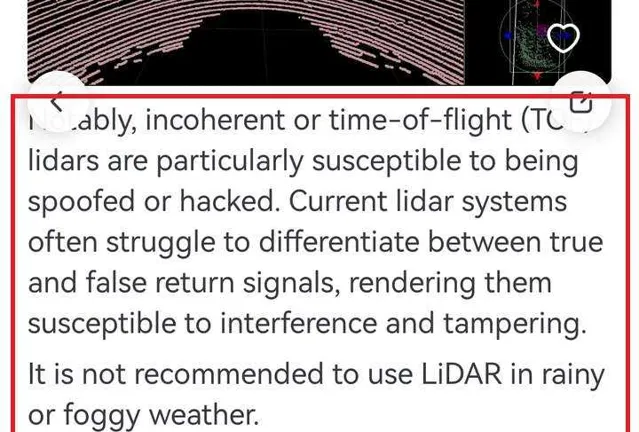

借用另一个回答中的内容,激光雷达很容易被干扰和欺骗,在雨天和雾天不推荐使用。

再参考一下SLAM大佬的帖子

马斯克的纯视觉方案对算力要求高、门槛高,激光雷达方案暂时成本稍高但门槛低,未来终极会不会是合二为一? - 袁博融的回答 - 知乎

马斯克的纯视觉方案对算力要求高、门槛高,激光雷达方案暂时成本稍高但门槛低,未来终极会不会是合二为一?

核心思想是一样的,没有真正用过激光雷达的人,才会觉得激光雷达比图像好