这两篇文章我在它们刚出来不久的时候看过。关于怎么理解这一结论(并不严格),现在已经有了许多答案。直观地看,重正化群作为一种粗粒化的方法,与深度学习网络各层提取信息有些类似之处,现在已经有很多答案提到对这一问题的理解,我就不再继续赘述。

不过我想简单地从生物物理和复杂系统的角度说说这一结论可能产生的影响,可能显得有些脑洞大开,但其实我自己最近一段时间一直在做相关的问题,所以这个也并没有那么脑洞大开。先一句话总结一下我的结论: 这个研究对某些特殊情况下深度学习的工作原理进行了解释,但这一解释对深度学习技术本身的发展可能并没有太大的作用,反而可能对我们理解大脑的工作原理有一定的意义。

我本来以为这只是我自己一个人的看法,然后在网上搜索的时候突然发现早就有其他人有类似的看法,我还是先引用其他人在阅读了这两篇论文之后的观点吧:

For example, the finding appears to support the emerging hypothesis that parts of the brain operate at a 「critical point,」 where every neuron influences the network as a whole. In physics, renormalization is performed mathematically at the critical point of a physical system, explained Sejnowski, a professor at the Salk Institute for Biological Studies in La Jolla, Calif. 「So the only way it could be relevant to the brain is if it is at the critical point.」——Deep Learning Relies on Renormalization, Physicists Find

有兴趣的朋友可以去阅读上面的两个链接中的详细内容。这里我仅对这个观点具体的意思进行一个比较简单的阐述:

「临界性」对我们的大脑在解决问题时究竟可以提供哪些帮助呢?首先的一种解释就是从类似自组织临界的角度来说的,大脑类似于处在临界态的沙堆,一些较小的扰动就可能形成较大范围的雪崩现象,大脑的信号发放也会出现类似的情况,如果记录一小块区域内的神经信号发放,大多数时候只能观察到局部的激发,但仍然有时候可以观察到一大片的神经元被激活,并且被激活的区域的尺寸统计分布是满足幂律分布的。这就非常类似于地震、雪崩,因此认为大脑是处在临界态。关于这个问题还有一些新闻报道,如:「

译言网 | 无序的天才:大脑中如何产生混沌?」「

大脑雪崩现象有助于储存记忆」就简单介绍了有关的生物背景。

另一层解释则更类似于传统研究相变的思路,直接从关联函数出发,因为观察到雪崩现象(以及雪崩事件的统计)并不能严格地导出大脑里神经元的连通状态,甚至连关联的情况也不能得到。从物理学的角度来说,我们显然更希望直接测量大脑(或者大脑里面某个区域内)的「关联函数」,如果我们发现如前面我所补充的,发现关联长度与体系尺寸成正比,这也就说明了大脑是是处在「临界态」的。

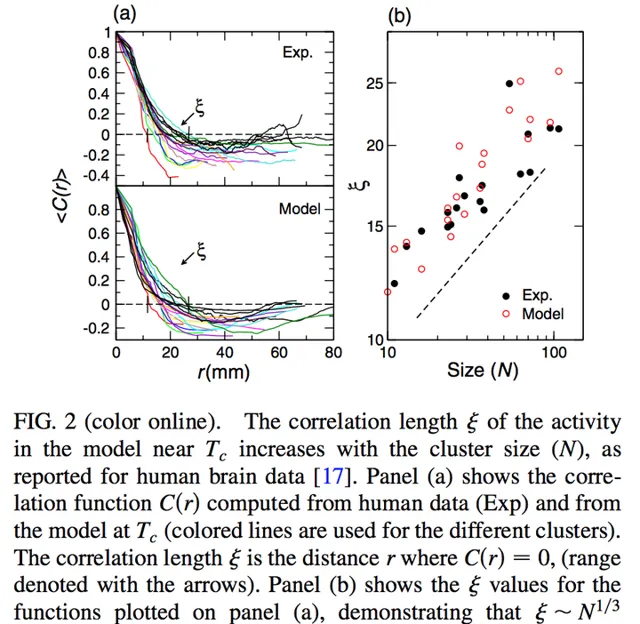

如图,现在我们可以对大脑中的一些涨落关联进行研究 (Ariel Haimovici, Enzo Tagliazucchi, Pablo Balenzuela, and Dante R. Chialvo Phys. Rev. Lett. 110, 178101)。如果说全脑的上图是对大脑中的一些 Cluster 进行的 scaling。按我的理解,尽管可能大脑中存在一些长程的相互作用,但针对某些具体的 Cluster,这种效应应该是相对比较小的。从中可以看到某种尺度不变性(所选择的 cluster size 与关联长度粗略地成正比)。

在这个意义上,我们可以再看看其他物理学家对「临界的大脑」这一问题的看法:

Furthermore, a brain not only has to remember, but also has to forget and adapt. In a subcritical brain, memories would be frozen. In a supercritical brain, patterns change continuously so no long-term memory would be possible. To be highly susceptible, the brain itself has to be in an in-between, critical state.——Dante Chialvo. Nature Physics 6, 744–750 (2010) doi:10.1038/nphys1803

因此在我看来,这类研究真正的意义在于——它可能暗示了生物系统(大脑)解决这一问题的某种方案,需要注意的是:这种方案并不是最适合计算机的,正如

@齐鹏所提到的,在实际应用中,工业界通常会选择一个各层次形如 100-400-400-400-10 的 over-complete 网络来解决问题,这种方法是适合计算机的方案,但并不是重正化群,更不太可能是大脑的解决方案。在经过了长期的进化之后,大脑通过把自己调整到某个临界态,能够在很多自然界的约束条件下找到优化的解决方案(例如大脑运转时消耗的能量就远低于计算机),并且能具有超强的适应性。

另外一个值得一提的问题在于——为什么关注的是无监督学习,这里可以参考

Facebook AI Director Yann LeCun on His Quest to Unleash Deep Learning and Make Machines Smarter访谈中的观点(中文翻译版节选自【中国计算机学会通讯】上发表的翻译稿):

但从研究的角度来看,我们一直感兴趣的是如何恰当地做好无监督学习。我们现在已经拥有了可以应用到实际的无监督学习技术,只是问题在于,我们只要收集更多数据,有监督学习就能胜过无监督学习。这就是为什么在现阶段的产业中,深度学习的应用基本上都是有监督的。但将来未必是这种方式。

归根结底,在无监督学习方面,大脑远好于我们的模型,这意味着我们的人工智能学习系统对许多生物机理学习的基本原理还没有掌握。

But from a research point of view, what we’ve been interested in is how to do unsupervised learning properly. We now have unsupervised techniques that actually work. The problem is that you can beat them by just collecting more data, and then using supervised learning. This is why in industry, the applications of Deep Learning are currently all supervised. But it won’t be that way in the future.

The bottom line is that the brain is much better than our model at doing unsupervised learning. That means that our artificial learning systems are missing some very basic principles of biological learning.

从这个意义上,我相信这个研究的意义就在于,它可能真的暗示了某种在临界点附近实现其功能的生物系统的工作机理。从这个意义上,类似

Information-based fitness and the emergence of criticality in living systems的方法如果被用到这一问题上,可能会有某些类似的结论。