來源:FAIR 編輯:yaxin, LQ

【新智元導讀】馬斯克堅信,世界只是「矩陣模擬」!他用自己推崇的思維模式「第一性原理」來思考這個物理世界。近日,Facebook科學家Sho Yaida撰寫的一書從「第一性原理」解釋了深度神經網路。LeCun表示,這是首批致力於DL理論的書。

還記得馬斯克常常掛在嘴邊的「第一性原理」嗎?

簡之,追本溯源。

人工智慧的無限發展,以及我們對量子物理的不斷認識,讓我們不斷懷疑自己生存的世界。

馬斯克堅信,世界只是「矩陣模擬」,我們都生活在這個模擬中。

一次訪談中他表示,「神經網路主要是從現實中獲取大量資訊,很多來自無源光學方面,並建立向量空間,本質上將大量光子壓縮成向量空間。」

至今,人們還無法從理論層面解釋神經網路的「第一性原理」。

如大腦神經元一樣,神經網路復雜而無法從基本原理中理解。

這個難題,有人已幫你解決。

Facebook 人工智慧研究中心(FAIR)的科學家Sho Yaida撰寫了一本關於如何從「第一性原理」來理解深度神經網路(DNN)的書籍。

這本書名為 The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks ,將於2022年初由劍橋大學出版社出版,手稿現在已經公開。

△ 自取地址:https:// arxiv.org/pdf/2106.1016 5.pdf

本書序言開篇參照了量子力學的奠基人、諾貝爾物理學獎得主狄拉克在【量子力學原理】一書序言中的一句話:

This has necessitated a complete break from the historical line of development, but this break is an advantage through enabling the approach to the new ideas to be made as direct as possible.(這就需要完全脫離歷史的發展路線,但這種脫離是一種優勢,因為它使人們能夠盡可能直接地接近新的思想。)

另辟蹊徑?這本書要告訴我們什麽?

交互作用的神經元

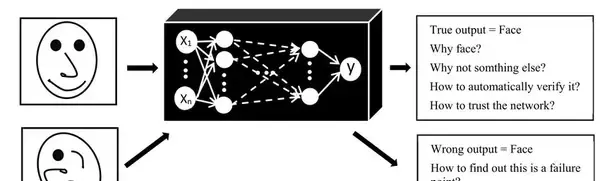

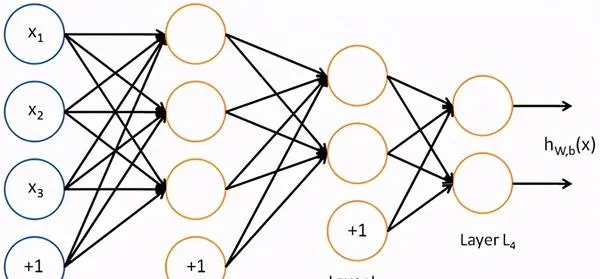

深度神經網路是現代 AI 研究的重要組成部份,但它們或多或少被視為「黑匣子」。

雖然人工智慧從業者取得了實質性進展,但 DNN 通常被認為太復雜而無法從基本原理來理解。

對於他們來講,這種理解可以大大減少訓練DNN所需的試錯次數。

比如,它可以揭示任何給定模型的最佳超參數,而無需經過當今所需的時間和計算密集型實驗。

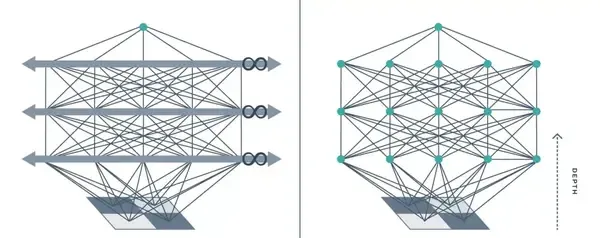

到目前為止,試圖理解 DNN 的理論家通常依賴於對此類網路的理想化,即所謂的「無限寬度」限制。

其中,DNN 以每層無限數量的神經元進行建模。

從物理學家的角度解決這個問題,The Principles of Deep Learning Theory 透過在有限寬度上提出有效的 DNN 理論,改進了這個無限寬度的限制。

用物理學的語言來說,這意味著對單層和跨層神經元之間的微小交互作用進行建模。

想象兩個撞球向著對方前進。

如果你使用類似於無限寬度限制的非互動模型來計算將要發生的事情,就會發現球會相互穿過並繼續朝同一方向前進。

但事實並非如此。

球中的電子不能占據相同的空間,因此它們會交互作用碰撞彈跳。

這些交互作用在現實生活中很重要,在物理學中很重要,對 DNN 同樣如此。

無限寬度導致神經元的交互作用可能性降低,只有有限寬度才提供神經元碰撞的上下文。

△ 訓練DNN範例

考慮到神經元之間的類似交互作用,該書的理論發現:

DNN 的真正威力——它們從數據中學習世界表征的能力——與其長寬比(即深度與寬度之比)成正比。

對於無限寬度模型,該比率為零,因此這些玩具模型無法捕捉深度,並且隨著 DNN 深度的增加,它們的描述變得越來越不準確。

相比之下,使用有限寬度層,有效理論實際上會影響深度——這對於表征學習和DNN的 D 真正重要的其他套用至關重要。

透過第一性原理理解DNN

雖然書中描述的框架可以擴充套件到現代人工智慧社群使用的現實世界DNN,並為此提供了一個藍圖,但書本身主要側重於用於教學目的、最簡單的深度學習模型(深度多層感知器) 。

套用於這種最簡單的結構,可以系統地求解有效理論方程式。這意味著可以對整個訓練軌跡的DNN行為有一個「第一性原理理解」。

尤其是我們可以明確地寫下一個完全訓練的 DNN 所計算的函式,來對新的測試例子做出預測。

有了這個新的有效的理論,我們希望理論家能夠推動對神經網路的更深入和更完整的理解。雖然還有很多計算工作等待完成,但是這項工作可能會使這個領域更加接近於理解讓模型執行的是哪些特定內容。

研究人員也希望這本書將幫助人工智慧社群減少時而出現的限制當前進展的試錯周期。希望幫助從業者迅速設計出更好的模型——更高效、效能更佳、訓練更快,或者同時具備所有這些優點。

特別是那些DNN不用任何訓練就能夠挑選最佳的超參數,並為實作最佳結果選擇最佳演算法和模型結構。

這些問題多年來一直被認為無法回答或解釋。本書證明了人工智慧並不是一門無法解釋的藝術,實用的人工智慧可以透過基本的科學原則來理解。

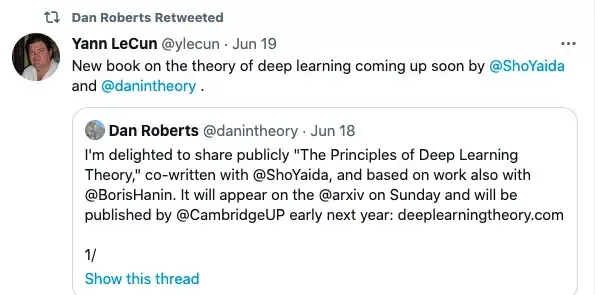

LeCun為同事月台

Facebook VP,首席AI科學家的LeCun也來為同事的新書月台,他說:在科學技術史上,工程實踐結果往往首當其沖: 望遠鏡、蒸汽機、數位通訊。而解釋其功能和局限性的理論往往出現在後面: 折射定律、熱力學定律和資訊理論。

隨著深度學習的出現,以人工智慧為動力的工程奇跡進入了我們的生活,但我們對深度學習的力量和局限性的「理論認識」仍然是片面的。這是首批致力於深度學習理論的書籍之一,本書以連貫的方式列出了近期理論方法和結果。

近年來實證研究的結果將人工智慧推向了新的高度,盡管如此我們仍堅信,建立在理論基礎上的實踐能幫助加速人工智慧研究,並可能導致目前無法想象的新領域的出現,正如一個多世紀以前統計力學導致了資訊時代的到來一樣。

作者介紹

本書由Daniel A. Roberts和Sho Yaida所寫,另外還有研究合作者Boris Hanin。

Sho Yaida是Facebook AI的研究科學家,研究方向是將理論物理學方法套用於理解神經網路的實際利益。

加入FAIR之前,他在史丹佛大學攻讀博士學位時,主要研究黑洞;

而在MIT和杜克做博後研究期間,他又轉向了有關玻璃的物理學研究上。

△ 個人主頁 https:// ai.facebook.com/people/ sho-yaida/

這本書的共同作者還有Dan Roberts,FAIR前研究科學家。

目前,他是麻省理工學院理論物理中心的研究員,也是Salesforce的首席研究員,同時還是美國國家科學基金會人工智慧與基礎互動研究所(IAIFI)的成員。

研究方向集中於如何將理論物理學的工具和觀點套用到人工智慧中。

參考資料:

https:// ai.facebook.com/blog/ad vancing-ai-theory-with-a-first-principles-understanding-of-deep-neural-networks/

—完—

歡迎點贊~ 關註 新智元 及時了解人工智慧新動態~