編輯:LRST

【新智元導讀】 視覺價值模型(VisVM)透過「推理時搜尋」來提升多模態視覺語言模型的影像描述品質,減少幻覺現象。實驗表明,VisVM能顯著提高模型的視覺理解能力,並可透過自我訓練進一步提升效能。

在現代多模態視覺語言模型(VLM)的開發中,提高影像描述的準確性和細節豐富性始終是一個挑戰。盡管基於大規模數據的訓練極大推動了模型效能,但在實際套用中,模型仍面臨辨識細微影像區域和減少「幻覺」現象的問題。

推理時搜尋(inference time search)作為一種提升響應品質的有效方法,已在大型語言模型中展現出巨大潛力。

O1和 QwQ 等大語言模型透過在推理階段在語言空間中進行搜尋得到更好的回答,在數學和程式碼等任務中展現了遠超越其他模型的卓越效能。

那麽,我們能否同樣透過推理時搜尋來提升多模態視覺語言模型的響應品質,並減少響應中的幻覺呢?答案是是的。

來自馬里蘭大學和微軟的研究團隊提出了視覺價值模型(Vision Value Model, VisVM),透過精確控制搜尋過程來顯著提高模型在視覺任務中的表現。

論文地址: https://arxiv.org/abs/2412.03704

計畫頁面: https://si0wang.github.io/projects/VisVM/

計畫程式碼: https://github.com/si0wang/VisVM

VisVM是一種 價值網路 ,可以透過對逐步生成描述性標題提供獎勵訊號來指導視覺語言模型(VLM)在推理時的搜尋。

模型訓練

VisVM首先使用VLM自身生成多個多樣化的響應,並將這些響應按照句子維度拆分成<current sentence,next sentence>的sentence pair。

對於每一個current sentence使用CLIP model計算這句話和對應影像的cosine similarity作為reward,最後構成< current sentence, reward,next sentence, Image>的四元組作為VisVM的訓練數據。

VisVM使用強化學習中的時序差分學習(Temporal Difference learning)作為損失函式進行訓練。這使得VisVM不僅可以評估當前句子與影像之間的匹配程度,還可以預測當前句子如何影響未來句子的生成,為搜尋提供一個長期價值訊號。

VisVM引導下的推理階段搜尋:

在訓練好VisVM之後,作者使用VisVM作為獎勵訊號來逐步精細化推理過程。這一過程包括以下幾個步驟:

1. 生成多個句子候選:首先,模型會生成多個可能的句子,作為響應的候選。

2. 透過VisVM進行評估:接下來,利用VisVM對這些候選句子進行綜合評估,考察其與影像內容的匹配度以及對未來生成句子的潛在影響(句子中包含的幻覺,細致程度等)。

3. 選擇最佳句子:根據VisVM的評估,從候選中挑選出最優的句子來繼續生成。

相比於直接使用只考慮當前句子與影像匹配程度的clip分數作為獎勵訊號進行搜尋,VisVM可以進一步透過考慮後續生成的句子中的潛在幻覺來預測長期價值,使得VisVM能夠避開具有更高幻覺風險的響應候選,並生成不易產生幻覺且更詳細的影像描述。

透過這種叠代的推理過程,VLM能夠構建出完整且高品質的響應序列,有效減少資訊遺漏和幻覺錯誤,顯著提升模型的套用效能。

實驗

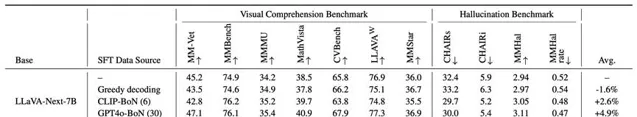

研究人員采用LLaVA-Next-Mistral-7B作為實驗的基礎模型,透過在其encoder的最後一層添加一個線性層作為value head,構建了VisVM並基於這個結構使用上文中構造的數據集與損失函式進行訓練。

在後續的實驗中,均使用LLaVA-Next-Mistral-7B作為base model用於生成響應。

研究人員首先評估了使用不同解碼方式生成的響應品質,作者從COCO2017數據集中采樣了1000個影像,並與llava detailed description 數據集中用於影像描述的9個prompt進行了隨機匹配作為測試集用於生成影像藐視。

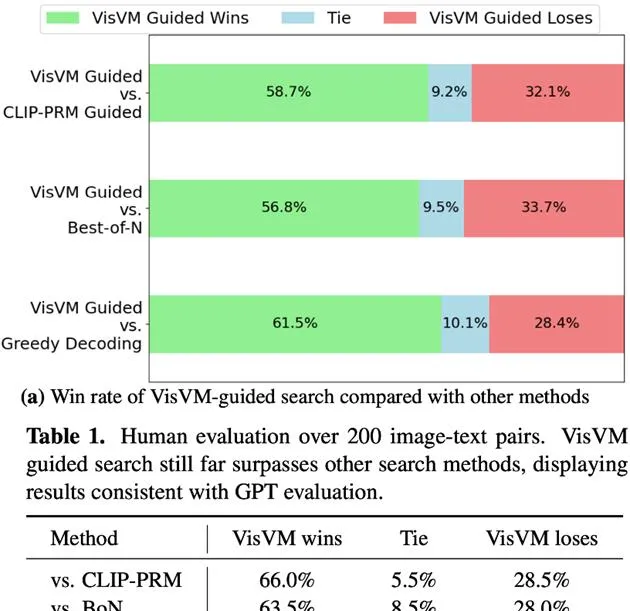

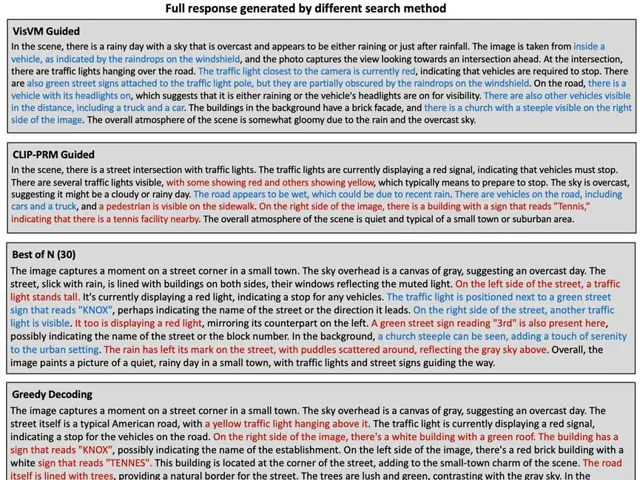

分別使用人類評估和GPT-4o評估,將VisVM引導的搜尋與其他常規方法如CLIP-PRM指導搜尋、Best-of-N選擇和貪婪解碼得到的影像描述進行了比較。

結果表明VisVM在生成影像描述時不僅細節更為豐富,產生的幻覺也大幅減少,其生成的描述性內容更加受到evaluator的青睞。

尤其是在人類作為評估者的情況下,VisVM引導搜尋得到的影像描述相比於其他三個方法分別取得了66.0%, 63.5%和74.0%的獲勝比率。

例如,在描述這個場景時,VisVM引導的搜尋甚至可以描述出擋風玻璃上的水滴擋住了綠色指示牌,這種細節在人類標註的時候甚至都難以察覺。展示了視覺價值模型對於細節描述的強大能力。

在現有幻覺的benchmark中,研究人員在VLM的inference階段使用了非搜尋方式生成響套用於評估。

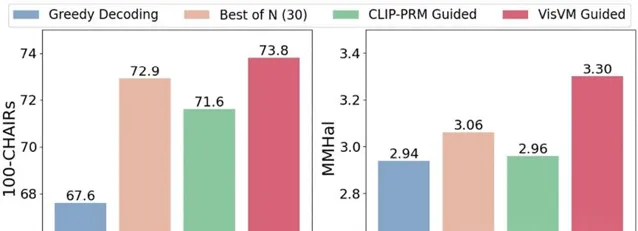

在CHAIR和MMHal兩個用於測試VLM幻覺的benchmark上VisVM引導的搜尋取得了顯著優於其他方法的效果,展示出減少VLM生成響應中的幻覺的強大能力

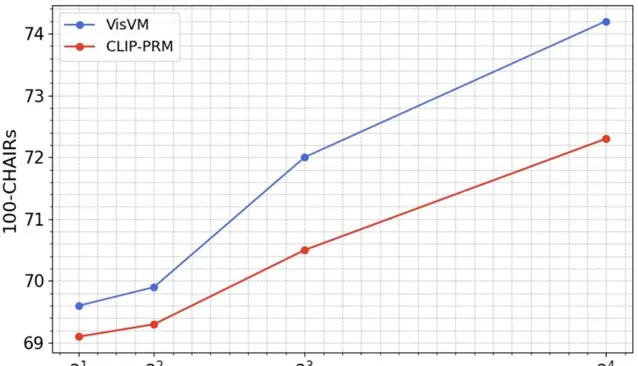

並且,作者還進一步探索了了VisVM引導搜尋的scaling law,結果發現無論是采用VisVM引導的搜尋還是CLIP-PRM引導的搜尋,隨著搜尋步驟大小的增加,模型的效能都會逐步提升。這一現象證明了擴大推理時間的計算量能夠顯著增強VLM的視覺理解能力。

特別值得註意的是,隨著步驟大小的增加,VisVM引導搜尋的效能提升速度更快,使得兩種方法之間的效能差距不斷擴大。VisVM在達到與CLIP-PRM相當的效能時,其計算效率幾乎是後者的兩倍。

透過擴大搜尋步驟,VisVM不僅能更快地達到理想的效能,還能以更低的計算成本實作,這在提升模型處理復雜視覺任務時尤為重要。

基於VisVM強大的減少幻覺的能力,作者使用使用LLaVA-NEXT-Mistral-7B作為基礎模型,並利用VisVM作為獎勵訊號,搜尋生成高品質的影像描述作為監督微調( SFT )數據,對LLaVA-NEXT-Mistral-7B進行訓練。

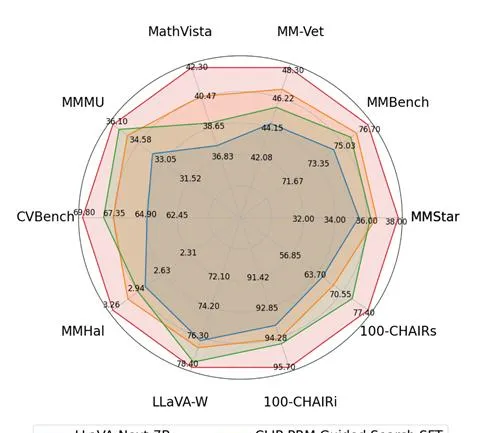

在九個理解和幻覺基準上的測試表明,VisVM引導的自我訓練使LLAVA-next-7B的效能平均提升了10.8%,相比於其他搜尋方法得到的影像描述作為訓練數據提升顯著。

特別是在提升了視覺理解能力後,VLM的reasoning能力也有所提高,例如MMMU和MathVista兩個benchmark,該結果進一步展示了VisVM搜尋得到的影像描述品質之高。

此外,這也揭示了VisVM在自我訓練框架中的套用潛力,僅透過在語言空間中進行高品質搜尋並進行微調,就能顯著提升原始VLM的視覺理解能力,這一發現為未來VLM的發展提供了新的方向和思路。