1 为什么要了解统计学

对于普罗大众来说,统计学应该会成为每人必备的常识,才能避免被越来越精致的数字陷阱欺骗。起码当你看到各种百分比和收益率,能多出一份警觉,多思考些他们的来源和计算途径。

对于互联网工作者来说,统计知识投射在互联网上,就是数据相关的方法论。举例来讲,现在盛行的 A/B Test 本质上就是控制变量法实验中的一种。不同的是,互联网获取数据更简单,进行对比实验更方便。这将是一个统计学/数据分析的大事件。想象一下 Facebook 内部几千个 A/B Gate,简直称得上一场史无前例的大规模人口社会实验。

这也是为什么近些年来 Growth Hacker ,Data Scientist 越来越火的原因。数据量的极易获取,计算存储成本的降低和分析效率的提升,使得统计分析的成本更低,规模更大,从而输出价值更高。

统计和分析的差别

个人理解上,统计分析应该是整个数据流程的不同部分。统计在于工具或手段,分析更偏重理念。比如回归分析为什么叫分析不叫统计,就是因为其中已经包含了部分归因的思想。再举个栗子,决定对一批数据取平均数还是中位数,这是统计,该怎么利用,是分析。

如【赤裸裸的统计学】中指出来的一样,统计分析是:

- 总结大量的数据

- 做出正确的决定

- 回答重要的社会问题

- 认识并改善我们日常的行为模型

2 统计学入门基础

统计学分为描述性统计学和推断性统计学。

描述性统计

定义:使用特定的数字或图表来体现数据的集中程度和离散程度。

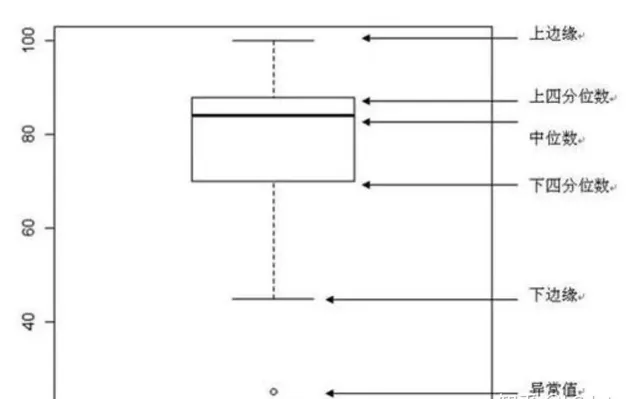

集中趋势集中趋势集中趋势是指一组数据所趋向的中心数值,用到的指标有:算数均数、几何均数、中位数。

离散趋势是反映数据的变异程度,常用指标有极差、四分位间距、方差与标准差、变异系数。

例如箱线图就可以很好反映其中部分重点统计值:

抽样方法和中心极限定理

抽样方法和中心极限定理

抽样方法:

我们在做产品检验的时候,不可能把所有的产品都打开检验一遍看是否合格,我们只能从全部的产品中抽取部分样本进行检验,依据样本的质量估算整体的产品质量,这个就是抽样,抽样的定义是为了检验整体从整体中抽离部分样本进行检测,以样本的检测结果进行整体质量的估算的方法。

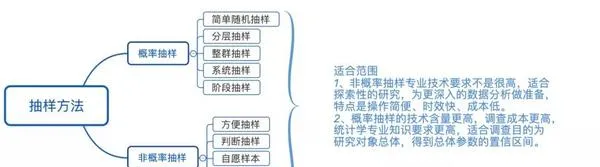

抽样有多种方法,针对不同的目的和场景,需要运用不同的方法进行检测,常见的抽样方法有:

1)概率抽样

2)非概率抽样

3)两者抽样方法之间的比较:

4)中心极限定理:

若给定样本量的所有样本来自任意整体,则样本均值的抽样分布近似服从正态分布,且样本量越大,近似性越强。

以30为界限,当样本量大于30的时候符合中心极限定理,样本服从正态分布;当样本量小于30的时候,总体近似正态分布时,此时样本服从t分布。样本的分布形态决定了我们在假设检验中采用什么方法去检验它。

描述性分析思维总结1. 集中趋势的描述性统计

2. 离散程度的描述性统计

3. 分布形态的描述性统计

4. 频率统计分析

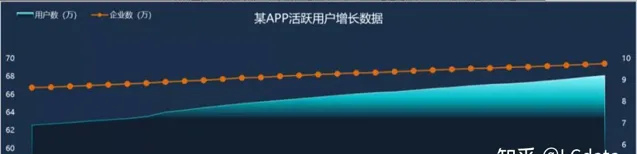

5. 按照时间递增的趋势统计

特殊情况下,当X轴是日期数据,Y轴是统计量(比如均值、总数量)时,可以绘制出统计量按照时间递增的趋势图,从图中可以看到统计量按照时间增加的趋势(无变化、递增或递减)和周期性。

例如,下图的X轴是日期,Y轴的统计量是总数量,两条折线分别是新增企业数和新增用户数据

描述性分析思维运用基本思路

描述性分析思维运用基本思路

首先,要描述目前的数据表现的现状是什么 ,根据分析目的,提取指标数据的具体数值:如数量、平均数、极差、标准差、方差、极值。

其次,描述分布规律 :如均匀分布、正态分布、集中趋势、长尾分布。

然后 ,根据以往的数据的或者是之前制定的标准, 制定参考标准 。

最后,综合现状和标准,输出有价值的结论,并进行可视化 :如柱状图、条形图、散点图、饼状图。

只有业务概况+数据指标+标准(可视化)才能得出一个「是什么」的结论。

业务概况+数据指标+标准(可视化)=结论的分析流程,非常简单,不过标准如何去制定?那又是需要我们深思的问题了。

例如,一个门店购买商品的数量的平均值是多少?四分位数是多少?标准差是多少?标准分是多少?两个数据的变异系数是多少?

一个门店销量每日增长趋势怎么样?客单价的分布如何?成什么分布?门店总销量是多少?哪个商品卖得最好?细分的品类中卖的最好的是什么?

例如面包中,是有奶油面包的好,还是无脂面包=卖的好?什么时间用户购买最集中,一天中哪个时间段购买最集中,卖得最好?

推断性统计

定义:根据样本数据推断总体的数据特征。

基本步骤产品质检的时候用的几乎都是抽样方法的推断性统计,推断性的过程就是一种假设检验,在做推断性统计的时候我们需要明确几点:

明确后可以对应我们假设检验的几个步骤了:

假设对于某一个器件,国家标准要求:平均值要低于20。

某公司制造出10个器件,相关数值如下:15.6、16.2、22.5、20.5、16.4、19.4、16.6、17.9、12.7、13.9。

运用假设检验判断该公司器件是否符合国家标准:

1)设假设:

2)总体为正态分布,方差未知,样本为小样本,因此采用T检验。

3)计算检验统计量:样本平均值17.17,样本标准差2.98,检验统计量为 (17.17-20)/(2.98/√10)=-3.0031

4)当置信度选择97.5%,自由度为9,此时为单尾检验,临界值为2.262。

5)由于-3.0031<-2.262,拒绝原假设,因此接受备择假设,该器件满足国家标准。

假设检验类型Z检验:一般用于大样本(即样本容量大于30)平均值差异性检验的方法。它是用标准正态分布的理论来推断差异发生的概率,从而比较两个平均数>平均数的差异是否显著。

T检验:用于样本含量较小(例如n<30),总体标准差σ未知的正态分布样本。

F检验:F检验又叫方差齐性检验。在两样本t检验中要用到F检验。检验两个样本的方差是否有显著性差异 这是选择何种T检验(等方差双样本检验,异方差双样本检验)的前提条件。

(T检验用来检测数据的准确度,检测系统误差 ;F检验用来检测数据的精密度,检测偶然误差。)

随机误差:也称为偶然误差和不定误差,是由于在测定过程中一系列有关因素微小的随机波动而形成的具有相互抵偿性的误差。

系统误差:指一种非随机性误差。如违反随机原则的偏向性误差,在抽样中由登记记录造成的误差等。它使总体特征值在样本中变得过高或过低。

卡方检验:主要用于检验两个或两个以上样本率或构成比之间差别的显著性,也可检验两类事物之间是否存在一定的关系。

双尾检测和单尾检测这个和我们提出的原假设相关,例如我们检测的原假设:器件平均值>=20。

我们需要拒绝的假设就是器件平均值<20,此时就是单尾检验;

如果我们的原假设是器件平均值>20,则我们需要拒绝的假设就是器件平均值<20和器件平均值=20,此时就是双尾检测。

置信区间和置信水平在统计学中,几乎都是依据样本来推断总体的情况的,但在推断的过程中,我们会遇到各种各样的阻碍和干扰;所以我们推断出的结果不是一个切确的数字,而是在某个合理的区间内,这个范围就是置信区间。

但整体中所有的数据都在这个范围也不现实,我们只需要绝大多数出现在置信区间就可以了,这里的绝大多数就是置信水平的概念,通常情况我们的置信水平是95%。

置信区间[a,b]的计算方法为:(z分数:由置信水平决定,查表得。)

a = 样本均值 – z 标准误差,b = 样本均值 + z 标准误差

3 分析中的统计学陷阱

陷阱 一:统计指标各有利弊

通过选择合适的统计指标,来精准表达数据集的内容。同时也需要防止有人利用这些指标的优缺点来误导舆论,影响你的决策。

- 平均数,中位数,四分位数 : 平均数对极值敏感而中位数不会。如果看中位数和四分位数,可能情况就会大不相同。

- 绝对值,比率值 :注册数是绝对值,注册率是比率值。比率值出现异常时,需要首先关注分子和分母的情况。比如说,某天发现网站 UV 周同比上涨了 500%,有可能是上周基数太低导致的。如果一上来就从维度进行细分,很容易跑偏。

- 百分比,百分差,百分率 :百分比是个常见的数据表达形式,其中猫腻也比较多。此类数字往往需要注意分母和分子的差别。以下是两个常见例子:1,一件货品先降价15%再涨15%价格是否一样?2,对于百分差和百分率,税率从3%涨到5%,可以说上涨了2个百分点,也可以说上涨了67%,给人感觉效果大不一样。

- 指数型数据 :即通过各项数据计算得出来的指数,优点在于将所有信息浓缩成一个数字,简单易懂,但容易忽略其中成分数据的影响。美团外卖当初有个很复杂的考核城市用户体验的指标,就是个很好的例子。通过多项数据的整合,我们很好地把用户体验这种比较虚的东西落到了实处。不过需要注意的是,对它的过分依赖容易带来误导性的结论。

陷阱 二:统计背景不够明确

-

首先要了解:

精确和准确是有本质差别的

。如在你内急的时候我告诉你公厕在你右边直走134.12m处,这很精确。不过实际上,厕所在左边。准确的要义是要能让指标贴近所描述事物。

-

这需要

在衡量事物的指标上达成统一

。如在之前 20011 年时有争论:美国制造业是否正在衰退?从总体产出上看,从 2000 年来看一直在增长,而制造业的就业数却在下降。因此需要统一指标来表述制造业的繁荣情况。就像电商一样,需要明确自己当前关注的唯一核心指标,如订单数,交易额等。不同的关注会导致公司战略上的不同。

-

第三确定指标后,需要确定描述主体

。同样是房价,政府说我们今年有60%的城市,房均价比去年低!你们买房有希望了!但实际上,40%的房子都涨价了,且都集中在核心城市。P 民们照样买不起房子..

-

注意时代背景

:【赤裸裸的统计学】中举了个很有趣的例子:如何评价历史上票房最高的电影。好莱坞在截止2011年时,给出的票房前 5 名是:阿凡达,泰坦尼克号,蝙蝠侠前传二,星球大战四和怪物史莱克二。但历史阶段上,通胀情况是不一样的。把通胀因素考虑进来后,这个榜单应该更新为:乱世佳人,星球大战四,音乐之声,外星人 ET 和十诫。

-

利用统计学手段可以影响人们的解读:截取有利时间段,混淆单位等。

陷阱 三:统计指标也有偏见

在选择样本和进行统计分析时,会存在各种各样的偏见,导致结果失之毫厘,谬以千里。

-

选择性偏见

:选择了错误的样本,得到的分析结论自然是错的。如在第三季硅谷里,Richard 对自己的开发者朋友们发布了 Beta 版,好评如潮。但因为其上手难度太高,普通用户根本用不了。最后导致注册用户虽有百万之巨,但活跃用户却寥寥无几。同样的,在对电商用户习惯做分析时,一二线城市和三四线城市的消费水平和习惯肯定有所差异,选择任一种都会有失偏颇。

-

发表性偏见

:学术研究或新闻更乐于发表肯定性结论而非否定性。一个打游戏不会引发癌症的研究,肯定不如证明当 PM 会导致寿命更短的实验更受关注。

-

记忆性偏见

:人们会因为结果修改自己的记忆,如很多成功人士会在失败后将原因归咎于某个因素,并将其放大成关键原因。但事实上可能并非如此。

- 幸存者偏见 :通过挑选样本来操控数据。简而言之,对于那些下单成功的用户数来讲,他们的注册成功率是 100%。在日常分析中,需要时刻警惕这种偏见的变异版本。

陷阱 四:慎重选择统计实验

在研究事物的相关性时,通过控制变量实验来研究是个比较科学的做法。在现实生活中,一些变量很难甚至无法控制,此时便需通过各种统计实验来逼近这种效果。

-

随机控制实验

:随机抽取样本,随机分配实验组和对照组。这便是最理想的 A/B Test,核心在分桶策略。

-

自然实验

:利用已有数据营造近似的随机实验,如在 O2O 城市运营中,很难长期控制城市去做实验要求的推广活动来对比哪种活动比较有效。合适的方法是从已有的数据中,挑选情况类似活动不同的城市来进行对比分析。

-

差分类差分实验

:利用时间和空间上的对比来控制变量,如美国曾经研究过受教育年龄对寿命的影响,就可以研究了田纳西州在教育改革时间前后的变化,以及和相邻州对比情况。

- 非连续分析实验 :选择条件类似但治疗条件不同,进行对比分析。如选择一批犯罪情况类似,但一批需要送去监狱一批刚好免除牢狱之灾的两组人进行对比分析,来研究坐牢对青年人后续犯罪率的影响。

高端技能的使用:回归分析

在统计分析过程中,会遇到从多个变量中判断相关性的过程。此时,统计学的大杀器「回归分析」便闪亮登场。

-

回归分析可以给出精确的答案,却不一定正确。如上世纪 90 年代风行一时的雌激素补充疗法,医疗依据是由哈佛医学院主持发现了女性身体健康与雌性激素的相关性。后来通过临床试验被证伪,但据估计,这个疗法已经导致了上万人过早离世。

-

7个常见错误:用回归过程分析非线性关系(如高尔夫成绩与课程多少,并不是线性相关或根本不相关),相关并非因果,倒果为因,忽略核心变量(如高尔夫患病几率高,其实只是因为年纪大的人才有时间打),高度相关的解释变量(需要精简和合并,如吸食海洛因和可卡因),数据矿(变量过多),脱离数据进行推断(要明确可使用的样本范围)

- 回归分析注意项:设计一个好的回归方程,明确变量和收集方式;以样本为立足点,需要能对所用变量作出解释

4 参考

- https:// coffee.pmcaff.com/artic le/414504464258176/

- http://www. woshipm.com/data-analys is/4195180.html

- http://www. woshipm.com/data-analys is/5170018.html