編輯:LRST

【新智元導讀】PCNet網絡具有創新的協同采樣算子和最佳化的重建網絡,實驗結果證明,其在影像重建精度、計算效率和任務擴充套件性方面均優於現有方法,為高分辨率影像的壓縮感知提供了新的解決方案。

壓縮感知(Compressed Sensing,CS)是一種訊號降采樣技術,可大幅節省影像獲取成本,其核心思想是「無需完整記錄影像資訊,透過計算即可還原目標影像」。

CS的典型套用包括:

降低相機成本: 利用廉價器材就能拍攝出高質素影像;

加速醫療成像: 將核磁共振成像(MRI)時間從40分鐘縮短至10分鐘內,減少被檢查者的不適;

探索未知世界,助力科學研究: 將「看不見」的事物變為「看得見」,如觀測細胞活動等轉瞬即逝的微觀現象,以及透過分布式射電望遠鏡觀測銀河系中心的黑洞。

CS的兩個核心問題是:

-

如何設計采樣矩陣,從而盡可能多地保留影像資訊?

-

如何設計高效的重建演算法,從而精準復原影像內容?

CS的數學模型可表示為

,其中x是原始影像,A是采樣矩陣,y是壓縮觀測值。

現有CS方法主要存在 兩個局限性:

-

采樣矩陣資訊保留能力不足:將影像切塊,逐塊采樣,導致觀測值資訊量有限;

-

重建演算法的計算開銷過大、復原精度有限。

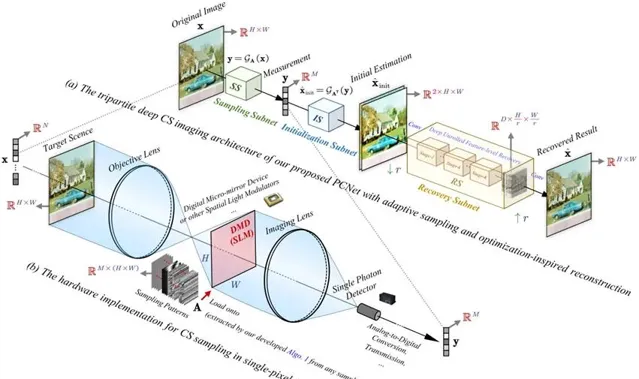

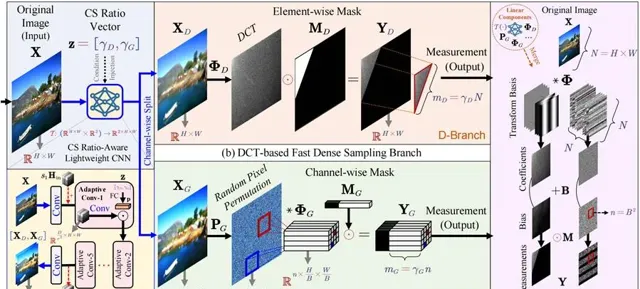

針對現有的問題,北京大學資訊工程學院的研究人員提出了一種實用、緊致的影像壓縮感知網絡PCNet,其針對壓縮感知(Compressed Sensing, CS)領域長期存在的關鍵難題,設計了一種全新的協同采樣算子,提高了模型在任意取樣率下的靈活性、可解釋性和恢復效能。

論文連結:https://ieeexplore.ieee.org/document/10763443

程式碼連結:https://arxiv.org/abs/2411.13081

發表刊物:IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI)

PCNet

1. 新型壓縮采樣矩陣設計

現有的壓縮采樣矩陣設計方法在資訊保留能力上存在局限性,難以同時捕獲影像的局部與全域特征。PCNet 針對此問題,提出了一種新型的協同壓縮采樣矩陣,顯著提高了采樣過程中的資訊保留能力。該設計透過以下兩步實作:

(1)局部特征提取:透過一個輕量級的小型摺積網絡對輸入影像進行濾波,充分捕捉影像的局部細節特征,例如邊緣和紋理。這一過程有效降低了數據的冗余性,同時為後續全域特征融合奠定了基礎。

(2)全域降維與特征融合:在完成局部特征提取後,進一步使用一個全域矩陣對濾波結果進行降維操作。全域矩陣透過引入更大的感受野,將影像的全域資訊(如大尺度結構和整體布局)與局部特征有機結合,從而生成具有豐富資訊的壓縮觀測值。

這種兩階段的采樣方法,不僅確保了對細節特征的捕捉,還彌補了傳統切塊式采樣方法在全域資訊保留上的不足,使得生成的壓縮觀測值資訊量更大、利用效率更高。

2. 新型影像重建網絡設計

為了實作從壓縮觀測值到高質素影像的精準重建,本研究設計了一種融合最佳化理論與深度學習的影像重建網絡。該網絡在以下幾個方面進行了創新性改進:

(1)基於近端梯度下降(Proximal Gradient Descent, PGD)的深度展開結構

傳統 PGD 演算法在求解稀疏最佳化問題時具有較強的理論保證,但其叠代過程較為緩慢,且難以適應復雜的影像數據。PCNet 將 PGD 演算法的每一次叠代操作轉化為深度神經網絡中的一個層,透過這種深度展開策略,使得網絡兼具理論可解釋性和實際效率。

(2)模組化設計提升重建精度

在深度展開網絡中,結合了最新的模組設計,包括註意力機制(Attention Mechanism)和多尺度特征融合模組,進一步提升了重建效果:

註意力機制:透過引入通道註意力和空間註意力,有效增強了網絡對重要影像區域(如邊緣和紋理)的關註能力。

多尺度特征融合:在不同尺度上提取和整合特征,確保網絡既能恢復局部細節,也能重建全域結構。

(3)輕量化與高效性

為了適應高分辨率影像(如2K、4K、8K)的處理需求,PCNet 在設計中采用了參數量和計算開銷較低的網絡架構,同時透過最佳化記憶體使用和平行計算能力,大幅提高了推理效率。

3. 套用範圍的擴充套件性與通用性

除了在標準壓縮感知任務中的表現,PCNet 的設計還具備較強的擴充套件性,其核心思想可以直接套用於以下任務中:

(1)量化壓縮感知(Quantized CS)

利用所提出的協同壓縮采樣矩陣,應對觀測值受量化誤差影響的場景,實作高效的量化數據還原。

(2)自監督壓縮感知(Self-Supervised CS)

將采樣矩陣與重建網絡設計融入自監督學習框架,降低對真值數據的依賴,同時提升演算法的通用性和魯棒性。

PCNet 的這些創新設計顯著解決了現有方法在采樣和重建方面的效能瓶頸,為壓縮感知技術的實際套用提供了全新的可能性。

圖1 提出的實用、緊致的壓縮感知網絡PCNet。

圖2 提出的協同采樣算子。

實驗結果

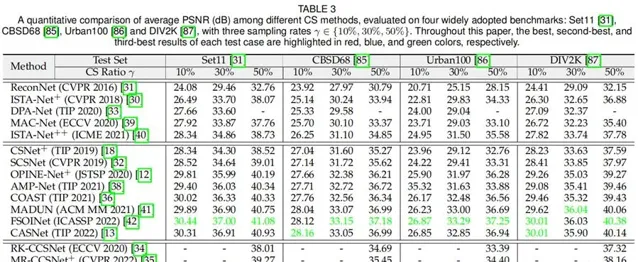

為了驗證所提出方法 PCNet 的有效性與優勢,本工作在多個基準數據集和多種任務場景下進行了詳盡的實驗評估,如圖3所示。這些評估涵蓋了壓縮感知效能、演算法效率和通用性測試。以下是實驗結果的詳細描述:

1. 影像重建精度

PCNet 在多個公開的影像基準數據集(Set11、CBSD68、Urban100、DIV2K)上進行了系統實驗,並與當前主流的壓縮感知方法進行了對比,重點評估了重建影像的峰值訊噪比(PSNR)和結構相似性(SSIM)。

結果表明,在Set11數據集上,PCNet在PSNR和SSIM上均超越現有方法,特別是在低取樣率條件下,能夠重建出更高質素、細節更清晰的影像;在CBSD68數據集的自然影像測試集中,PCNet展現出卓越的細節保留能力,尤其在邊緣和紋理區域,其效能顯著優於傳統方法;

在Urban100數據集的城市場景中,PCNet 在高頻細節(如建築物的邊緣線條和窗戶結構)上實作了更高的清晰度和精確度;在 DIV2K 數據集上,面對高分辨率(2K、4K、8K)影像的挑戰,PCNet 在不同取樣率下均取得顯著效能提升,充分展示了其對高分辨率場景的適應能力。

2. 計算效率與資源消耗

實驗還評估了PCNet在計算效率和資源消耗方面的效能,結果表明,在相同硬件條件下,PCNet的推理時間平均比傳統方法減少了40%,充分證明了其輕量化設計的優越性;在記憶體使用方面,PCNet的最佳化設計顯著降低了高分辨率重建任務的記憶體占用,使其能夠在有限資源的器材上高效執行;在參數量方面,與復雜的深度學習方法相比,PCNet的參數量減少了30%以上,但效能卻顯著提升。

3. 任務擴充套件性與通用性測試

除了在標準壓縮感知任務中的卓越表現外,PCNet的實驗還驗證了其在其他相關任務中的適用性。在量化壓縮感知任務中,PCNet的協同采樣矩陣設計能夠有效適應量化誤差,即使在量化誤差較大的情況下,重建效能仍優於現有方法;在自監督學習任務中,PCNet在無標註數據的場景下結合自監督框架進行訓練,展現了出色的適應能力和魯棒性。

圖3 方法與其他CS方法的對比結果。