我在其他評論中說過,絕大多數人沒有真正玩過激光雷達,更別提用激光雷達解決工程問題。

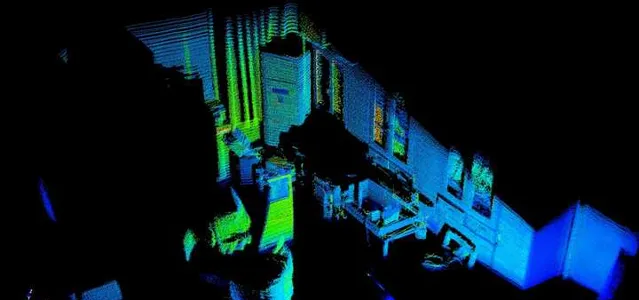

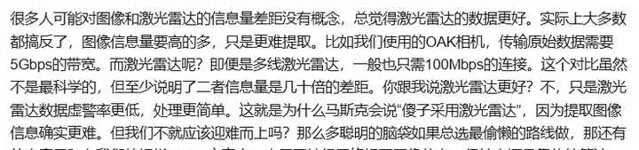

下圖是剛剛用激光雷達掃的一張辦公室點雲圖,你能看出來我辦公室有什麽嗎?估計能看出來有一個空調櫃機,似乎有個桌子,桌子上好像放了些什麽東西。你能分辨出來空調櫃機是什麽牌子嗎?能看出來空調現在啟動沒有?我不告訴你的話,你能知道我的窗簾上面有什麽圖案嗎?

這是一台400線激光雷達掃描出來的點雲圖,這台雷達價值4萬5。你願意花這個錢裝在你的汽車上嗎?

有人肯定要說,現在車載激光雷達幾千塊而已。當然了,幾千塊也能買來,32線或者充其量64線的。那麽,現在我把這張圖裏的點雲僅僅保留十分之一,你還能分辨出來我辦公室裏的桌子嗎?更不要說,我的辦公室很小,所以以扇形方式掃描的激光點雲還很密集。放在戶外,幾十米外的物體所形成的點雲會更加稀疏。

這個雷達不僅貴,上電後還會嗡嗡嗡直想,吵得腦瓜疼。為什麽不能安靜一點?因為裏面有微振鏡,那玩意是個機械運動部件,以非常高的速率上下左右掃描。任何做過工程的人都會想到,機械運動部件意味著機械磨損和可靠性低,至少與完全沒有運動部件的相機相比。

即使這麽貴,這麽重,這麽精密,它最多也就是10個FPS,即每100ms完成一幀掃描。一輛120km/h的汽車在這個時間內能夠移動3.33m。更糟糕的是,它是以掃描方式獲得點雲,因此汽車的移動造成點雲中不同區域並不同步。與之相比較,我常用的雙目相機在1920*1080分辨率條件下能夠以30FPS速率輸出點雲圖和RGB影像,分辨率升高到2208*1242時速率為15FPS。這台相機3000出頭吧,而且跟車載相機的精度差距應該不小。

我的空調旁邊是櫃子,上面有玻璃窗。你大概註意到了,一部份玻璃窗看上去是純黑色的,因為激光被玻璃鏡面反射走了,沒有反射到雷達中,所以雷達沒法辨識透明的、鏡面反射的物體。

現在給你一張僅有上面那張圖十分之一點雲密度的點雲圖,然後告訴你,你的汽車嚴重依賴於這個人眼都看不大清楚的點雲圖保障自動駕駛安全,你的感覺如何?

當然了,你會說激光雷達要和視覺相融合。Talk is cheap!請問,你怎樣把兩種傳感器數據對同一場景所生成的數據融合在一起?

你可以求平均,或者加權平均,但是權值怎麽取?

你可以說,只要激光雷達認為路面有危險,那就立刻停止駕駛。那麽天上如果下起大雪,雪花反射產生大量錯誤激光點雲,你的自動駕駛還能用嗎?

你說,現在有神經網絡了,把原始數據送進去訓練就好了。事情要是這麽簡單,那自動駕駛早都成功了。

很多人在嘲笑這一段,那我們展開一下

數據融合本質上就是多種資訊源的加權平均而已(假設數據已經對齊)。經典的卡爾曼濾波器,算了半天的卡爾曼增益,不就是一個權值矩陣嘛。神經網絡本質上也是一個巨大的權值矩陣,從原始數據中提取特征,用權值組合。

核心難點是權值怎麽定。經典方法本質上就是基於先驗知識調超參數,比如卡爾曼濾波器裏面的共變異數陣,最終還是靠人工調參。

神經網絡依靠學習逐漸計算權值,對先驗知識的依賴並沒有改變,這些先驗知識包括超參數設定,數據標簽,學習樣本,只是看上去更隱蔽一些。

我們把這個問題簡化一下:

假設對同一個事件,有兩個傳感器獲得了兩個觀測結果,A和B。假設它們已經完全對齊,顯然這是對實際情況的理想化。

我們如何把他倆融合為最終結論?

第一種方案,令C=a A + (1-a)*B

即固定權值的加權平均。卡爾曼濾波器本質上就是這樣子。

你覺得這樣子太糟糕了,應當區分不同情況下,兩個傳感器的置信度,用不同權值平均。那麽,如何區分不同情況呢?

顯然不可能再增加一個超越這兩個傳感器的更高層傳感器。

你說我們要用神經網絡,讓ai自己學習去。

但是不論如何學習,資訊源只有兩個。也就是說,決定如何取信傳感器,如何混合它們資訊的決策層,仍然依賴這兩個傳感器的資訊。也就是說

C=a(A,B)* A + (1-a(A,B))*B

這不就是所謂的,即使運動員,又是裁判員嗎?更進一步,你該如何用A,B傳感器資訊計算a呢?顯然還得有權值,這變成了一個遞迴問題,到最後,你還是得有一個固定的,來源於先驗知識和人工調參的權值。

再說一點,雙目相機本身就是能夠測距的,跟AI沒有任何關系,演算法非常經典。我們甚至給空軍做過基於雙目視覺的對接演示試驗。雙目生成的點雲圖和影像是像素匹配的,因此你可以直接把點雲圖當做一個通道,和rgb通道一起送入神經網絡訓練。

制約雙目相機的主要因素是算力,因為需要做稠密紋理匹配,放在二十年前處理一幀起碼是秒級耗時。激光雷達實際上是種取巧方式,機電要求高(但可以做到),算力要求很低,數據很稀疏,資訊量低。但是現在用GPU做計算,雙目的更新速率和資訊量遠大於激光雷達。如果二十年前有GPU,自動駕駛不會走上激光雷達這條路線的。

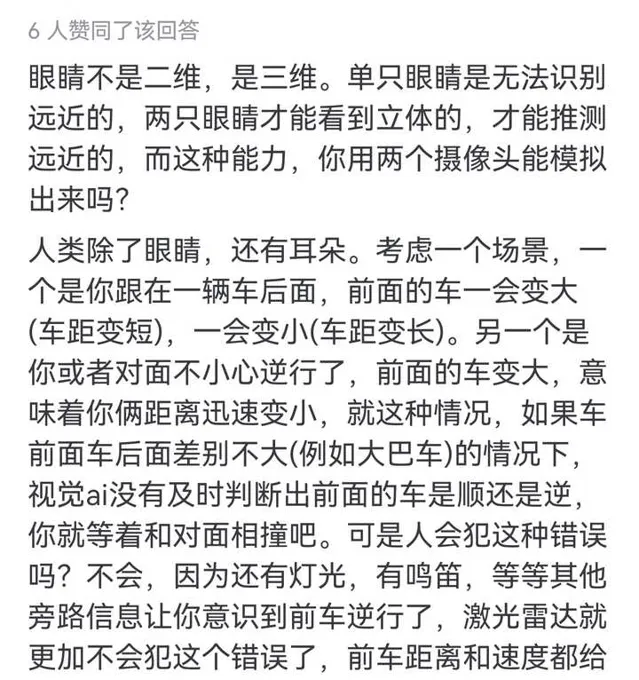

似乎很多人不知道雙目相機和人眼一樣具有深度檢測能力

至於用蝙蝠論證的。。。的確,絕大多數我們日常能見到的蝙蝠都是依賴聲納(雷達)定位。但是有一類蝙蝠,食果狐蝠,因為總是白天出行尋找水果,則是完全依賴雙目視覺。有趣的是,早期蝙蝠為了占據夜間生態席位,前進演化出了聲納定位,但是當狐蝠演化為白晝行動後,它們又拋棄了聲納,重新拾起視覺。這恰好說明,生物更傾向於視覺感知,只有在條件不允許時(蝙蝠在暗夜捕食,海豚在昏暗的海洋中捕食),才會前進演化出雷達感知模式。當生態環境允許視覺時,生物會在生存競爭壓力下,快速回到視覺正途上。

不止一個人用「飛機空戰時用雷達而非視覺」來論證激光雷達有用,例如這位,專門@我

那麽請問,雷達這麽好,為什麽坦克不用來搜尋敵人,引導火炮瞄準設計,還要以視覺為基礎對戰場環境進行感知?

原因很簡單,但是我要去開會了

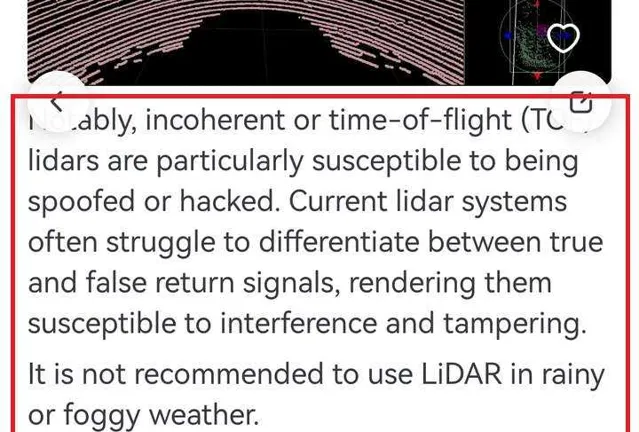

借用另一個回答中的內容,激光雷達很容易被幹擾和欺騙,在雨天和霧天不推薦使用。

再參考一下SLAM大佬的貼文

馬斯克的純視覺方案對算力要求高、門檻高,激光雷達方案暫時成本稍高但門檻低,未來終極會不會是合二為一? - 袁博融的回答 - 知乎

馬斯克的純視覺方案對算力要求高、門檻高,激光雷達方案暫時成本稍高但門檻低,未來終極會不會是合二為一?

核心思想是一樣的,沒有真正用過激光雷達的人,才會覺得激光雷達比影像好