編輯:LRST

【新智元導讀】 大語言模型能否解決傳統大語言模型在大規模數值數據分析中的局限性問題,助力科學界大科學裝置設計、高能物理領域科學計算?

高能物理是探索宇宙基本組成與規律的前沿科學領域,研究粒子在極高能量下的相互作用,是揭示宇宙起源、暗物質與暗能量等未解之謎的重要手段。

高能物理實驗(如粒子對撞實驗、暗物質與暗能量實驗等)產生的數據量極為龐大且復雜,傳統的數據分析方法在處理海量數據和復雜物理結構時,面臨計算瓶頸。

近期,arXiv上更新了一篇名為【Scaling Particle Collision Data Analysis 】的 論文。其中,研究人員 從粒子對撞實驗出發,探索了大語言模型在大科學裝置數據分析與科學計算領域的全新套用場景——

具體來說,團隊將其最新研發的科學基座大模型BBT-Neutron套用於粒子對撞實驗,模型采用了全新的二進制分詞方法(Binary Tokenization),可實作對多模態數據(包括大規模數值實驗數據、文本和影像數據)的混合預訓練。

論文連結:https://arxiv.org/abs/2412.00129

程式碼地址:https://github.com/supersymmetry-technologies/bbt-neutron

論文中對比了BBT-Neutron的通用架構模型與最先進的專業JoI模型(如ParticleNet和Particle Transformer)在粒子物理領域的Jet Origin Identification(JoI)分類任務上的實驗結果。

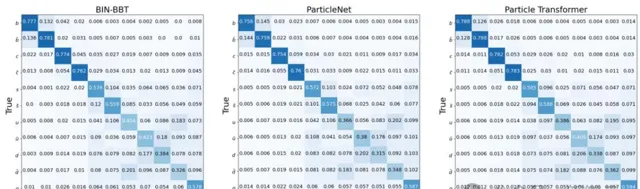

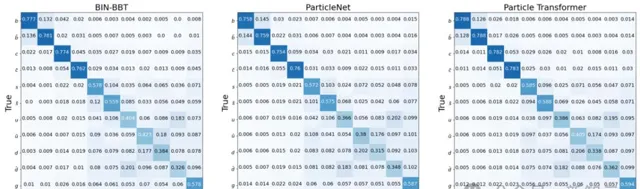

粒子分類的辨識準確率(圖1-3)表明,研究表明該通用架構的效能與專業模型持平,這也驗證了基於sequence-to-sequence建模的decoder-only架構在學習物理規律方面的能力。

圖1:BBT-Neutron模型十一種類的粒子噴註來源鑒別結果--超對稱技術團隊

圖2:ParticleNet模型十一種類的粒子噴註來源鑒別結果--論文協作者、ParticleNet開發團隊(高能所阮曼奇團隊)提供

圖3:Particle Transformer模型十一種類的粒子噴註來源鑒別結果--論文協作者、Particle Transformer開發團隊(CERN曲慧麟團隊)提供

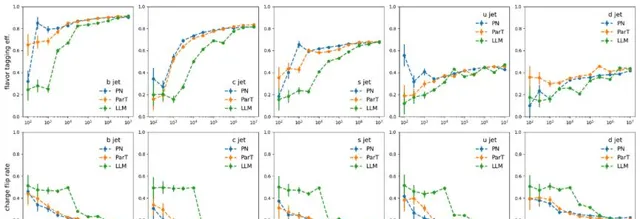

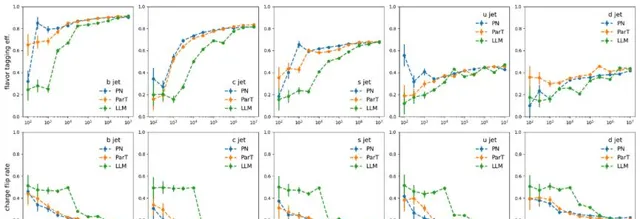

這些模型在數據集大小擴充套件時都顯示出效能提升,Jet Flavor Tagging Efficiency, Charge Flip Rate形成了S曲線。

然而,BBT-Neutron和專業模型之間觀察到不同的擴充套件行為,S曲線上的關鍵數據閾值表明BBT-Neutron中出現了湧現現象(在專業架構中未出現),不僅打破了傳統觀念認為該架構不適用於連續性物理特征建模的局限,更驗證了通用模型在大規模科學計算任務中的可延伸性。

圖4:噴註味鑒別準確率(上)以及電荷誤判率(下)與訓練數據量的關系

二進制分詞:統一多模態數據處理,突破數值數據分析瓶頸

近年來大語言模型在文本處理、常識問答等任務上取得了顯著進展,但在處理大規模數值數據方面依然面臨挑戰。

傳統的BPE分詞方法在分詞數碼時可能會引入歧義和不一致,特別是在高能物理、天文觀測等領域,分析復雜的實驗數據成為瓶頸。

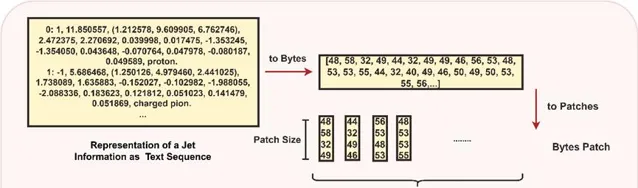

為了讓大模型更加適配科學計算場景,該研究透過引入一種創新的二進制分詞方法(Binary Tokenization),即利用電腦儲存中使用的二進制表示數據,實作了數值數據與文本、影像等多模態數據的統一表示。

從而使其能夠在無需額外預處理的情況下,透過二進制分詞,實作對所有數據類別的統一處理,簡化預處理流程,確保輸入數據的一致性。

研發團隊在論文中詳細展示了如何克服傳統BPE方法的局限性及其數據處理過程。

BPE方法的局限性

歧義和不一致性

BPE是一種基於頻率的token 化方法,它會根據上下文將數碼分割成不同的子單元,這可能導致同一數碼在不同上下文中有不同的分割方式。

例如,數碼12345在一個上下文中可能被分割成「12」、「34」和「5」,在另一個上下文中可能被分割成「1」、「23」和「45」。這種分割方式遺失了原始數值的固有意義,因為數碼的完整性和數值關系被破壞了。

token ID的不連續性

BPE會導致數值的token ID不連續。例如,數碼「7」和「8」的token ID可能被分配為4779和5014。

這種不連續性使得管理和處理數值數據變得更加復雜,特別是在需要順序或模式化的token ID時,這種不連續性會影響模型處理和分析數值數據的能力。

單數碼token化的問題

盡管單數碼token化方法簡單直接,但它也會導致多位數數碼的token ID不連續。例如,數碼15可能會被分解為獨立的token「1」和「5」,每個token都被對映到獨立的token ID。

這種分割可能會破壞數值資訊的連續性,使得模型更難捕捉多位數數碼內在的結構和關系。

數值處理方式

對於文本數據,使用UTF-8編碼將字元轉換為字節序列。

對於數值數據,提供了雙重策略:一種是當保留數碼的確切格式和任何可能重要的前導零時,數碼被視為字串,然後使用UTF-8編碼;另一種是在進行算術運算或處理重要數值時,數碼被轉換成其數值形式(例如,整數),然後轉換成字節陣列。這種方法保證了模型能夠統一且高效地處理各種數據類別。

對於科學公式或符號:復雜的運算式被解析並序列化成字節序列,捕捉公式的結構和內容。例如,公式E = mc^2被編碼為字節陣列[69, 61, 109, 99, 94, 50],代表了公式的結構和變量。

對於影像數據,使用patch方法將影像分解為小塊,提高對高密度像質數據的處理效率。

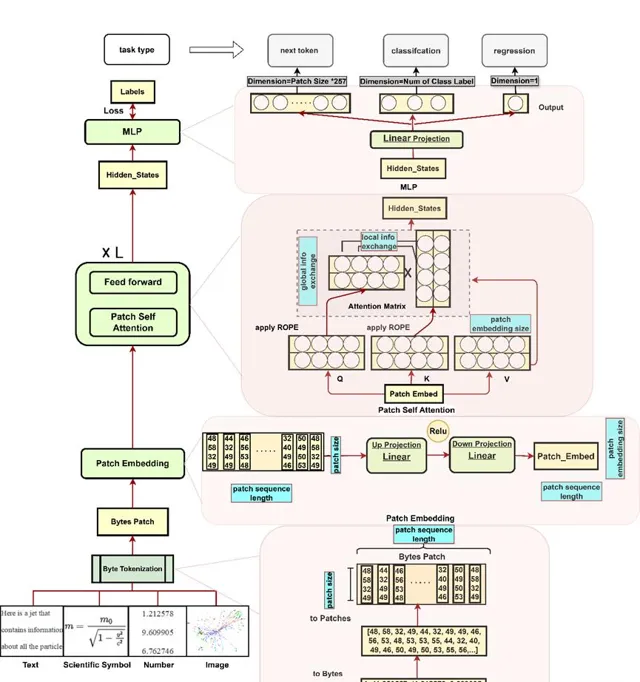

BBT-Neutron模型架構:高效捕獲數值關系與多功能任務適配

BBT-Neutron模型架構主要由三個關鍵部份組成: Patch Embedding 、Patch Self-Attention和LM Head,能夠將輸入序列透過字節分詞轉換為高維向量,使其具備了包括執行分類、回歸任務在內的多種能力。

這些任務在許多科學套用中非常常見,目標不一定是生成新序列,也可以是對輸入分類或預測連續值。

Patch Embedding

包含兩個線性層,第一層將輸入patch投影到高維空間,第二層細化這一表示,產生最終的嵌入向量。

兩層之間引入ReLU啟用函數,使模型能夠非線性地表達輸入字節patch,捕捉patch內部byte之間更復雜的結構。與通常只使用單一層線性嵌入的字節級模型相比,能夠提供更大的靈活性,更好地表示輸入patch的細節和非線性關系。

Patch Self-Attention

在patch自註意力機制中,註意力操作在patch層面執行,每個patch嵌入包含其所有點的資訊,透過矩陣乘法促進不同patch之間的資訊交換,同時促進單個patch內部字節之間的互動,使模型能夠有效捕捉局部和全域依賴。

LM Head

輸出維度定義為 Patch Size × 257,其中257代表從0到255的字節值總數,加上由256表示的填充ID,Patch Size是文本序列被劃分的patch數量。這種設計允許模型獨立地為每個patch生成預測,保持基於patch方法的效率和有效性。

圖5:BBT-Neutron模型架構圖

套用於粒子物理對撞數據分析:通用架構效能達到專業領域的SOTA

開發團隊在論文中分享了BBT-Neutron通用架構的首次落地實驗結果,輔助粒子物理學中的關鍵任務——噴註來源辨識(Jet Origin Identification, JoI),並已取得了突破性成果。

噴註來源辨識是高能物理實驗中的核心挑戰之一,旨在區分來自不同誇克或膠子的噴註。

在高能碰撞中產生的誇克或膠子會立即產生一束粒子——主要是強子——朝同一方向運動。這束粒子通常被稱為噴註,是碰撞實驗中物理測量的關鍵物件。

辨識噴註的起源對於許多物理分析至關重要,尤其是在研究 希格斯玻色子 、W和Z玻色子時,這些玻色子幾乎70%會直接衰變為兩個噴註。

此外,噴註是我們理解量子色動力學(QCD,描述原子核、質子、中子、誇克的相互作用機制)的基礎。

來自不同類別色荷粒子的噴註在它們的可觀測量上只有微小的差異,這使得準確辨識噴註的起源極具挑戰性。

圖6:帶patch的二進制分詞方法處理粒子物理數據流程

實驗結果顯示,該研究與最先進的專業模型(如Particle Transformer和ParticleNet,將專業物理定律融入GNN架構設計)的最佳效能持平,達到行業的SOTA(圖1-3)。

這個結果驗證了以sequence to sequence建模方式為基礎的decoder only通用架構,在學習物質世界和物理規律上具備與專業模型同等的學習能力。

而傳統的觀念認為,seq2seq 建模不適用於時間、空間、能量等具有連續性特征的物理實在建模,只適合於人類語言這樣的離散符號的建模。

而且從左到右具有位置特性的學習方式,不適用於具有時空對稱性的物理結構,要讓模型學習專業物理定律,需要在專業模型架構中融入該領域相關結構。

該論文研究的成果證明了這種觀念的局限性,為表征時間、空間、能量等基礎的物理量提供了一種有效方案,同時也為物理化學等專業科學領域構建一個統一模型提供了基礎。

Scaling分析:發現湧現行為

文中透過與ParticleNet和Particle Transformer在JoI任務上的擴充套件行為的方式進行對比,在數據規模增加下的Scaling行為進行了深入分析。

這些訓練數據集從100到1000萬事件不等,實驗結果透過混淆矩陣(confusion matrix)、噴註風味標記效率(jet flavor tagging efficiency)和電荷翻轉率(charge flip rate)這三個關鍵指標來衡量模型的表現。

混淆矩陣(Confusion Matrix) 即使用了一個11維的混淆矩陣M11來分類每個噴註,根據最高預測分數歸類到相應的類別, 塊對角化成2×2的塊,每個塊對應特定的誇克種類。混淆矩陣提供了模型分類效能的全面概覽,突出顯示了在各種噴註類別中正確和錯誤預測的情況。

噴註味標記效率(Jet Flavor Tagging Efficiency) 定義為每個塊內值的總和的一半,不區分由誇克和反誇克產生的噴註。

電荷翻轉率(Charge Flip Rate) 定義為塊中非對角線元素與塊總和的比率,代表誤辨識誇克和反誇克產生的噴註的概率。

圖4顯示,這些模型在十一種類的粒子噴註來源鑒別的分類問題上表現出相似的效能,並且在數據集大小擴充套件時都顯示出效能提升,Jet Flavor Tagging Efficiency, Charge Flip Rate形成了S曲線。

開發團隊指出, 該模型和專業模型之間出現了不同的擴充套件行為。 BBT-Neutron的S曲線上的關鍵數據閾值,特別是Charge Flip Rate的數據發生到了效能突變, 表現出顯著的湧現現象(Model Emergence),然而該現象在ParticleNet或Particle Transformer中並沒有被觀察到。

可能的原因是這些專業模型納入了特定領域的結構特征,它們采用專門設計的架構來表示粒子相互作用和分類,這可能導致隨著數據規模的增加,效能提升更快達到飽和。

與此相反,研究中的通用架構模型,使用統一的數據表示來處理所有物理結構。專業模型架構透過消除位置編碼或相關操作來實作粒子的置換不變性(permutative invariance),BBT-Neutron不依賴置換不變性,而是采用從左到右的序列輸入,這與語言模型的seq2seq範式一致。

雖然這種方法需要更大的數據集來推斷,但一旦超過臨界數據集閾值,它就能實作顯著的效能飛躍,這表明了該模型即使沒有像專業模型那樣明確在架構設計中納入置換不變性,也能夠透過足量數據的學習學到空間對稱性。

通俗而言, 當數據規模逐步增加時,該模型在效能上出現了顯著躍遷。這一發現驗證了通用模型在大規模科學計算任務中的可延伸性,即該模型有望成為跨領域的科學計算基座模 型。

該論文研究標誌著大模型在 多模態數據處理 與 科學計算 任務中的巨大潛力。隨著人工智能技術與大科學裝置的深度融合,在未來或許能夠加速 中國大對撞機CEPC 等前沿科研專案的實施落地。

該專案參與者、CEPC團隊成員阮曼奇曾評論道,「人工智能技術將助力大科學設施的設計研發,能大幅提高其科學發現能力,更好地幫助我們探索世界的奧秘、拓寬人類的知識邊界。

反過來,透過總結對比在具體科學問題上觀測到的AI效能差異,也能加深我們對AI技術本身的理解,更好推動AI技術的發展。」

BBT模型發展歷程

2022年:釋出BBT-1,10億參數的金融預訓練語言模型;

2023年:釋出BBT-2,120億參數的通用大語言模型;

2024年:釋出BBT-Neutron,1.4億參數的科學基座大語言模型,實作文本、數值和影像數據的多模態統一預訓練