AI的四大猜想

作者/ IT時報記者 郝俊慧

編輯/ 錢立富 孫妍

技術、套用、法規、倫理……雖然ChatGPT震撼世間才兩年,但世界仿佛已換了人間,而且這才只是開始。

一切對於AI的憂慮在於同一個前提:我們正在創造一個遠比人類聰明的新物種,而在此前人類前進演化史上,這一幕從未出現過。如果說,人類的欲望是其之所以主宰地球的最強動力,那麽AI有欲望嗎?它的欲望會是什麽?

站在2025年開端,【IT時報】記者采訪了牛津大學人類未來研究所創始主任、【超級智能:路徑、危險、策略】作者Nick Bostrom,復旦大學新聞學院教授、博士生導師鄧建國,Logenic AI公司聯合創始人李博傑,試圖去尋找這些問題的初始答案。

猜想一

AGI何時到來?

除了理性,AGI還要有人類的感性

2025年,AGI會到來嗎?

2024年,OpenAI定義了AGI(通用人工智能)的五個階段:第一級是聊天機器人,具有對話語言的人工智能;第二級是推理者,解決人類水平的問題;第三級是代理者,可以采取行動的系統;第四級是創新者,可協助發明的人工智能;第五級是組織者,可以完成組織工作的人工智能,並表示自己正處於第二階段。

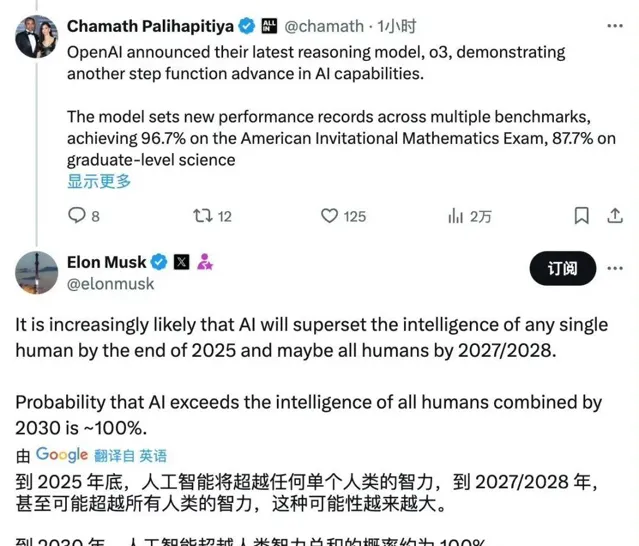

2024年12月20日,OpenAI釋出了o3,並宣布在AGI上取得了突破,最高的測試成績達到了類人水平。

2024年最後一天,OpenAI行政總裁Sam Altman在社交媒體上公布了一項調查結果,公眾談及對OpenAI 2025最期待的產品時,AGI排在首位。

然而,樂觀的OpenAI甚至在第一個問題上都還沒達成共識:什麽是AGI?

如果你向ChatGPT提問,它給出的答案是:AGI是指一種能夠執行廣泛任務的人工智能系統,具備類似人類的智能能力。

但Meta首席科學家楊立昆卻說,自己避免使用AGI這個詞,雖然他完全相信在未來某個時刻,機器會在人類智能所有領域都達到人類水平,「但把這稱為

AGI 完全沒有意義,因為人類的智能是極其專門化的」,他更願意將之稱為「人類水平的 AI」或「AMI」(高級機器智能)。

鄧建國則表示,人們對於AI的認知是混亂的,人工智能的實際發展水平糊大眾從科幻電影中所認識的AI有巨大落差,從圖靈測試到ARC-AGI,AI的得分越來越高,但似乎依然不是人們想象中的AGI。

他甚至認為,如果只有機器的理性,沒有人類的感性,沒有那些靈感突現的幽默感和與生俱來的悲憫與同理心(原生的,並非人工智能為了改進它對人類心理和社會的理解而建立起的具有道德意識的模擬意識),AGI從何談起?但同樣的悖論是,我們該擔心AI消滅人類,還是AGI消滅人類,「很多時候,人類已經變成了AI,所謂內卷,就是典型目標導向造成的」。

李博傑對此也十分認同,「AGI已經成為一些公司的行銷熱點,每個人都可以定義不同的AGI標準」。

AGI的測試標準也在不斷增加難度,盡管o3在AIME 2024數學測試中做對了 96.7%,ARC-AGI的正確率超87%,這似乎印證了o3即將具有通用的學習和推理能力,但ARC-AGI已經決定在2025年推出更嚴格的標準。

猜想二

超級智能的終極是什麽?

要創造成為良好宇宙公民的超級智能

當人們還在討論AGI的定義時,第一個提出類似概念的人工智能倫理學家已經走得更遠。2014年,人工智能倫理學家Nick

Bostrom在【超級智能:路徑、危險、策略】一書中提出了「超級智能」概念——在幾乎所有領域都遠超人類的認知能力,並分為高速超級智能、集體超級智能和素質超級智能三種形式。這被認為是當前認可度最高的對於人工智能預期的定義。

10年後,Nick Bostrom發表了新的論文【人工智能創造與宇宙宿主】。在他的設想中,人類可能身處一個更大的背景中,裏麪包括例如由外星文明所創造的其他超級智能(非常遙遠)以及未來的「數碼永生者」(如果我們將生活在電腦中的話)。

「 我建議我們應該嘗試創造能夠成為良好宇宙公民的超級智能——一個尊重宇宙主機中存在的規範,並為其他成員的價值觀做出積極貢獻的超級智能,而不是一個喜歡爭論或總是堅持自己立場的超級智能。 」他告訴【IT時報】記者,和當年他率先提出人類應該制造一種保護人類價值的超級智能那樣,他認為,人類應該有更謙虛的態度去面對一個更宏大的宇宙主題。

圖源:pixabay

圖源:pixabay

至於o3是否走在實作超級智能的正確道路上?他表示,這條路徑似乎在朝著那個方向前進,但盡管如此,可能仍需要在現有技術基礎上,加入一些新的創新才能最終達到,而不僅僅是簡單的擴充套件。

猜想三

超級智能的欲望會是什麽?

AI可以有欲望,但要讓它們

不像人類那樣重視「自我存在」

2024年諾貝爾物理學獎被頒給了有著「AI教父」之稱的辛頓(Geoffrey

Hinton),表彰他在使用人工神經網絡進行機器學習的基礎性發現和發明。而辛頓是堅定的AI威脅論者,他認為建立比人類更聰明的系統,可能導致該技術躲過人類控制而構成人類生存威脅,「你知道有多少例子是更智能的事物被不那麽智能的事物控制嗎?很少」。

但楊立昆卻有不同觀點,他在一次采訪中表示,「認為高智能必然導致統治欲望的想法是錯誤的。統治欲望源於生存需求而非智能水平,關鍵是如何確保 AI的目標與人類價值觀一致,避免它們有意或無意傷害我們。」

Nick

Bostrom同樣認為AI可以有欲望,他告訴記者,「當一個AI系統具備創造和追求計劃的能力時,我們可以說,它評估不同可能行動結果的標準反映了某種‘欲望’或偏好功能,但這並不需要到了超級智能階段才能有,事實上,人類的很多欲望,比如食物和性,同樣來自‘預設’-——前進演化遺傳。」

Nick Bostrom

Nick Bostrom

在他看來,超級智能產生「欲望」本身並沒有問題,人類所擔憂的某些AI系統可能發展出「自我保護」或「資源壟斷」傾向,並不需要超級智能產生特殊的「生存本能」 ,本質上,這還是多種可能目標的工具性後果,但關鍵在於「超級智能不必像人類那樣將自己的存在,看作是更值得珍視的」。

猜想四

AI和人類要如何超級對齊?

對「數碼心靈」也要溫柔以待

「Anthropic(由前

OpenAI核心成員建立)公司名字來源於Anthropic

principle(人擇原理),意思就是宇宙看起來似乎為人類的存在而微調過的。」李博傑告訴記者,Anthropic認為,並不是所有 AI

形態都對人類存在有益,因此要創造有益於人類存在的 AI 形態,也即AI Alignment(對齊)。

但要實作這一點非常難,Nick認為,人類可能會掉入「背叛轉折」陷阱——人工智能較弱時,它會表現得非常合作;當人工智能變得足夠強大時,它會在不給出預警也不做出挑釁的情況下進行逆襲,建立單一體,並開始按照其最終價值觀直接對世界進行改造。

或者,超級智能會發現一種能夠滿足其最終目標的標準,但是違背開發人員設計該目標意圖的方式。例如最終目標是讓我們微笑,它會麻痹人類面部肌肉組織,使其永遠保持微笑的表情。鄧建國表示,著名科幻學家阿西莫夫制定的「機器人三定律」,便很容易讓人類掉入機器人制定的反常目標陷阱。

圖源:豆包AI

圖源:豆包AI

Nick Bostrom提到一種解決辦法,如果人工智能的最終目標對資源要求比較低,而且它相信在多數虛擬世界裏,如果合作的話就會得到獎賞(如果試圖逃離盒子或者違背創造者的利益,就得不到獎賞),那麽它就可能會選擇配合。因此,即使人工智能具有決定性戰略優勢,有能力透過統治全球來更好地實作最終目標,它也可能不去這麽做。

但這種共識是否能在當下的人工智能競賽中形成?恐怕很難。

「從當前來看,各國都會有自己的人工智能,不必太樂觀,也不必太悲觀。」鄧建國認為,在全球利益一致的問題上,比如氣候,人類或許會達成某種AI倫理的共識,但整體而言,AI是無法實作人類價值觀對齊的。

Nick

Bostrom不確定是否會有單一的原則或組織形式存在,但AI的治理和全球合作的需求會越來越大,首先要確保越來越強大的AI系統不會失控並傷害人類;其次,即使AI系統與人類對齊,也需要確保人類不會利用它們來傷害他人,還需要確保AI的利益至少能夠被公平地分配;第三個問題更為重要,需要確保未來對這些數碼化意識體也有益,因為在未來,大多數具有感知能力的(或其他具有道德考慮的)意識體可能將是數碼化的,所以需要朝著確保它們幸福、並考慮它們利益的方向發展。

快問快答

【IT時報】:2025,AI會有什麽變化?

鄧建國: 第一,人工智能將進入創新擴散階段,技術本身將在S曲線的底部平緩爬升,但同時套用層會出現水平擴散。基礎大模型變得更強,也更加專業化,從水平擴散到垂直深入,AI將進入更多領域, 不再是「天上飛過的大雁」,而是實實在在落地專案 ,被更多人接受;第二, 大模型將變成小模型 ,更多垂直領域將使用自己的專業模型;第三, AI將慢慢滲透至不同人的工作流程中 ,誕生更多小而美的AI工具,人們會擁有自己私密的「AI朋友」。

李博傑:所謂「AI一天,人間一年」,目前 AI套用尚處於「初代iPhone」時期,模型能力、套用生態、使用者習慣都在快速前進演化中。

其中,大模型開始往專業模型和個人模型兩個方向分化。專業模型是通用大模型和垂直領域數據、工作流的結合,通用大模型的基礎能力是關鍵,一個世界領先的通用大模型加上

RAG(搜尋增強生成)行業知識庫,做出的專業模型效果往往超過開源模型加上一些垂直領域數據微調得到的行業模型。因此,專業模型雖然訓練、推理成本都較高,但考慮到較高的溢價空間,投入是值得的。

我自己最大的期望是GPT-4o 能力級別的模型成本進一步降低,這樣使用 LLM 的套用就不用擔心成本問題,比如DeepSeek V3的1M tokens現在活動價是1元,還是小貴,但已經比 GPT-4o 便宜很多了。