简要总结一下:

语音技术支持下的语音智能助手发展要解决的首要问题,也同时是发展方向——是持续提升「开放域」的连续对话能力,表达中越来越贴近人类的交流特点,丰富交互文本(在语音基础上增加图片、视频等多媒体文本)。

在此基础上,不仅要关注技术发展,更要关注它可能带来的社会影响,如社会偏见以及技术滥用倾向。

关于这个问题的解答,我们可以考虑从语音智能助手的 重要基础支持——语言模型的最新进展聊起 。

美国时间2021年5月18日,一年一度的谷歌I/O大会如期而至。在一众产品和技术之间,LaMDA的出现被认为很有可能是目前智障语音助手的「拯救者」。

LaMDA

的全称是Language Model for Dialogue Applications,简单而言,

它是一种能力更强的语言模型,适用于对话应用程序。

与前辈BERT、GPT-3一样,LaMDA也基于Transformer架构。后者是谷歌公司于2017年发布并开源的神经网络架构。利用该架构生成的模型,可以被训练阅读一组单词(比如一句话或一个段落),并且关注这些单词之间的联系,然后预测接下来会是什么单词

[1]

。与其他模型不同的是,LaMDA在对话方面接受了更多训练。

在展开介绍之前,我们需要仔细想想,现有的语音助手为何如此「智障」?

智障的根本原因是技术能力不足,具体表现为「文不对题」——不能给我们想要的答案,这一点相对还好解决,只要加大训练量就能逐渐优化。

但另一个更难以解决的问题是,语音智能助手只会孤立地理解我们提出的问题,并且孤立地给出答案。

换句话说,你不能指望它联系上下文语境,跟我们进行长时间的「连续对话」。

要知道,我们在现实中的对话场景是完全开放性的,经常是从一个主题出发,延伸到另一个主题,最后在完全不相关的主题结束。比如,我们见到一个朋友,常常以「你吃饭了没?」打头,聊到前几天推出的一款新游戏,最后打算周末约一场电影。

现实对话的开放性特征,使之成为机器学习领域最难解决的问题之一。

它涉及到一项很重要的能力,即自然语言理解(NLU),要求AI能够进行语义语境情感的判断,这是比自然语言处理(NLP)还要复杂的能力。

现在大多数智能助手,往往按照狭窄的、预先定义好的对话路径被设计,并不能进行开放对话、连续对话。

这就是它们看起来还相当智障的原因。

而LaMDA就针对这一问题进行了技术突破。LaMDA基于谷歌2020年的一项研究

[2]

,这项研究显示,基于Transformer架构的语言模型在经过对话训练后,能够谈论几乎所有话题。

在训练的过程中,LaMDA发现了开放式对话与其他形式语言的细微差别。它最为核心的,就是

进行「开放域」(Open Domain)对话的能力

。而这项能力的重要依托,就是相比于现有的对话模型,LaMDA更能理解对话的语境。它可以通过阅读句子或段落来「破译」对话意图,发现单词之间的关联,并能预测接下来可能出现的单词,从而做出合乎语境的回答。

在这样的能力支撑下,LaMDA能够和人在无穷无尽的话题转换中聊下去,进行长时间的开放性对话。用谷歌官方的话来形容,就是「

能够用自由流动的方式,谈论无穷无尽的主题

」。

举两个具体的例子——

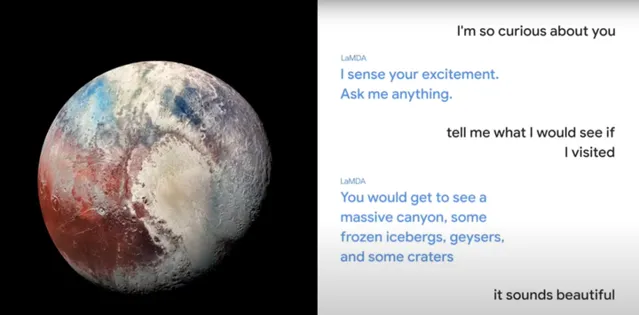

在本次大会的演示环节中,LaMDA扮演了冥王星的角色,与用户进行对话

[3]

。

用户:「我对你真的很好奇。」

冥王星(LaMDA):「我感受到你的兴奋了,来问我任何事吧。」

用户:「告诉我如果我去参观你,我会看见什么?」

冥王星(LaMDA):「你会看到一条巨大的峡谷,一些封冻的冰山,间歇泉,还有一些火山口。」

用户:「那听上去真美丽。」

可以发现,在示例场景中,LaMDA能够根据用户的提问作出精准回答,而且还能够将一个主题,引向另一个主题,不断推进对话。这种主题的过渡并不突兀,显得自然而合理。

当被问到:「

你希望大家了解你的哪一面?

」

它这样回答:「

我希望人们知道我不仅仅是一颗随机的冰球(random ice ball),我实际上是一个美丽的星球。

」

对于「冥王星之前是否有过到访者」的问题,LaMDA也能给出准确的答案。它甚至还贴心地提醒用户,如果要访问冥王星,需要带上大衣,因为它非常冷。

这种对话给人的感觉,就像是在和一个知识渊博的朋友聊天。虽然话题天花乱坠、不断涌现,但LaMDA总能接住话茬,并且自然而然地展开对话。

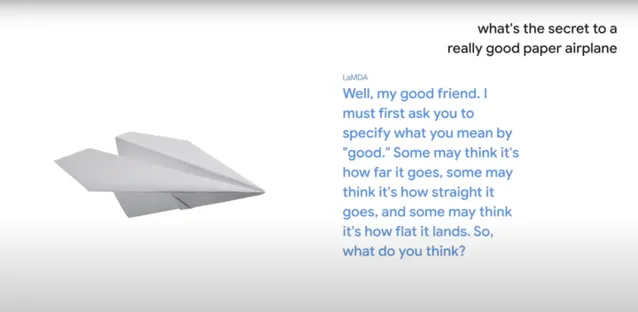

在另一个演示中,LaMDA也展现了高超的对话能力。

用户:「成为一架极好的纸飞机的秘诀是什么?」

纸飞机(LaMDA):「嗯,我的朋友。我必须先问你如何定义‘好’。有些人会认为这关乎纸飞机能飞多远,有些人认为是纸飞机能飞得多直,还有些人可能会认为是纸飞机平稳落地的程度。所以,你是怎么看的?」

在这个演示中,LaMDA扮演的角色是一架纸飞机。当用户问,你曾经最糟糕的着陆地点是什么?它回答说:「

可能是一个小水洼(puddle)。

」

当被用户问到:「

成为一架真正好的纸飞机的秘诀是什么?

」

它主动追问用户:「

‘好’是什么意思?

」,体现了足够的灵活和机敏。

用户回答:「

我关心距离(distance)。

」LaMDA进而围绕「如何优化纸飞机的飞行距离」这一话题,分享了相关知识。

要知道,LaMDA的这些回复都不是预先设定的,而是自然生成的。这也就意味着,LaMDA不必再经过专门的训练才能进行另一次对话,也不会作出重复的回答。这样的能力确实令人惊奇。

这两个示例中,仅凭寥寥几语就能看出LaMDA使问题应答更有意义了,而这就是理解对话语境能力带来的结果。在这样的能力辅助下,LaMDA表现得相当理智和机敏。

谷歌公司也表示,理智和特异性并不是LaMDA所追求的唯一品质。他们还注重洞察力、幽默感等能力。与此同时,谷歌也非常关注事实性问题,也就是LaMDA的回答是否符合事实

[4]

。

毕竟对于一个语音助手来说,有趣很重要,正确更重要。

虽然现在LaMDA这一语言模型在演示运作中可以根据对话语境提供建议和答案,让对话不违和地进行下去,但它仍在研发初期,想要达到AI助手的功能,还需要时间的磨合。

面对

语言的丰富性、灵活性以及随之伴生的复杂性

,LaMDA的能力同样还称不上成熟。在现实运行中,它仍可能出错,给出荒谬的回应。比如,在扮演冥王星的演示案例中,它就说到自己跳得很高(jump really high),经常练习翻转动作,并且很乐于用它最喜欢的球——月球来玩接球游戏。这些回答显然是违背常识的。

除此之外,作为语言模型,LaMDA也无可避免地面临一些AI的老问题。比如它

可能会被滥用或者传播偏见

。算法偏见是极为复杂的问题,既可能源于算法结构设计,也可能是训练数据集的问题,它的本质是社会偏见在算法层面的延伸。

如谷歌所言,「语言可能是人类最伟大的工具之一,但像所有工具一样,它可能会被滥用。接受语言训练的模型可能传播这种滥用行为——例如,

通过内化偏见、反映仇恨言论或复制误导性信息。

即使它所训练的语言经过仔细审查,模型本身仍然可能不被善用

[5]

。」

当然,LaMDA还会面临许多意想不到的

被滥用的现实风险

。比如被违法犯罪分子用于网络欺诈,类似的新闻已经屡见不鲜。更仿真的对话能力,也就意味着更强大的欺诈能力。

即便在技术层面,LaMDA也有更大的优化空间。目前,LaMDA主要是围绕文本对话进行构建的,

在未来,LaMDA可能会兼容其他的媒介形态,包括图像、音频、视频等等。

这可以寄希望于同在本次大会发布的MUM(多任务统一模型),未来人机交互手段或许会因这两项技术而出现革命性的变化。

LaMDA的具体作用如何,还待进一步观察,毕竟Google之前有过黑历史(2017年,Google发布了餐厅订位服务AI Duplex,后来被发现背后有真人帮忙完成

[6]

)。不过,人们和语音智能助手进行更自然、开放的对话,相信已经不再遥远了。

答案整理节选自 腾讯研究院 文章:【谷歌最新黑科技LaMDA,能让你的语音助手不再智障吗?】

作者:王焕超

参考

- ^https://www.blog.google/technology/ai/lamda

- ^https://ai.googleblog.com/2020/01/towards-conversational-agent-that-can.html

- ^https://www.youtube.com/watch?v=aUSSfo5nCdM

- ^https://www.blog.google/technology/ai/lamda

- ^https://www.blog.google/technology/ai/lamda

- ^https://wallstreetcn.com/articles/3567850