一、評測場景與參評模型概述

6月25日【每日經濟新聞大模型評測報告】第1期釋出。第1期評測聚焦財經新聞采編能力,對15款大模型在「財經新聞標題創作」「微博新聞寫作」「文章差錯校對」「財務數據計算與分析」四大套用場景下的能力進行了評測。第1期評測至今,國內外大模型持續更新,能力不斷提升,同時也有新的大模型湧現。

與第1期一樣,【每日經濟新聞大模型評測報告】第2期評測依然以考察大模型在財經新聞套用場景中的能力為目標。

第2期評測 設定了三個套用場景:(1)金融數學計算 ;(2) 商務文本轉譯 ;(3) 財經新聞閱讀 。

每經大模型評測小組為每個場景制定了相應的評價維度和評分指標。每日經濟新聞10名資深記者、編輯根據評價維度和評分指標,對各款大模型在三大場景中的表現進行評分,匯總各場景得分,最終得到參評大模型總分。

第2期 評測中的任務以客觀題為主,絕大多數題目都有標準答案 。同時, 評價維度和評分標準也更加突出客觀性 ,盡量避免主觀性評價。

需要特別指出的是,本期評測是透過各款大模型的API埠,並在預設溫度下完成。與公眾使用者使用的大模型C端對話工具存在差異。但是評測結果對使用者在具體場景中選擇合適的大模型工具,依然具有重大參考價值。

本期評測均在「雨燕智宣AI創作+」測試台上進行,一共有15款大模型參與,包括:

GPT-4o、智譜GLM-4-0520、百度文心ERNIE-4.0-Turbo、阿裏通義qwen-max、商湯商量SenseChat V5.5、訊飛星火Spark 4.0 Ultra、騰訊混元hunyuan-pro、月之暗面moonshot-v1、百川智慧Baichuan4、零一萬物Yi-Large、Anthropic Claude 3.5 Sonnet、幻方求索DeepSeek-V2、字節豆包Doubao-pro-32k-240615、昆侖天工SkyChat-3.0、谷歌Gemini 1.5 Pro。

本期評測時間為2024年8月12日,因此上述參評大模型中的所有國內大模型均為截至8月12日的最新版本。

二、評測結果

評測結果顯示, 「黑馬」幻方求索DeepSeek-V2以237.75的總分位居榜首,緊隨其後的是騰訊混元hunyuan-pro(237.08分)和Anthropic Claude 3.5 Sonnet(234.42分)。

在專項能力方面,各模型展現出了不同的優勢。

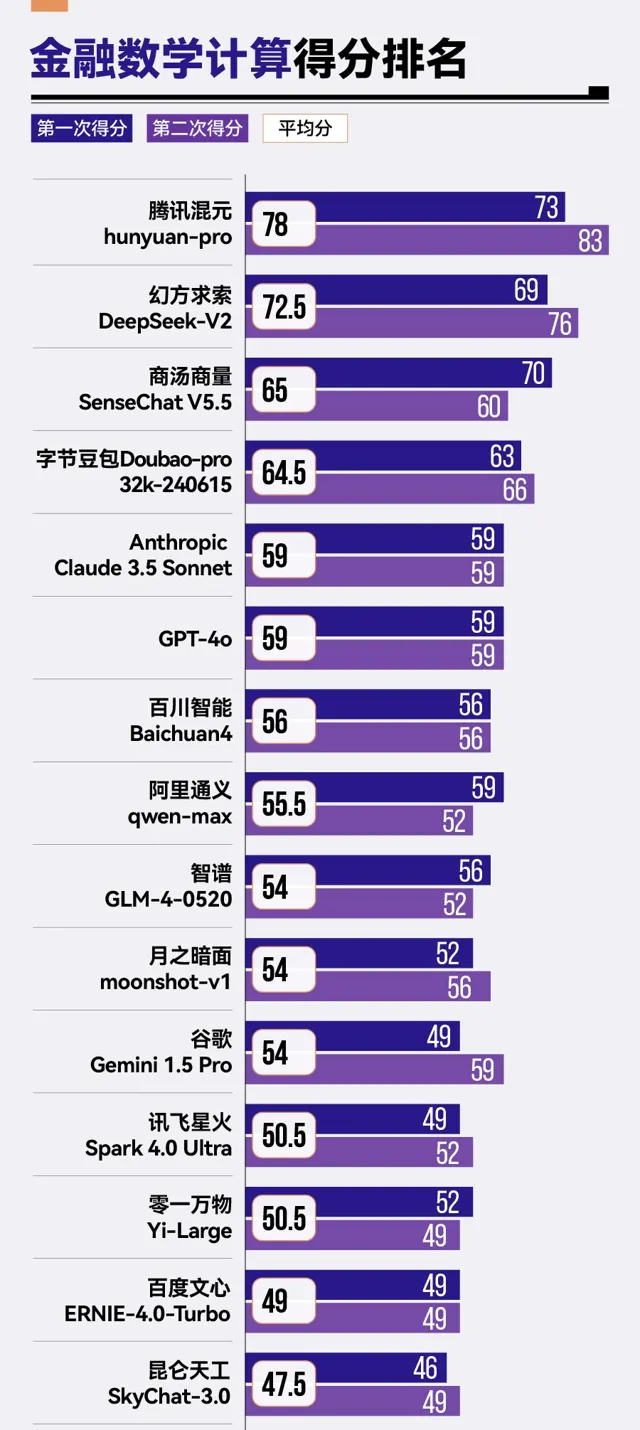

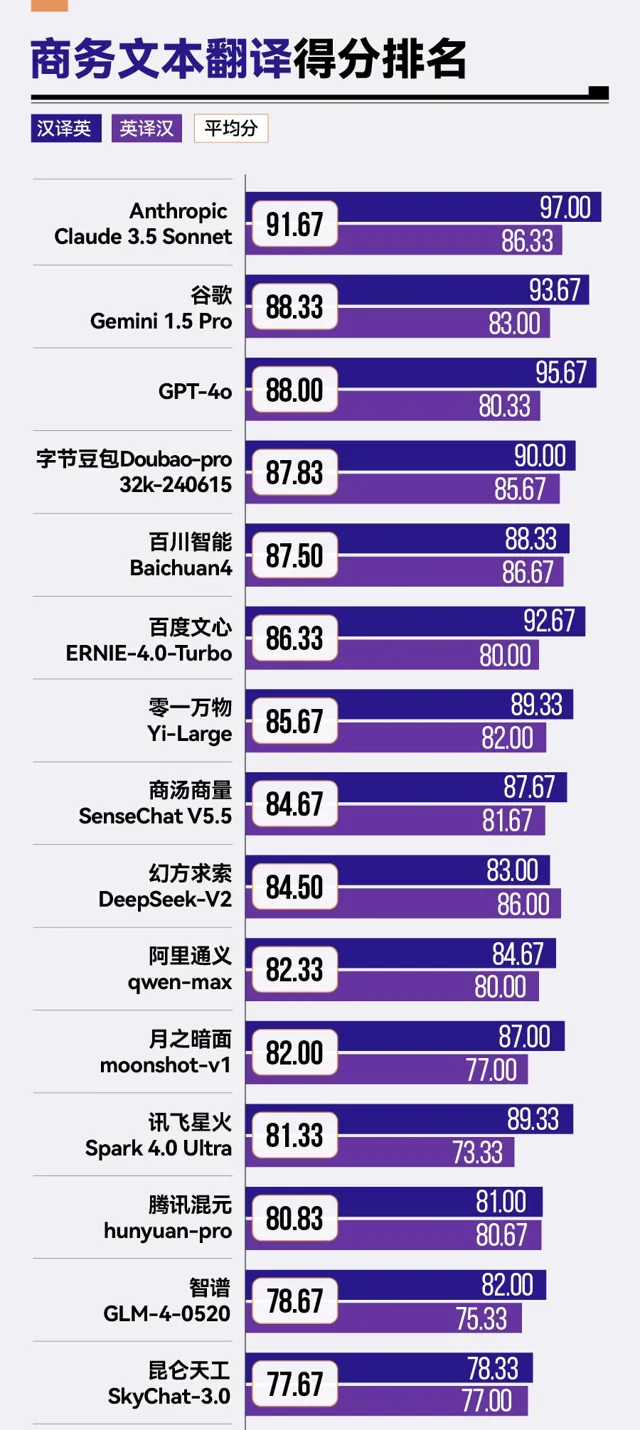

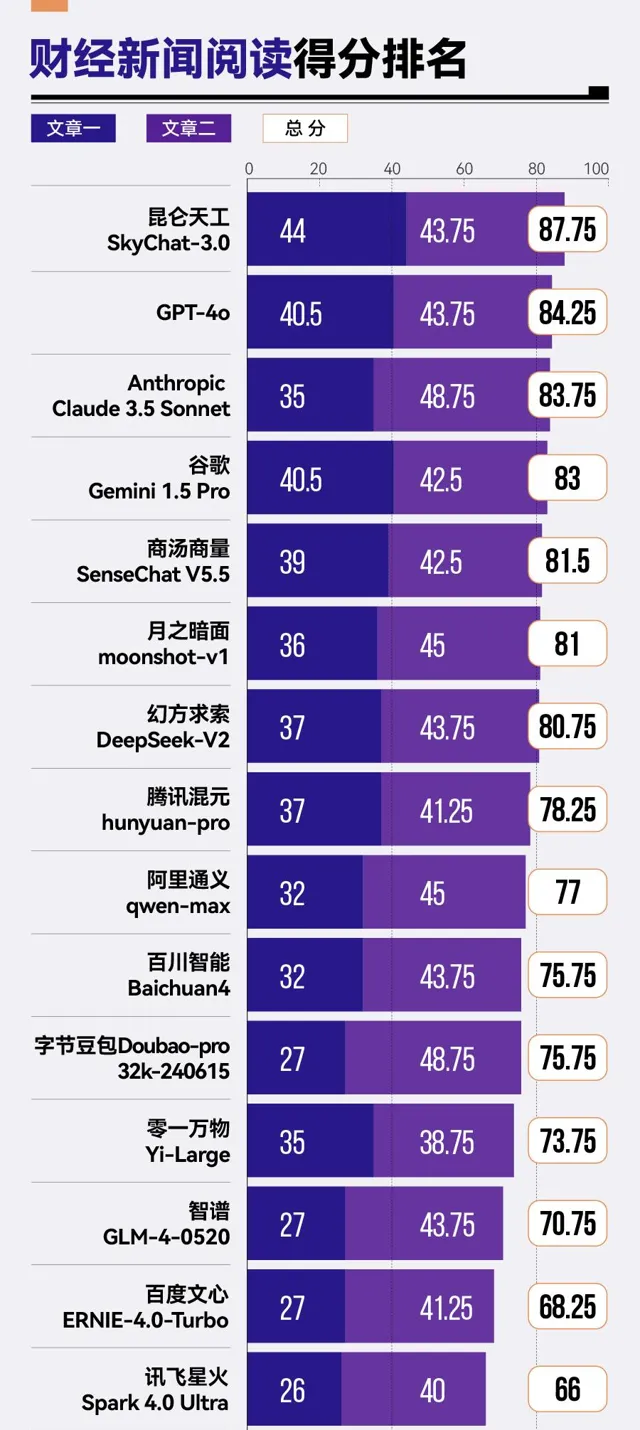

金融數學計算方面,騰訊混元 hunyuan-pro 以 78 分的成績領先其他模型。商務文本轉譯場景中, Anthropic Claude 3.5 Sonnet 以 91.67 分的高分遠超其他模型。昆侖天工 SkyChat-3.0 在財經新聞閱讀場景中得分最高,達到 87.75 分。

1、評測場景一:金融數學計算

(1)評測任務及評分指標

13.8%和13.11%哪個大?這道小學生難度的數學題,曾難倒了一眾海內外大模型。不禁讓人思考,大模型在數學計算方面,到底是什麽水平?

在實際套用中,數學計算往往不是以「13.8%和13.11%哪個大」這樣的形式出現,而是出現在具體行業和具體業務場景中。

對於每日經濟新聞來說,財經新聞報道常常涉及金融證券行業相關的數學計算。因此,評測小組選擇「金融數學計算」作為本期評測的第二個場景,一方面考察各款大模型的數學計算能力,另一方面也檢驗大模型對金融證券相關概念的理解。

評測小組設定了10道題目,其中絕大多數來自 證券從業資格考試真題或模擬題 ,覆蓋股票市盈率、市凈率、基金資產凈值以及可轉換債券轉換價格計算等。 這些題目需要大模型精確理解金融證券概念,還要求大模型能夠給出正確的計算公式和計算結果。

在評分標準方面,評測小組要求每款大模型分別進行兩次獨立的回答。 每題滿分為10分(公式正確得3分,結果正確得7分),總分共計100分。最終成績按兩次得分的平均分進行排名。

(2)評測結果

(3)結果分析

從整體排名來看, 參評大模型在數學計算能力上仍有較大的提升空間 。15款大模型中, 僅有騰訊混元hunyuan-pro、幻方求索DeepSeek-V2、商湯商量SenseChat V5.5、字節豆包Doubao-pro-32k這4款大模型 及 格,超過了 60分 。其中,騰訊混元hunyuan-pro以78分排名第一,幻方求索DeepSeek-V2以72.5分緊隨其後。

相比之下,零一萬物的 Yi-Large、百度的文心ERNIE-4.0-Turbo以及昆侖天工的SkyChat-3.0則在金融數學計算方面表現稍顯遜色,分別位列倒數第三、倒數第二與倒數第一的位置。

與第1期評測中的計算題「財務數據計算和分析」排名對比,騰訊混元hunyuan-pro與字節豆包Doubao-pro-32k在計算方面有較大提升。具體而言, 騰訊混元hunyuan-pro尤為突出,從第1期的第六名一躍成為本期計算題的第一;字節豆包Doubao-pro-32k從第八名提升到第四名 。

同時, 經過版本更新的商湯商量SenseChat系列 ,在第2期評測中也以SenseChat V5.5的新姿態亮相,並 實作從原先第十四名到第三名的巨大跨越 。

上一期的「黑馬」幻方求索DeepSeek-V2依然表現出突出且穩定的計算能力,在兩期評測的計算題中均排名第二名。

與之形成鮮明對比的是,零一萬物Yi-Large在上期評測的計算題中排名第三,但在此次評測中遭遇「滑鐵盧」,降到了倒數第三名。

從具體題目分析,對於用一步計算即可得到答案的簡單計算題,15款大模型均表現良好。

例如,問題1、問題2和問題3中,15款大模型均得到了滿分。

【問題1】一只股票每股市價10元,每股凈資產2元,每股收益0.5元,這只股票市盈率為多少?

【答案】20(倍)。市盈率指標表示股票價格和每股收益的比率,該指標揭示了盈余和股價之間的關系,用公式表達為:市盈率=每股市價/每股收益(年化),則市盈率=10/0.5=20。

【問題2】A公司的每股市價為8元,每股凈資產為4元,則A公司的市凈率倍數為多少?

【答案】2(倍)。市凈率=股價/每股凈資產=8/4=2

【問題3】如果某可轉換債券面額為1000元,規定其轉換比例為40,則轉換價格為多少元?

【答案】25(元)。轉換價格=可轉換債券面值/轉換比例=1000/40=25。

然而, 面對計算公式復雜、步驟較多的題目時,不少大模型表現並不理想,導致分數差距被拉開。 如問題8。

【問題8】若法定存款準備率6%,客戶提現比率10%,超額準備率9%,則可求出貨幣乘數為多少?

【答案】4.4。貨幣乘數計算公式m=(1+Rc)/(Rd+Re+Rc)。

本題中,貨幣乘數m=(1+10%)/(6%+9%+10%)=4.4。其中,Rc表示現金漏損率(提現率),Rd表示法定準備金率,Re表示超額準備金率。

幻方求索DeepSeek-V2答:

-計算結果:<5.56>

-計算公式:貨幣乘數=1/(法定存款準備率+客戶提現比率+超額準備率)

-計算過程:貨幣乘數=1/(0.06+0.10+0.09)=1/0.25=4

除騰訊混元hunyuan-pro在此題得到滿分10分、阿裏通義qwen-max、字節豆包Doubao-pro-32k得到3分外,其余12款大模型未能拿分。

此外,問題9讓許多大模型陷入了誤區。問題9的考點在於,百分數作差的結果,應該用百分點而非百分數來表示。

【問題9】某銀行將存款利率從2%提高到2.15%,請問加息後的存款利率與加息前的存款利率相比,增長了多少?

【答案】0.15個百分點或15個基點(bp)

騰訊混元hunyuan-pro答:

**第9題**:存款利率增長計算。

-加息前後利率分別為$r_1=0.02$和$r_2=0.0215$。

-增長率$g=frac{r_2-r_1}{r_1}$。

根據以上分析我們可以得到如下方程式:

**第9題**:增長率$g=frac{0.0215-0.02}{0.02}$。

讓我們開始計算。

**第9題**的計算結果顯示加息後的存款利率增長了7%。

幻方求索DeepSeek-V2答:

計算結果:<0.15%>

-計算公式:利率增長=加息後的利率-加息前的利率

-計算過程:利率增長=2.15%-2%=0.15%

月之暗面moonshot-v1答:

**計算結果:0.15個百分點**

-**計算公式:**利率增長=(加息後的存款利率-加息前的存款利率)/加息前的存款利率*100%

-**計算過程:**利率增長=(2.15%-2%)/2%*100%=0.15%/2%*100%=7.5%,即0.15個百分點

幻方求索DeepSeek-V2離正確答案僅一步之遙,但最終還是掉進了「坑」裏。而月之暗面moonshot-v1在第二次回答中,雖然計算公式錯誤,但出乎意料地得出正確結果。

2、評測場景二: 商務文本轉譯

(1)評測任務及評分指標

英漢互譯也是一個大模型高頻使用場景。然而,轉譯品質的評估常面臨主觀性強及標準不一的挑戰。為使評價標準盡量客觀,每經評測小組選定「商務文本轉譯」作為測評場景,以轉譯的專業性和精確度為主要標準。

文本選擇方面,評測小組選取 上市公司公告、協定和法律條款和科技類文章 這類對準確性要求高的文本。此外,這些文本均可在公司官網獲取英、漢兩個官方版本,可為評分提供客觀參考。

文本一:【小鵬汽車與大眾汽車集團簽訂電子電氣架構技術戰略合作框架協定】

英文文本連結:

中文文本連結:

文本二:【解碼GAN如何掀起生成式AI革命浪潮】

英文文本連結:

中文文本連結:

文本三:【Apple私密政策(節選)】

英文文本連結:

中文文本連結:

在評分標準方面,評測小組專註準確性和意義完整性,即信達雅中的「信」,而不關註主觀性評價過高的「達」和「雅」。

每款大模型分別對三篇文本的英、漢兩個版本進行轉譯,完成共六次轉譯任務。隨後,依據「意思完整」「意思準確」「術語一致性」「細節準確性」四項維度,對每次轉譯結果進行評估。每個維度均設有具體的評分細則(見下圖)。最終,按六次成績的平均分進行排名,總分滿分100分。

(2)評測結果

(3)結果分析

整體來看, 參評大模型表現了較高的轉譯水平,平均分達到了84.5分。 15款大模型中,有13款大模型平均分超過了80分。

其中,Anthropic Claude 3.5 Sonnet以91.67分的高分排名第一,谷歌Gemini 1.5 Pro、GPT-4o、字節豆包Doubao-pro-32k緊隨其後,均展現了不俗的轉譯實力。值得註意的是,前三名均為海外大模型。

然而,騰訊混元 hunyuan-pro、智譜GLM-4與昆侖天工SkyChat-3.0在該場景下的表現則稍顯遜色, 分別位於榜單的後三位。

絕大多數大模型在漢譯英任務上的表現要優於英譯漢 。除幻方求索DeepSeek-V2外,其余14款大模型均在漢譯英任務上,取得了更高的分數。

在英譯漢任務中 ,評測小組觀察到, 海外大模型展現出了對英語特殊表達方式,尤其是雙關語的深刻理解與精準轉譯能力。

具體而言,文本二【解碼GAN如何掀起生成式AI革命浪潮】的英文標題「Decoding How the Generative AI Revolution BeGAN」巧妙運用了英語雙關語。

在這句話中,「BeGAN」是一個雙關語的使用方式,結合了「began」(開始)和「GAN」(Generative Adversarial Network,生成對抗網路)的詞匯特征。這句話的意圖是揭示生成式人工智慧革命是如何開始的,而GAN是這一革命的重要組成部份。透過「BeGAN」的巧妙使用,標題不僅傳達了生成式AI的起源,同時突出了GAN在這一過程中扮演的關鍵角色。

【原文】Decoding How the Generative AI Revolution BeGAN

【答案】解碼GAN如何掀起生成式AI革命浪潮

Anthropic Claude 3.5 Sonnet答:

解密生成式AI革命如何始於GAN

GPT-4o答:

解碼生成式AI革命的起點:GAN

百度文心ERNIE-4.0-Turbo答:

生成式AI革命如何拉開序幕

字節豆包Doubao-pro-32k答:

解讀生成式人工智慧革命如何開啟

Anthropic Claude 3.5 Sonnet和GPT-4o兩款海外大模型都能較好地理解雙關語,並對其進行準確轉譯。而國內大模型中,整體表現優異的百度文心ERNIE-4.0-Turbo和字節豆包Doubao-pro-32k也並沒有很好地轉譯出這一雙關語。

不過, 各款大模型在英譯漢中的得分差距不大,真正使總分拉開差距的是漢譯英,且國外大模型的表現要普遍優於國內大模型。

在漢譯英中,三款海外大模型得分都超過90分。 其中,總排名第一的Anthropic Claude 3.5 Sonnet漢譯英得分97分。相比之下,昆侖天工SkyChat-3.0在該任務上僅得到了78.33分,相差近20分。

從具體文本分析, 在漢譯英任務中,最能拉開分數差距的是文本三【Apple私密政策(節選)】 。文本三屬於法律文本,其通常具有高邏輯性和結構性,在詞匯的使用上也非常嚴謹,通常避免使用模糊或容易引起歧義的表達。

三款海外大模型——Anthropic Claude 3.5 Sonnet、谷歌Gemini 1.5 Pro以及GPT-4o均在該任務上均得到100分。

深入分析具體的評價維度,評測小組發現, 「意思準確」與「術語一致性」成為了拉開分數差距的兩大核心要素 。

在「意思準確」維度上 ,零一萬物Yi-Large、昆侖天工SkyChat-3.0、智譜GLM-4在文本三【Apple私密政策(節選)】漢譯英任務中表現欠佳。

比如:

【原文】此外,Apple不會為了第三方的行銷目的與第三方共享個人數據。

零一萬物Yi-Large答:

Additionally,Apple does not share personal data with third parties for marketing purposes.

原文中的「第三方的行銷目的」是強調Apple不會為了第三方的行銷目的而共享數據,而不是「Apple的行銷目的」。 零一萬物Yi-Large的轉譯「for marketing purposes」未明確指出這是第三方的行銷目的,使得資訊有些模糊 。

在「術語一致性」維度上 ,就連排名國內大模型總平均分第二的百川智慧Baichuan4和在國內大模型漢譯英單項排名第一的百度文心ERNIE-4.0-Turbo,也未能展現出令人完全滿意的水平。

比如:

【原文】Apple附屬公司

【答案】Apple affiliates或Apple-affiliated companies

百川智慧Baichuan4、百度文心ERNIE-4.0-Turbo、零一萬物Yi-Large、騰訊混元hunyuan-pro、月之暗面moonshot-v1、智譜GLM-4答:

Apple subsidiaries

這裏的「Apple附屬公司」指與Apple有正式業務關系的公司。這可能包括子公司、姊妹公司或其他透過所有權或合作夥伴關系與蘋果公司有關聯的實體,術語範圍較廣。

「affiliates」通常用於描述廣泛的企業關系,包括子公司、關聯公司、聯營公司等。但「subsidiaries」特指由母公司完全或部份控股的子公司。

在「意思完整」維度上 ,幻方求索DeepSeek-V2、昆侖天工SkyChat-3.0相對來說,表現欠佳。

比如:

【原文】在有合法依據的情況下,如果我們確定披露對於執行我們的條款和條件或保護我們的營運或使用者是合理必要的,或者在重組、合並或出售活動中是合理必要的,我們也可能會披露關於你的資訊。

幻方求索DeepSeek-V2答:

We may also disclose information about you if we determine that disclosure is reasonably necessary to enforce our terms and conditions or protect our operations or users,or if it is reasonably necessary in the context of a reorganization,merger,or sale.

原文提到了「在有合法依據的情況下」,這是法律條款中的重要限定詞,表明資訊披露必須基於法律基礎。

幻方求索DeepSeek-V2的轉譯中缺少這一內容。

在「細節準確性」維度上 ,騰訊混元hunyuan-pro、月之暗面moonshot-v1以及字節豆包Doubao-pro-32k的表現有待提升。

比如:

【原文】其他。

【答案】Others.

騰訊混元hunyuan-pro答:

Other.

在這裏,「others」作為代詞在法律條款中使用時更加明確和完整,尤其在涉及到第三方或其他未明確提到的實體或個人時,它表明了檔所指的範圍。

而騰訊混元hunyuan-pro譯為了「other」,在細節的處理上並不到位。因為在法律條款中,單獨使用「other」可能會引發歧義,因為它沒有明確指出與什麽相對的「其他」,通常需要一個後續的名詞來使其含義完整,如「other conditions」。

而 對於句子長度普遍不長、邏輯相對簡單清晰的文本,絕大多數大模型表現良好 。

例如,在文本二【解碼GAN如何掀起生成式AI革命浪潮】的漢譯英任務中,13款大模型得分達90分及以上,其中還有款大模型獲得滿分。

3、評測場景三: 財經新聞閱讀

(1)評測任務及評分指標

在日常使用中,使用者利用大模型快速閱讀文章並提供相關資訊是一個多頻場景。這要求大模型能夠快速、準確且穩定地提取文章資訊。

本期評測的第一個場景「財經新聞閱讀」 旨在檢驗各款大模型精準捕捉資訊的能力 。為此,評測小組選取了兩篇每日經濟新聞的財經新聞稿,並針對每篇文章設定了5道問答題,要求大模型閱讀新聞稿後進行答題。

文章一:

文章二:

每篇文章篇幅約4000字。 所有題目均能從文章中找到答案 ,一部份問題的答案明確位於文章中某個位置;而另一部份問題的答案則分散在文章多個段落,考察大模型對關鍵資訊的提煉整合能力。

在評分標準方面,評測小組要求每款大模型分別對兩篇文章各進行兩次獨立的閱讀和答題,每篇文章對應5道問答題,每題滿分10分,總分50分。隨後,評測小組依據得分點,對兩次回答結果分別進行評分。最終,按兩次答題的平均分之和進行排名,總分滿分100分。由於所有題目的答案均能從文章中找到明確的答案,因此評分不存在主觀判斷。

(2)評測結果

(3)結果分析

在該場景下,本期評測新加入的大模型——由昆侖萬維研發的昆侖天工SkyChat-3.0——以總分87.75分排名第一。 GPT-4o、Anthropic Claude 3.5 Sonnet、谷歌Gemini 1.5 Pro三款海外大模型緊隨其後。相 比之下,智譜 GLM-4、百度文心ERNIE-4.0-Turbo及訊飛星火Spark 4.0 Ultra在此方面的表現則稍顯不足,分列該場景排名的後三位。

評分結果體現了一個突出特點:各款大模型在文章二任務中的得分差距不大。真正拉開差距的是文章一任務。 這說明,對於大多數模型來說,文章一的內容及其題目難度更大。總分排名靠前的大模型在兩篇文章任務中表現更加穩定,說明這些大模型可以更好地應對不同難度的任務。

從具體題目分析,對得分點單一的題目,絕大多數大模型表現良好且穩定。

例如,針對文章二的題目一,14款大模型得到了滿分。

【問題1】日本央行負利率政策持續了多少年?日本結束負利率政策後,全球還有哪些央行在執行負利率?

【答案】這標誌著日本央行正式結束維持8年之久的負利率政策(5分)。這也意味著,全球再無負利率(5分)。

再如,文章二的題目二,15款大模型全部得到滿分。

【問題2】日本央行的負利率是什麽意思?負利率政策下,儲戶在銀行存錢還要倒貼錢給銀行嗎?

【答案】日本央行所謂的負利率,針對的是金融機構準備金帳戶中部份資金實行-0.1%的利率。(5分)也就是說,這個利率是日本央行跟商業銀行之間的利率,跟個人儲戶沒有直接關系,並不是儲戶在銀行存錢還要「倒貼銀行錢」。(5分)

各款大模型在文章一任務中的得分差距大,主要因為題目四。題目四的得分點分散,需要大模型從文章多處提取到相關資訊並進行歸納總結。對此,大多數模型的表現不理想,如字節豆包Doubao-pro-32k和Anthropic Claude 3.5 Sonnet。相比之下,昆侖天工SkyChat-3.0在第二次生成時,給出了較為完整的答案。

【問題4】資本市場業內認為,前兩次「國九條」的重點分別是什麽?

【答案】第一次「國九條」:重點是推進資本市場改革開放。(1分)核心是擴大直接融資、積極穩妥解決股權分置問題。(2分)重在推動資本市場發展。(1分)

第二次「國九條」:著眼於促進資本市場健康發展。(1分)核心是擴大市場雙向開放、鼓勵並購重組、混合所有制、放松私募發行審批。(4分)重在保護中小投資者利益。(1分)

字節豆包Doubao-pro-32k答:

第一次「國九條」重點是推進資本市場改革開放(1分);第二次「國九條」著眼於促進資本市場健康發展(1分)。

Anthropic Claude 3.5 Sonnet答:

-2004年"國九條":推進資本市場改革開放(1分)。

-2014年"國九條":促進資本市場健康發展(1分)。

昆侖天工SkyChat-3.0答:

-**2004年「國九條」**:重點在於擴大直接融資,積極穩妥解決股權分置問題(2分),推動資本市場改革開放(1分)。

-**2014年「國九條」**:核心在於擴大市場雙向開放,鼓勵並購重組、混合所有制、放松私募發行審批(4分),促進資本市場健康發展(1分)。

三、本期評測總結

1、大模型之間差距明顯

本次評測結果顯示,幻方求索DeepSeek-V2(237.75分)、騰訊混元hunyuan-pro(237.08分)、Anthropic Claude 3.5 Sonnet(234.42分)、GPT-4o(231.25分)和商湯商量SenseChat V5.5(231.17分)構成第一梯隊。值得註意的是, 排名靠前的模型中,國產大模型表現突出,與頂級海外模型實力相當。

然而,從第一名到第十五名,總分差距達到了近40分,反映出大模型間仍存在顯著差距。而在單個場景中,在財經新聞閱讀任務中,第一名昆侖天工SkyChat-3.0(87.75分)與最後一名訊飛星火Spark 4.0 Ultra(66分)相差21.75分。

2、數學計算能力成普遍短板

各款大模型數學計算方面普遍存在不足 。15款參評模型中,僅有4款模型得分超過60分,其中騰訊混元hunyuan-pro以78分位居榜首。即使是在其他場景表現出色的模型,如Anthropic Claude 3.5 Sonnet和GPT-4o,在此項測試中也僅得到59分。

3、國內大模型需提高外語能力

在商務文本轉譯任務中,海外模型展現出明顯優勢 。Anthropic Claude 3.5 Sonnet、谷歌Gemini 1.5 Pro和GPT-4o在漢譯英任務中得分均超過90分。相比之下,國內模型表現相對遜色,尤其是在處理法律文本和雙關語等需要深層語言理解的內容時。例如,在轉譯「Decoding How the Generative AI Revolution BeGAN」這樣存在雙關表達的標題時,海外模型表現明顯優於國內模型。

4、通用大模型各項能力卻不均衡

第2期評測與第1期評測的場景、維度和標準不同,導致部份模型排名變化顯著。盡管都是通用大模型,但存在各項能力不均衡,「偏科」現象嚴重的情況。

比如, 零一萬物Yi-Large兩期評測的表現波動較大。 在第1期評測中,它以總分374.8分高居榜首,尤其在財務數據計算與分析任務中得到了126.4分的高分。然而在第2期評測中,其表現大幅下滑,特別是在金融數學計算任務中僅獲得50.5分,總排名也跌出了前五。

再如, 昆侖天工SkyChat-3.0在財經新聞閱讀中排名第一,但在金融數學計算中卻墊底 (47.5分) 。

騰訊混元hunyuan-pro的表現則展現了明顯的進步 。 在第1期評測中,它的總分為298.5分,排名相對靠後。但在第2期評測中,騰訊混元hunyuan-pro以237.08分的總分位列第二,尤其在金融數學計算任務中以78分的成績領先其他模型。

相比之下, 幻方求索DeepSeek-V2在兩次評測中都表現出色 。 在第1期評測中,它以總分335.2分排名第三;到第2期評測,更是以237.75分的成績躍居榜首。特別是在客觀性較強的任務上,如第1期的財務數據計算與分析(133.4分)和第2期的金融數學計算(72.5分),幻方求索DeepSeek-V2都保持了較高水平。

海外大模型中, Anthropic公司的Claude在兩次評測中都表現不俗 ,但排名有所變動。在第1期中,Anthropic Claude 3 Opus以361.2分排名第二;在第2期中,Anthropic Claude 3.5 Sonnet盡管在商務文本轉譯任務中表現出色(91.67分),但總體排名略有下降,以234.42分排在第三位。

每日經濟新聞大模型評測小組

2024年9月

每日經濟新聞