先說結論:AI繪畫引入ControlNet,意味著寫詞遊戲要結束了,ControlNet正在補完AIGC工業化的最後一塊拼圖。

2月22日更新文章:

就在情人節前一天一款叫ControlNet的SD外掛程式釋出了,這款外掛程式在短短的兩天內成為了AI繪畫領域最新的熱點。而它的出現代表著AI生成開始進入真正可控的時期,而AIGC的可控性是它進入實際生產最關鍵的一環。

在此之前,大家用了很多方法想讓AI生成的結果盡可能的符合要求,但是都不盡如人意,ControlNet 比之前的 img2img 要更加的精準和有效,可以直接提取畫面的構圖,人物的姿勢和畫面的深度資訊等等。有了它的幫助,就不用頻繁的用提示詞來碰運氣,抽卡式的創作了。

ControlNet的作者:張呂敏

ControlNet 的作者是一個2021年才本科畢業,目前正在史丹佛讀博的中國人。

之前很火的 style2Paints 也是他制作的,除此之外他還做了一款名為 YGOPro2 的Unity 紙牌遊戲,這款遊戲在國內外都有不少粉絲。

AI線稿上色這個領域一直都是他在做,感覺幾乎沒有其他人了,不知道是大廠嫌這塊蛋糕太小還是其他原因。 style2Paints 今年1月已經叠代到了第5版。下圖是 style2Paints 線稿到插畫的範例圖。

style2Paints的專案地址: https:// github.com/lllyasviel/s tyle2paints/tree/master/V5_preview

在讀博,寫論文,做這些AI工具之余還能玩票做了一款熱度還挺高的遊戲,現在的00後都這麽強的麽?

ControlNet是什麽?

ControlNet 直譯就是控制網,ControlNet 是作者提出的一個新的神經網絡概念,就是透過額外的輸入來控制預訓練的大模型,比如 stable diffusion。這個本質其實就是端對端的訓練,早在2017年就有類似的AI模型出現,只不過這一次因為加入了 stable diffusion 這樣優質的大模型,讓這種端對端的訓練有了更好的套用空間。

它很好的解決了文生圖大模型的關鍵問題:單純的關鍵詞的控制方式無法滿足對細節控制的需要。

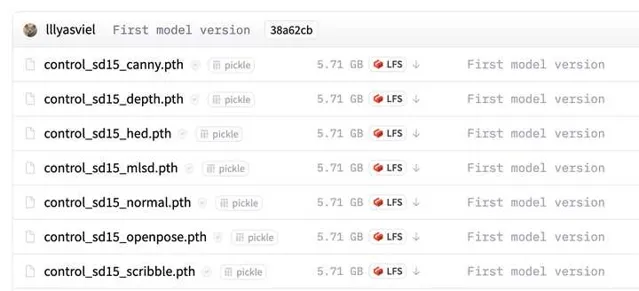

ControlNet 把每一種不同類別的輸入分別訓練了模型,目前公開的有下面8個。分別是:canny,depth,hed,mlsd,normal,openpose,scribble,seg。

ControlNet 相關資源

ControlNet專案地址: https:// github.com/lllyasviel/C ontrolNet

ControlNet 的 WebUI 擴充套件: https:// github.com/Mikubill/sd- webui-controlnet#examples

模型下載(5G) https:// huggingface.co/lllyasvi el/ControlNet/tree/main/models

模型下載(700mb) https:// huggingface.co/webui/Co ntrolNet-modules-safetensors/tree/main

中文教程:

英文教程: https://www. youtube.com/watch? v=vFZgPyCJflE

https://www. youtube.com/watch? v=OxFcIv8Gq8o

https://www. youtube.com/watch? v=YJebdQ30UZQ

controlNet匯入方法(日語) https:// miro.com/app/board/uXjV PnNbqTA=/

ControlNet可以做什麽?

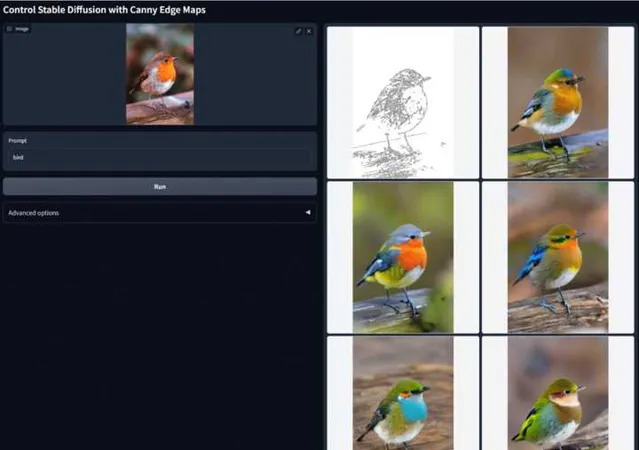

1 canny 邊緣檢測,提取線稿

透過從原始圖片中提取線稿,來生成同樣構圖的畫面。這個案例是輸入鳥的圖片和提示詞。

透過給線稿上色來制作的小動畫,穩定性很好。

圖片來源:https:// twitter.com/izumisatosh i05/status/1625835599017148416

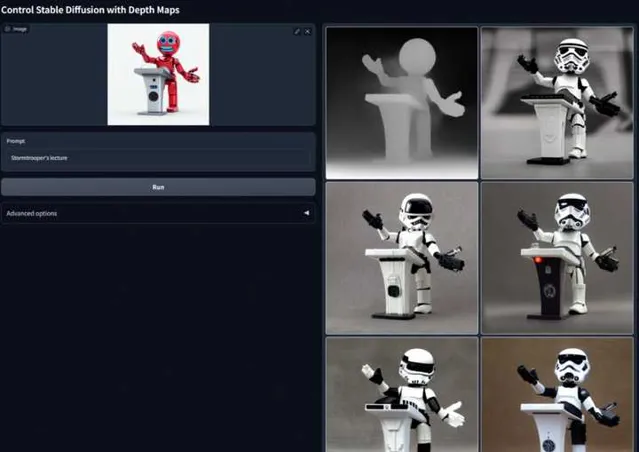

2 depth 深度檢測,提取深度圖

透過提取原始圖片中的深度資訊,可以生成具有同樣深度結構的圖。

用Blender建立空間→建立深度圖→用ControlNet Depth建立插圖→貼上為Blender空間中的紋理,就可以建立無限彈出的立體書

來源:https:// twitter.com/TDS_9551487 4/status/1625849823957233664

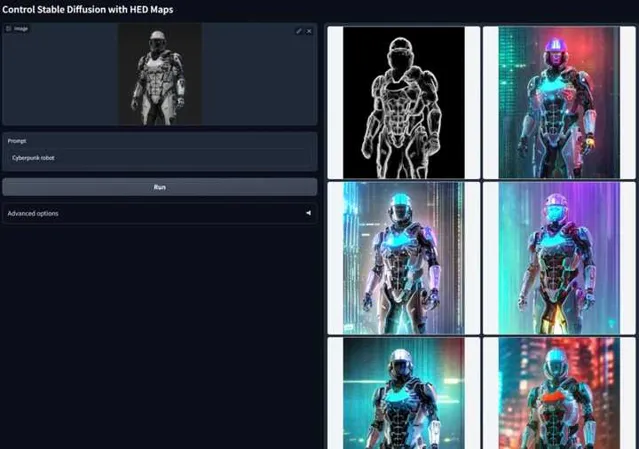

3 hed HED邊緣提取,跟canny類似

相對於使用普通的 img2img ,邊緣線提取的方式可以生成更加清晰完整的圖,黑色描邊也得到了很好的重繪。

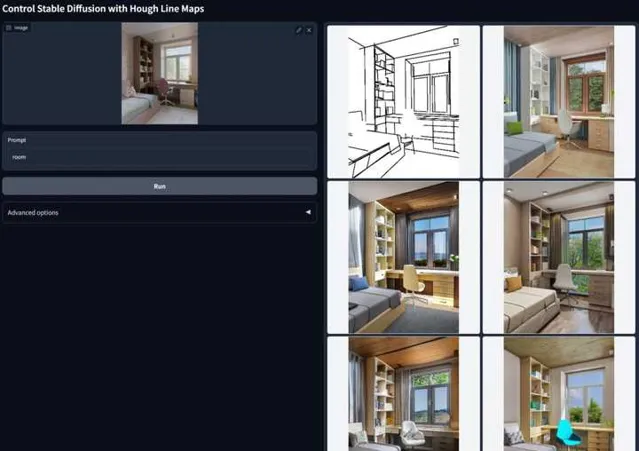

4 mlsd 線段辨識,適用於建築場景

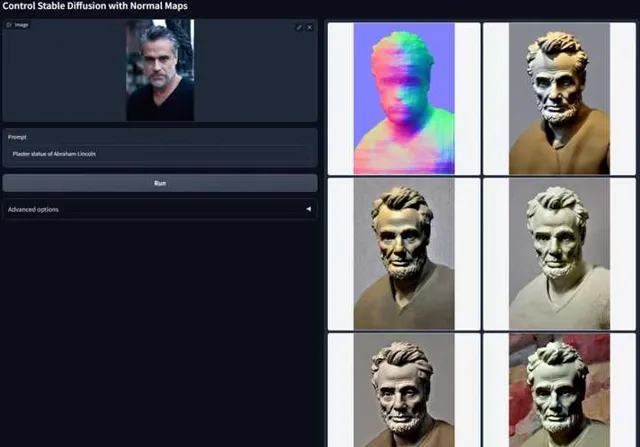

5 normal 模型辨識,適用於建模

跟深度圖有點類似,透過讀取原圖片中的深度資訊和法線背景閾值。它比深度模型對於細節的保留更加的精確。

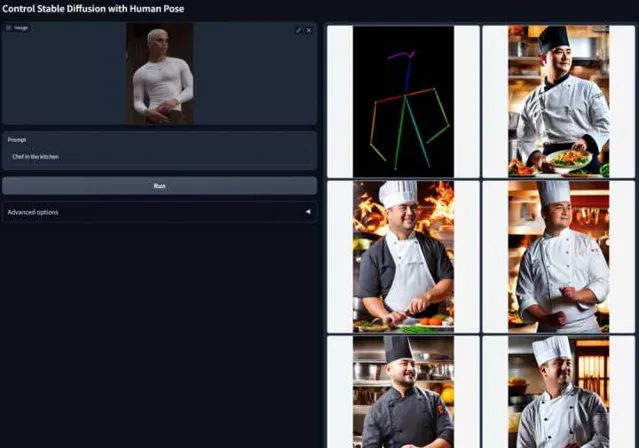

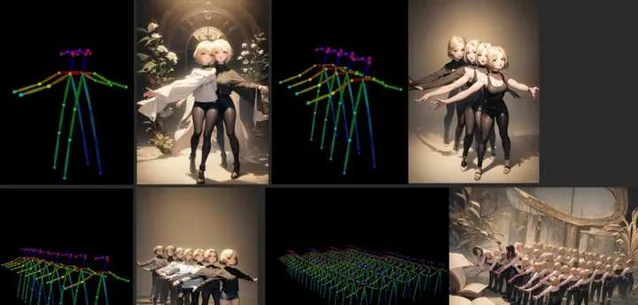

6 openpose 姿勢辨識,用於人物動作

這個功能對於人物設計和動畫十分有利,應該會很快用在影視行業。

除了生成單人的姿勢,它甚至可以生成多人的姿勢,這點非常關鍵,在此之前AI生成的畫面裏多個人物的特定動作是幾乎無法靠提示詞來實作的。

透過控制人物姿勢,在人物角色設計上的嘗試。

7 scribble 黑白稿提取

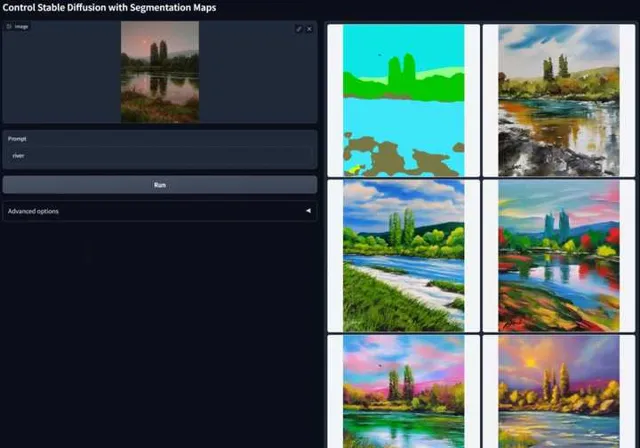

8 seg 語意分割辨識

這個之前輝達做過類似的產品。

總結

AI工具以及細分領域套用的公司們,可以做的事情越來越多了。而今年才過了不到兩個月,我們無法想象在年底的時候,AIGC的發展會到達什麽樣的程度。