我和楊子江教授的新書【自動駕駛系統開發】剛剛在清華大學出版社印刷上市。

基本內容介紹:

推薦的學者、企業家和一線專家:

李克強教授和院士寫序:

本書主要內容介紹:

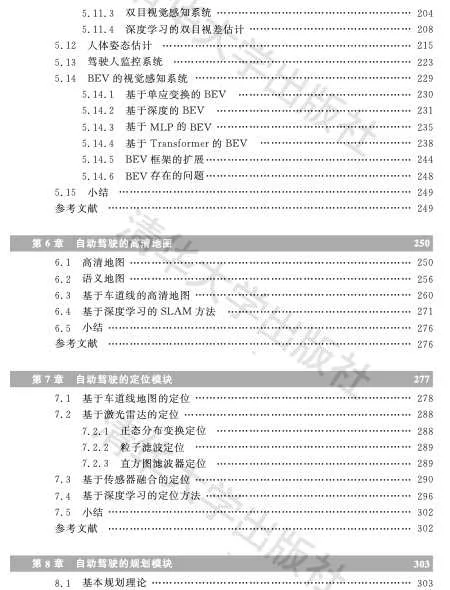

• 本書真正的重頭戲是第5~9章,即感知、高畫質地圖、定位、規劃和控制。感知部份涉及了多種傳感器標定、單目測距、深度圖估計、3D 障礙物檢測和跟蹤、傳感器融合(數據級和任務級)、車道線檢測、交通標誌檢測辨識、交通訊號燈檢測識 別、雙目視覺、駕駛區域分割、人體姿態估計、駕駛人監控系統和新一代 BEV 感 知框架等;高畫質地圖部份介紹了高畫質地圖的結構、語意地圖的構建、基於車道線 地圖和基於深度學習的 SLAM 等;定位部份和高畫質地圖部份不可分,包括基於 車道線地圖的定位、基於激光雷達的地圖定位、傳感器融合的混合式定位以及 基於深度學習的定位方法;規劃部份涉及基本的規劃理論、對駕駛行為的建模 預測、行人行為的建模預測和基於深度學習的模仿學習等;控制方法相對來說 比較傳統,但是在回顧經典的車輛運動學和動力學模型、控制理論(如 PID 和 MPC)之 外 ,也 討 論 了 基 於 深 度 學 習 的 控 制 理 論 。

作者的前言片段摘錄:

「自動駕駛的發展基本存在兩條技術路線。一個是跨越式開發,即直接做L4級別的自動駕駛系統,以高科技公司谷歌和百度為主,他們對車企行業了解不深,把機器人研發的模式用於自動駕駛車輛。註:據說谷歌也曾想從L3級別做起,但是實驗發現測試人員一段時間以後很容易相信電腦系統,失去監控的耐心。這個技術路線多半不計成本,采用高畫質地圖和高精密度慣導定位,可沒有地圖的地方也很難營運(不需要和導航地圖介面,直接采用高畫質地圖進行規劃,對於大規模導航區域的高畫質地圖下載和全域規劃的計算復雜度缺乏認識),安裝激光雷達這種最好最昂貴的傳感器(當時視覺的深度學習技術比較初級),采用最強的計算平台(因為不是量產,一些L4自動駕駛公司直接采用工控機作為支撐,不需要考慮平台移植的工程難度),面向robotaxi的落地,雖然還沒有針對任意場景,但在測試的高速和城市街道場景中,基於較可靠的感知效能,的確提供了面向復雜交通環境下最強的規劃決策能力。目前看到的基於數據驅動開發的規劃決策演算法,多半來自於L4公司,而且其中幾個還舉辦了這方面的競賽(基於本身提供的開源數據集)。在仿真平台的建設上,也是L4公司遠遠走在前面(特斯拉基本已經具備L4開發落地能力),包括數據重放和單點測試的視覺化能力。高畫質地圖方面,L4公司的技術也比較成熟。收集的傳感器數據,L4公司在包括激光雷達和車輛定位軌跡等方面,也高於一般的L2公司。

另一條路線是漸進式開發,即先從L2級別的輔助自動駕駛系統起步,然後逐漸適應更復雜的交通環境,從高速高架慢慢過渡到有閘道有收費站的場景,然後進入城市大街和小路,自動駕駛系統的級別也慢慢演進到L2+、L3、L3+和L4水平。註:最近看到一種新趨勢,即L4自動駕駛級別的開發公司,和L2級別自動駕駛的主機廠和Tier-1合作,共同開發L2+的量產級別車輛。漸進式開發的技術路線,一般是主機廠和Tier-1采用,他們首先會考慮成本、車規和量產使用者的ODD定義。早先以mobileye為主要供應商,之後特斯拉和輝達的開發模式成為主流。因為成本,所以這種路線多半采用網絡攝影機為主傳感器,加上車企已經接受的毫米波雷達為輔助。相對來說,這個路線的前沿水平(比如特斯拉)基本上視覺感知的能力尤其突出。因為在融合中雷達出現大量虛警訊號,特斯拉甚至在自動駕駛感知模組中放棄了它。以前泊車自動駕駛采用超聲波傳感器,逐漸也和魚眼網絡攝影機結合提供泊車輔助、記憶泊車甚至代客泊車的套用。特斯拉也采用超聲波提供擁擠交通場景的感知。也許是成本的壓力,漸進路線一般是「重感知、輕高畫質地圖」的模式,甚至特斯拉已經在BEV網絡模型中實作了感知和線上地圖及定位的端到端整合。作為行業領軍企業的特斯拉,慢慢完善了數據驅動的開發工具鏈,實作了一個包括數據篩選、數據標註、仿真模擬、模型叠代、場景測試評估和模型部署等的數據閉環。基於自動駕駛的長尾問題和AI模型的不確定問題,谷歌也有類似的框架,但特斯拉將其發揮到極致,在量產的使用者車輛上實作了良性迴圈,目前也已經推出L4級別的自動駕駛版本FSD。

自動駕駛基本存在1.0和2.0兩個發展階段。自動駕駛1.0時代采用多種傳感器構成感知輸入,比如激光雷達(Lidar)、視覺相機、雷達(Radar)、慣導IMU、輪速計和GPS/差分GPS等,各個傳感器在感知能力上存在差異,針對性用多模態傳感器融合架構,目前多是采用後融合策略,把各個傳感器在相關任務的結果進行一次濾波,達到互補或者冗余的效果。這方面存在兩種路線,一是依靠激光雷達加高畫質地圖的做法,成本高,主要是robotaxi等L4公司采用,另一個是視覺為主、輕高畫質地圖的道路,成本低,多是L2/L2+自動駕駛公司為量產落地的思路。兩種路線都是會有很傳統的後處理步驟(特別是視覺),大量偵錯工作和問題也來自於此。另外,這個階段的規劃決策多是采用基於規則的方法,實際上沒有數據驅動的模型,比如開源的Autoware和百度Apollo。L4公司由於執行場景在一些具備高畫質地圖的固定地區,本身感知投入的傳感器精度較高,已經做過數據訓練規劃決策模型的探索;相對來說,L2/L2+公司還沒有建立數據驅動的規劃決策模組開發模式,多是采用最佳化理論的解決方案,普遍從高速場景入手,升級到特斯拉那種「閘道-到-閘道」的模式,很少能支持城市自動駕駛的復雜場景(比如環島路口和無保護左拐彎操作等)。

自動駕駛2.0時代應該是以數據驅動為標誌,同時對於1.0階段的感知框架也有比較大的改進。數據驅動的開發模式傾向於端到端的模型設計和訓練,對於規劃決策而言就是需要大量的駕駛數據去學習「老司機」的駕駛行為,包括行為複制的模仿學習,以及透過基於模型強化學習(M-RL)估計行為-策略的聯合分布等,不再靠各種約束條件下的最優問題求解。其中軌跡預測是一個重要的前奏,需要對智體互動行為做良好的建模,並分析存在的不確定性影響。對於感知而言,2.0時代需要考慮機器學習模型取代那種傳統視覺或訊號處理(濾波)的部份,真正做到采集數據來解決問題的開發模式。比如特斯拉最近的BEV和Occupancy Network,都直接透過深度學習模型實作所需資訊輸出,而不是采用傳統視覺和融合理論去二次處理模型輸出。傳感器融合理論也從後融合升級到模型中特征級融合甚至數據融合(如果同步和標定有一定的先驗知識)。這裏可以看到Transformer網絡在這個感知框架下扮演著重要的角色,同時也給計算平台提出了更高的要求。基於這種數據驅動的自動駕駛平台需求,大模型的設計思路也被引入,因為大量數據的獲取,包括高效的數據篩選、自動標註和仿真技術輔助,需要在伺服器維護一個老師大模型支持各種布置到車端的學生小模型訓練和叠代升級。」

本書的目錄如下:

關於各章的內容,下面做逐個開頭介紹,並摘錄一些內容片段:

第一章、概論

自動駕駛系統的認知中有一些模糊的地方,比如自動駕駛系統如何定義的問題,自動駕駛的研發為什麽會有那麽多的子模組,怎麽才算自動駕駛落地等等。本章想先給讀者一個概括介紹,了解自動駕駛的分級方法,搞清楚自動駕駛的模組化開發和端到端學習開發的區別,以及都有哪些自動駕駛的套用場景。

本章1.1介紹自動駕駛的分級系統,1.2簡介系統的模組化結構和開發方法,而1.3是不常用的端到端的系統開發思路, 1.4介紹自動駕駛的落地場景分類,最後1.5引入數據閉環這個開發平台概念。

關於數據閉環的介紹:

第二章、基礎理論

自動駕駛系統的開發需要掌握一些專業知識,最根本的是機器學習和深度學習,此外還需要有電腦視覺和影像處理的基礎,也涉及一些數值計算和最佳化演算法的知識。

該章無法深入地對這些領域做詳細的介紹,只能是基本概念和演算法的一個快速瀏覽,中間會抽取關鍵點進行深入介紹。如果真正想全面學習和掌握這些知識,還需要閱讀專門的論文和著作。

首先2.1介紹電腦視覺的框架,重點取幾個關鍵點進行分析,比如SIFT特征提取、網絡攝影機的標定、運動估計和運動恢複結構(SFM),其實另外一些模組,比如立體視覺(stereo vision)、單目形狀重建(shape from X)還有目標檢測/辨識/跟蹤/分割,都會在第5章感知中重點介紹,這裏不再重復;2.2簡介影像處理理論,特別分析兩種影像去噪的演算法,即雙邊濾波(BLF,Bilateral filtering)和非鄰域均值(Non-local Means,NLM)濾波;2.3是最佳化理論一覽,特別討論了兩種常見的非線性LS方法,G-N法和L-M法;2.4概述機器學習的理論,重點介紹常用的支持向量機和隨機森林;2.5對深度學習理論進行了概述,其中對摺積神經網絡(CNN)、遞迴神經網絡(RNN)、生成對抗網絡(GAN)和Transformer重點討論。

關於機器學習的一段討論:

第三章、硬件平台

自動駕駛汽車相比於傳統汽車的主要區別在於其裝備有大量新傳感器和支持自動駕駛演算法的強大計算硬件。這裏討論的自動駕駛硬件平台主要包括有車體控制部份、線控地盤、傳感器和計算平台。

另外,隨著「軟件定義汽車(SDV)」的大潮,電子電氣架構(EEA)也出現了新的演進和發展,包括滑板底盤的出現。而智能汽車的發展,包括智能駕駛汽車,順應了當今汽車「新四化」(電動化、網聯化、智能化和共享化)的變革趨勢,也推動電腦技術、通訊網絡技術、人工智能和大數據雲端運算等在汽車產業的深入套用。

本章3.1介紹傳感器,即網絡攝影機、激光雷達、毫米波雷達、超聲波雷達、慣導(IMU)、導航系統(GPS)和車聯網(V2X),3.2是簡述車體控制,包括VCU/ECU/MCU、CAN總線、ESP和EPS,3.3主要討論目前的商業計算平台,主要是幾家如Intel Mobileye的 EQ系列,Nvidia公司的Drive Xavier和Orin,TI 的TDA4VM和Qualcomm公司 的Ride,3.4介紹線控底盤技術,3.5主要討論汽車電子電氣架構的技術。

關於激光雷達的缺點片段:

關於雷達的分析片段:

關於雷達新技術的討論片段:

第四章、軟件平台

隨著自動駕駛技術的發展,有更多的軟件公司投入到自動駕駛軟件平台的開發,比如Nvidia的商用化產品DriveWorks,以及百度開源的阿波羅。

當今汽車智能化的大趨勢下,「軟件定義汽車」成為產業共識。相較於傳統汽車,智能汽車的目標是創造全新的駕駛體驗,這也是形成差異化的關鍵。因此,軟件和演算法逐步成為了汽車產業的競爭核心要素,同時車輛制造的門檻也由從前的上萬個零部件整合能力演變成將上億行程式碼組合執行的能力。

隨著汽車電子電氣架構(EEA)的演進,智能汽車軟件架構也漸漸從面向訊號架構(Signal-Oriented Architecture)向面向服務架構(Service-Oriented Architecture)轉型升級。面向服務架構(SOA)作為一種軟件設計方法和理念,具備介面標準化、松耦合、靈活易於擴充套件等特點。

自動駕駛軟件平台基本可分成以下三個層次:

當今在汽車軟件平台開發中,最有名的是AUTOSAR聯盟,它提出了一個開源的軟件開發標準。在傳統軟件開發V-模型基礎上,汽車軟件設計標準aSPICE以及著名的功能安全標準ISO 26262,都提出了各自的軟件開發流程。

下面詳細地討論自動駕駛軟件平台的問題。4.1介紹汽車行業的軟件架構標準AUTOSAR,4.2軟件開發過程中著名的V-模型,4.3簡述一個汽車軟件設計流程標準aSPICE,4.4介紹著名的安全標準ISO 26262定義的軟件開發流程,4.5是Nvidia開發的自動駕駛軟件框架DriveWorks,而4.6分析自動駕駛采用的作業系統平台, 4.7介紹一下自動駕駛雲平台,最後4.8介紹DevOps和MLOps。

關於中介軟體的介紹片段:

關於模型訓練的並列分布式介紹片段:「

第五章、感知模組

我們俗稱自動駕駛要回答幾個問題:

感知模組相當於自動駕駛車輛的「眼睛」,它跟傳感器直接相接,獲取大量傳感器的數據輸入,然後分析處理後得到周圍環境的理解,包括障礙物檢測,跟蹤和距離估計,車道辨識和分割,交通標誌和紅綠燈辨識等。由於現在自動駕駛系統都是裝載多個多種傳感器,所以傳感器融合是必要的也是重要的感知部份,甚至一些系統把它單獨列出來,獨立於感知模組。

本章從5.1車載各種傳感器的標定開始,5.2介紹了單目網絡攝影機測距的各種方法,以及5.3單目影像的深度估計演算法;接著5.4分析了目前單目網絡攝影機的3-D障礙物檢測方法,即3-D目標長方體框在影像的投影而不是2-D矩形框而已;然後5.5對障礙物跟蹤方法展開討論,包括單目標和多目標情形;傳感器融合是重要的問題,5.6從數據級和任務級兩個層次分析了融合的方法;5.7、5.8和5.9主要討論車載視覺系統關心的三個問題:車道線檢測、交通牌辨識和紅綠燈辨識; 5.10重點討論視覺網絡攝影機看到的可駕駛區域問題,即語意的道路分割;5.11是基於立體視覺的感知模組分析;由於行人的行為分析需要,人體姿態估計在5.12討論; 5.13特別提到駕駛員監控系統(DMS)的實作演算法;5.14對當前最新的BEV感知系統做深入討論。

關於單目深度圖估計的神經網絡方法片段:

關於傳感器融合的片段:

關於立體視覺的介紹片段:

關於BEV感知網絡的介紹片段:

第六章、高畫質地圖

「高畫質地圖(HD map)」概念於2010年Mercedes-Benz首次引入,隨後於2013年為Bertha Drive 專案做出貢獻。在Bertha Drive專案中,Mercedes-Benz S500以完全自主的模式完成了Bertha-Benz Memorial Route,使用高度精確且資訊豐富的3D路線圖,該路線圖後來被一家名為HERE的參與地圖公司命名為「高畫質(HD)即時地圖」。

高畫質地圖(HD Map),在自動駕駛領域被看得很重,因為它能提供先驗知識,讓感知難度降低,同時規劃有的放矢。

高畫質地圖不是新的東西,已經有一些地圖和自動駕駛公司開始制作和使用HD Map。但是,HD Map的制作和包含的資訊以及精度仍然沒有統一的共識。

本章6.1首先介紹高畫質地圖的基本類別、層次、格式和制作方法,然後6.2重點討論語意地圖的各種生成方法,6.3強調車道線級別高畫質地圖的制作方法,最後6.4介紹基於深度學習的SLAM方法。

高畫質地圖制作的介紹片段:

第七章、定位模組

就道路上的自動駕駛車輛而言,首先重要的任務之一是將車輛定位在道路上。為此,車輛需要考慮來自多個傳感器的資訊,並將其與來自道路地圖的數據融合。道路定位問題可以歸結為三個部份:第一個是車輛當前行駛的道路確定;事實上,全球導航衛星系統還不夠精確,無法自行推斷出這些資訊,因此需要一個濾波步驟;第二個是估計車輛在車道中的位置;最後第三個是評估車輛當前行駛的車道。這裏討論主要限於後兩個部份,因為第一個在基於導航地圖的定位中已經有成熟的方案,比如地圖匹配(車輛位置與地圖的路網相匹配)等。

有兩種技術適合這個任務。第一種方法取決於高畫質地圖儲存的地標精確位置(例如車道標記),系統必須將檢測的地標與地圖中儲存的地標相匹配。第二種技術完全依賴於車載傳感器檢測視覺地標,例如道路上的所有車道;然而,由於其他車輛的遮擋,有時無法檢測到道路上所有車道標記;提取的相關道路級特征送入一個高級融合框架,該框架評估車道數和車輛行駛的車道。本章只限於討論第一種方法。

基於地圖的定位實際上分成兩個階段。在位置辨識(place recognition)階段,將傳感器輸出與一組地理標記的感興趣地圖區域進行比較,確定車輛在地圖中的初始位置。隨後,在地圖度量定位(map metric localization)階段,不斷將傳感器輸出與經過的地圖當前區域對齊,這樣車輛在地圖上運動的同時被跟蹤。

因此,定位需要感知模組提供數據輸入和地圖的資訊進行匹配;那麽類似於感知模組,定位模組也會采用傳感器融合的思路,即采用GPS/DGPS(如RTK),IMU,網絡攝影機,激光雷達加高畫質地圖的組合。

GPS定位是經典的方法,但是環境中電磁波的傳播會因為天氣、大氣層,高樓大廈和山丘等因素產生時間誤差,並造成估計的距離誤差。為了補償部份誤差,提出了差分GPS即DGPS,比如RTK技術。千尋網絡背靠中國兵器工業集團和阿裏巴巴集團兩個大公司,在全國提供這方面的服務。

還有另外兩個定位演算法:分為裏程計法和慣性導航法。裏程計( Odometry ) 是一種被廣泛套用的方式,透過安裝在車輪上的光電編碼器(wheel encoder)記錄車輛的運動過程從而估計其位置。慣性導航法(IMU)則利用加速度計和陀螺儀實作定位,裏程計由於輪子側滑會帶來誤差,而慣導的積分累積誤差也會帶來困擾,裏程計和慣性導航的定位精度一般比較差,最好和GPS或者激光雷達/網絡攝影機聯合使用實作航位推測(dead reckoning)。

激光雷達點雲數據做定位的方法,是要求感知輸入的激光雷達點雲(有的方法允許反射圖)和高畫質地圖的點雲匹配,直接ICP計算量太大。大家熟悉的演算法,常用的有正態分布變換(NDT,normal distributions transform),還有史丹福大學的直方圖濾波器(histogram filter)和粒子濾波(particle filter)之類。演算法要求車載系統有激光雷達傳感器,能夠即時采集現場點雲數據。也有壓縮點雲數據的快速匹配定位方法,比如TomTom的RoadDNA,Civil Maps的指紋圖(Fingerprint Map),定位難度和精度上會有所折衷。

網絡攝影機定位是視覺裏程計或者視覺SLAM采用的,以前有不少研究「基於影像的重定位(Image-based Re-localization)」問題,用於SLAM的閉環(loop closure)檢測和跟蹤失敗(tracking failure)恢復等等。SLAM方法包括稀疏法、致密法和半致密法,但在自動駕駛這個場景中,稀疏法是最合適的。不過,單純靠視覺的特征點來實作定位是不足的,還需要語意目標的輔助,即語意地圖。在自動駕駛中,語意地圖最實用的是基於車道線的地圖。

本章是前一章高畫質地圖的銜接,首先7.1介紹低成本的基於車道線地圖的定位技術,然後7.2討論基於激光雷達的定位演算法,接著7.3分析多傳感器的融合定位方法,最後7.4介紹基於深度學習的定位方法。

基於深度學習的視覺定位分析片段:

第八章、規劃(包括預測)模組

自動駕駛中的規劃模組是確定車輛的動作,它基於輸入的感知結果,而結果將送入控制模組確定車輛的實際操作。前面提到感知相當於自動駕駛的「眼睛「,那麽規劃的作用就相當於」大腦「,是非常重要的模組。

首先,需要確定幾個專業詞的表述:路線 = route;路徑 = path;軌跡 = trajectory。

本章8.1首先介紹基本的規劃理論,分三個層次,即路線規劃、行為規劃和運動規劃;8.2討論駕駛行為建模和預測,主要是基於數據驅動的機器學習方法;8.3擴充套件到行人行為的建模和預測問題;最後8.4附帶討論如何學習老司機的駕駛技術,是8.2課題的深入。

關於運動規劃的討論片段:

關於神經規劃器的介紹片段:

關於車輛預測方法的分析片段:

第九章、控制模組

前 面 提 到 感 知 是 自 動 駕 駛 的 「眼 睛 」,規 劃 是 自 動 駕 駛 的 「大 腦 」, 而控制就是自動駕駛的「四肢」。

自動駕駛系統的執行力也稱為運動控制,是將意圖轉換為動作的過 程;其主要目的是向硬件提供必要的輸入來執行規劃的意圖,從而生成 所需的運動。控制器根據力量對映現實世界中的互動,而自動駕駛系統 中的認知導航和規劃演算法通常關註車輛相對於其環境的速度和位置。控 制系統內部的測量值用於確定系統的效能,因此控制器做出反應,拒絕幹 擾並將系統的動力學改變為所需狀態。

自動駕駛的控制也看成是運動控制,就是為車輛生成指令,一般為線 控 (wire-control)模 式 ,即 方 向 盤 控 制 的 角 度 ,加 速 踏 板 和 制 動 踏 板 控 制 的速度或加速度,同時在實際環境下(道路、風、車滾軸溜冰移等)產生實際行 駛軌跡。

首 先 ,需 要 確 定 幾 個 專 業 詞 的 表 述 : 路 線 = route 、路 徑 = path 、軌跡 =trajectory。

車輛的運動控制可以大致分為兩個任務:車輛橫向運動的轉向控制和縱向運動的加速踏板和制動踏板控制。橫向控制系統旨在控制車輛在 車道上的位置,並執行其他橫向動作,例如變道或避免碰撞的動作。縱向 控制可控制車輛的加速度,使其在道路上保持理想的速度,與前一輛車輛 保持安全距離,避免追尾事故。 當前傳統的車輛控制方法建立在經典的最優控制理論基礎上,該理 論可以表述為在一組狀態和控制動作上定義的成本函數。控制輸入通常 定義在有限時間範圍內,並限制在可行狀態空間。這樣透過基於規則的 控制器對自動駕駛車輛進行操作,其中參數由開發人員設定,並在模擬和 現場測試後手動調整。 而深度學習不必在所有可預見場景保持效能條件下反復調整每個參 數,而是使開發人員能夠描述所需的行為,並透過學習讓系統表現良好, 並將其推廣到新的環境中。學習演算法可以作為學習控制器的一部份,在 運動控制模組中使用,也可以作為完整的終端控制系統使用,該系統將傳 感器數據直接對映到控制命令,即端到端方法。

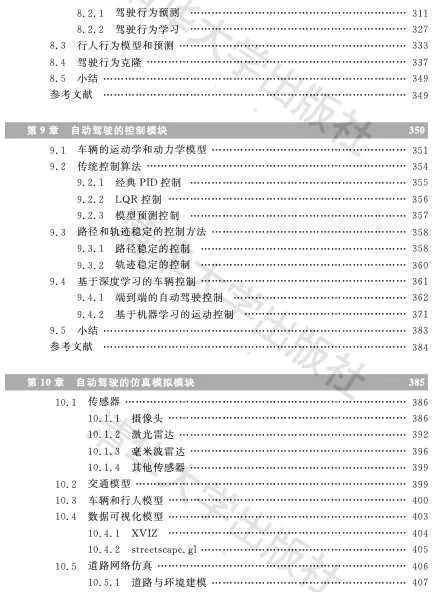

本章9.1先介紹車輛的運動學和動力學模型,這是車輛控制的基礎;9.2介紹傳統的控制演算法,即PID、LQR和MPC;9.3討論自動駕駛普遍采用的路徑和軌跡穩定的控制演算法,包括純跟蹤控制、後輪位置反饋、前輪位置反饋、基於控制Lyapunov函數的反饋控制和線性化輸出的反饋控制等;最後,9.4討論基於深度學習的自動駕駛控制演算法。

摘錄自動駕駛控制模型的分析片段:

第十章、仿真模擬

在現實世界中測試自動駕駛技術的效能和安全是一個巨大的工程。 通 常 認 為 , 大 概 需 要 1 0 0 億 英 裏 (1 英 裏 ≈ 1 .6 0 9 千 米 ) 的 試 駕 數 據 來 優 化一個開發的自動駕駛系統,即便是組建一支1000輛車的車隊也需要花 費約50年的時間完成。由於無法進行充分的道路測試(道路測試需要 投入的時間和費用極其昂貴),因此需要基於電腦模擬仿真系統幫助在 虛擬環境中開發和測試自動駕駛系統。

眾所周知,谷歌公司開發的仿真系統 CarCraft已經跑了超過150億 英 裏 (每 天 超 過 1000 萬 英 裏 ),而 實 際 車 載 測 試 才 1800 萬 英 裏 (每 個 月 大 概測試100萬英裏)。其中將實際上車測試的問題在模擬仿真系統中進 行 復 現 並 添 加 各 種 變 化 被 稱 為 「模 糊 化 」(fuz zing ),當 時 開 發 的 可 視 化 平 台Xview就是模擬仿真系統的一部份,相當於偵錯視覺化的顯示界面。

這樣的模擬仿真系統的構成一般包括多個演算法模組,例如:

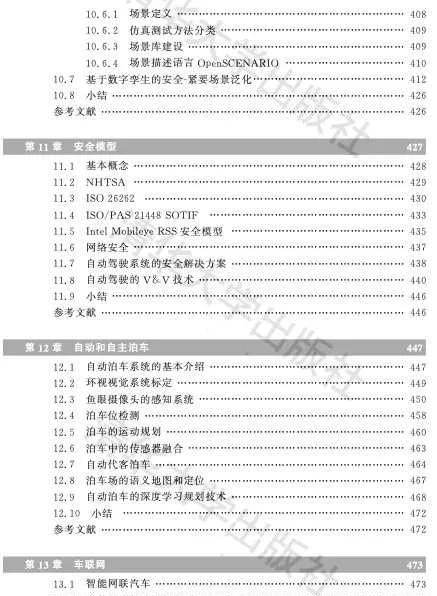

本章介紹一些搭建仿真系統的模組。10.1介紹傳感器的仿真,比如網絡攝影機的圖形學成像技術,激光雷達和毫米波雷達的數據模擬合成等;10.2以開源軟件SUMO為基礎,介紹交通仿真模型;10.3介紹車輛和行人CAD模型,並討論深度學習建模的車輛動力學,另外介紹了一些電腦視覺方法方面渲染人體和人體運動的研究;10.4以美國網約出租車公司Uber開源的視覺化平台為例,介紹自動駕駛的視覺化技術;10.5介紹道路網絡仿真環境的建立;10.6分析場景庫的自動駕駛測試技術(包括場景描述語言OpenSCENARIO 和場景庫例子 PEGASUS);最後10.7討論數碼孿生構建安全緊要數據的神經網絡方法。

摘錄場景定義的片段:

十一章、安全模型

安全一直是車輛行業非常重視的問題,而研發自動駕駛的初衷也是 降低人為因素的交通事故。美國權威機構的2018年報告顯示,美國每天 有超過100人死於與非自動駕駛汽車有關的交通事故。同樣一項被廣泛 參照的研究顯示,近兩年半美國發生了200多萬起撞車事故,其中94% 的事故是由司機造成的。

不過,在自動駕駛即將進入商業落地軌域時,大家發現以前的安全標 準和測試過程有些不適合,故對一些新的測試自動駕駛系統的安全標準 進行了修訂。 自動駕駛的關鍵模組,如感知、規劃和控制等,大量地使用了 AI,例 如,電腦視覺、機器學習和深度神經網絡的演算法,但一般這些演算法多半 是概率地對待解決的問題建模,這無疑對過去的安全模型和測試方法是 一種新的挑戰。

自動駕駛研發的公司也在探討這些問題,並提出了自己的安全模型, 如 Mobileye 的 RSS 模 型 和 NVIDIA 的 SFF 模 型 。 不 少 自 動 駕 駛 公 司 (主要是L4級別)紛紛釋出了自己的安全報告,如谷歌 WayMo、福特、 G M 、N VIDIA 、Uber 和 AutoX 等 。 自動駕駛仍然受到來自不同攻擊的威脅困擾,這些攻擊可以分為物理攻擊、網絡攻擊和基於學習的對抗性攻擊。不可避免的是,基於深度學 習 的 自 動 駕 駛 系 統 ,其 安 全 性 (safety&security)受 到 這 些 攻 擊 的 嚴 重 挑 戰,因此應研究對策,減輕潛在的風險。 如果自動駕駛能夠量產或者大規模部署,需要對其進行大量的驗證 和確認(V&V)。驗證與確認最大化場景覆蓋率的常見策略是在虛擬仿 真中進行,並模擬生成大量場景樣本。

基於場景采樣的 V&V 所面臨的挑戰是,確定合理覆蓋所需的樣本量, 從而使得自動駕駛不當操作所產生的風險得以控制。然而,另一組基於形式驗 證 (formalverification)的 方 法 通 過 規 範 滿 足 (specificationsatisfaction)處 理場景覆蓋。

目前自動駕駛安全方面的開放性挑戰問題包括以下幾點。

本章11.1介紹一些安全基本概念,11.2分析NHTSA的12個安全要素,11.3介紹功能安全標準ISO26262,11.4討論預期功能安全標準SOTIF,11.5對Mobileye的安全模型RSS進行分析,11.6介紹網絡安全,而11.7闡述自動駕駛的安全隱患以及解決方案,最後11.8介紹自動駕駛系統的驗證和確認(V&V)技術。

摘錄Mobileye的安全模型片段:

第十二章、泊車

自動駕駛技術的產品落地涉及套用場景,所謂「麻雀雖小,五臟俱 全」,自動和自主泊車是一個有實際套用價值的場景。前面已經對自動駕 駛內部結構和演算法進行了分析和討論,本章將專註於自動泊車這個落地 場景,將前面討論的技術模組具體化展開。

其中12.1對泊車系統的基本介紹;12.2討論泊車系統特有的環視網絡攝影機系統如何標定;12.3介紹魚眼鏡頭的感知方法;12.4對泊車位檢測方法進行討論;12.5分析泊車的一些具體運動規劃演算法;12.6分析傳感器融合(超聲波和網絡攝影機)在自動泊車的體現;12.7針對自動代客泊車,也是泊車中最高級別的自動駕駛方法進行分析;12.8介紹泊車場的語意地圖制作和定位技術,12.9介紹自動泊車在泊車場的深度學習規劃方法。

摘錄泊車的規劃方法片段:

第十三章、車聯網

數碼化器材正變得越來越普遍並且相互聯系。這些器材向數碼生態系智能部份的演進創造了迄今為止尚未解決安全問題的新穎套用。一個特定的例子是車輛,隨著車輛從簡單的交通方式發展到具有新的感知和通訊功能的智能實體,就成為智能城市的活躍成員。

在第三章3.1.7節已經簡單介紹了車聯網(V2X)的基礎,即DSRC和Cellular-V2X通訊技術。車聯網包括透過V2V(車對車),V2I(車對基礎設施)和V2P(車對行人)互動而與公共網絡進行通訊的車輛,其收集和即時共享有關路網狀況的關鍵資訊。

使用車載單元,車輛可以彼此(V2V)和與路邊單元(V2I)進行通訊。這可以實作多種其他形式的通訊,例如車對寬頻雲(V2B)(其中車與監視數據中心進行通訊),車對人(V2H)這種脆弱的道路使用者即行人或單車進行通訊,或者車輛對傳感器(V2S)即車輛與環境中嵌入的傳感器進行通訊。

對於自動駕駛的車輛而言,和高畫質地圖的作用類似,車聯網本身就是一種傳感器的延伸,可以看成為「傳感器」。

與自動駕駛技術中常用的網絡攝影機或激光雷達相比,V2X技術具備突破視覺死角和跨越遮擋物獲取資訊的能力,同時也可以和其他車輛及設施共享即時駕駛狀態資訊,還可以透過研判演算法產生預測資訊。另外,V2X是唯一不受天氣狀況影響的「傳感器」技術,無論雨、霧或強光照射都不會影響其正常工作。因此V2X技術廣泛套用於交通運輸尤其是自動駕駛領域。

本章介紹車聯網在自動駕駛套用的技術。13.1討論智能網聯汽車(CAV)的發展;13.2介紹車聯網的社交特性及其AI元素;13.3對各種邊緣計算進行分析;13.4則討論車輛-路端的協同方法;13.5介紹車輛透過車聯網進行協同感知的技術;13.6討論編組車隊的規劃與控制。

關於感知協同的分析片段:

第十四章、神經渲染

合成照片級逼真的影像和影片是電腦圖形學的核心,也是幾十年來研究的焦點。傳統意義上,場景的合成影像是用渲染演算法(如光柵化或光線跟蹤)生成的,這些演算法將特別定義的幾何和材質內容表示作為輸入。總的來說,這些輸入定義了實際場景和渲染的內容,稱為場景表征(場景由一個或多個目標組成)。用可微分渲染的損失函數從觀測中重建這樣的場景表征被稱為逆圖形學或逆渲染。

神經渲染是一個迅速興起的領域,它可以緊湊地表示場景,透過神經網絡從現有的觀察中學習渲染。神經渲染的主要思想是將經典(基於物理學的)電腦圖形學的見解與深度學習的最新進展相結合。與經典電腦圖形學類似,神經渲染的目標是以一種可控的方式生成照片般真實的影像。例如,新視點合成、重打光、場景變形和合成。

"神經渲染 "這個術語經常被用於兩個不同的概念。第一種範式,是神經網絡被訓練為從一些2-D輸入訊號(如語意標簽或柵格化的智體幾何)直接對映到輸出影像,即把神經網絡訓練為一個渲染引擎。而另外一種範式,是一個神經網絡代表一個特定場景的形狀或外觀,並且代表用一個傳統的圖形 "引擎 "進行渲染,是以分析而不是學習方式去定義。與之前的範式不同,這個神經網絡並不學習如何渲染,而是學習以3-D方式表征一個場景,然後根據影像生成的物理學原理渲染該場景。神經輻射場(NeRF)就是這樣的技術之一,其利用體渲染生成場景影像。

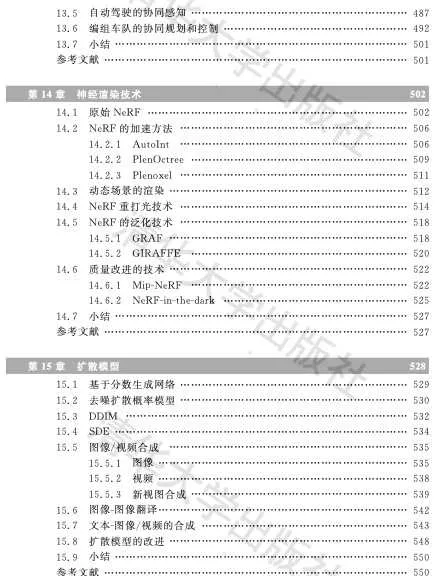

本章14.1是原始NeRF理論介紹,14.2討論NeRF的加速方法,包括自動積分(AutoInt)方法和Plenoxels模型,而14.3是討論動態場景的渲染技術,在14.4分析重打光方法, 14.5介紹NeRF的泛化問題,最後14.6介紹最新的質素改進方法。

關於NeRF的泛化分析片段:

第十五章、擴散模型

給定感興趣分布的觀測樣本x,生成模型的目標是學習對其真實數據分布p(x)建模。一旦完成學習,可以根據該近似模型隨意生成新的樣本。此外,在某些公式下,能夠用學習模型來評估觀測或采樣數據的似然。

生成對抗網絡(GAN)對復雜分布的采樣過程進行建模,以對抗方式學習。另一類生成模型被稱為「基於似然」,試圖學習一種為觀測數據樣本分配一個高似然的模型,包括自回歸(AR)模型、歸一化流(NF)和變分自編碼器(VAE)。有一種類似的方法,是基於能量的建模(EBM),其中一個分布被學習為一個任意靈活的能量函數,然後歸一化。

深度學習中生成模型類根據隱含參數隨機生成觀測結果。然而,目前的生成模型面臨四大問題,即生成過程緩慢(采樣效率低)、數據處理類別單一(泛化能力弱)、次優的似然和模型需要降維等。

最近,擴散模型憑借其強大的生成能力,成為生成模型的熱門之一。套用領域包括電腦視覺、語音生成、生物資訊學和自然語言處理等。

迄今為止,在電腦視覺領域中,擴散模型已被套用於各種生成式建模任務,如影像生成(image generation)、影像超分(mage super-resolution)、影像修復(image inpainting)、影像編輯(image editing)和影像轉譯(image-to-image translation)等。此外,擴散模型學習的潛表征在鑒別性任務中也很有用,例如影像分割、分類和異常檢測。

擴散概率模型最初是由非平衡熱力學(non-equilibrium thermodynamics)啟發而提出的潛變量生成模型。這類模型由兩個過程組成,第一個是正向過程,在多個尺度上添加雜訊,逐步幹擾數據分布。然後,第二個是反向過程,學習恢復數據結構。

本章涉及擴散模型的理論和套用。15.1討論帶Langevin動力學的基於分數生成網絡;15.2介紹去噪擴散概率模型;15.3分析去噪擴散隱式模型(DDIMs);15.4則討論封裝以前方法的SDE框架;15.5介紹擴散模型在影像和影片合成的套用;15.6討論另一個套用影像-影像轉譯;15.7介紹擴散模型的套用文本-影像/影片生成; 15.8總結擴散模型的一些改進方法。

關於文本-到-影像/影片合成的討論片段: