來源:機器之心Pro

機器之心報道

編輯:張倩

「機器學習一直生活在一個令機器人專家、化學家、生物學家和神經科學家羨慕不已的泡沫中,隨著它真正開始發揮作用,我們所有人都將遇到其他人多年來一直在應對的同樣的現實壁壘。」

有人說,機器人領域進展緩慢,甚至和機器學習的其他子領域相比顯得毫無進展。

谷歌 DeepMind 機器人科學家,SayCan、RT-1、RT-2 等具身智能專案參與者 Alex Irpan 同意這一說法。但他認為,這是因為機器人學是一個和現實緊密連線的領域,現實的復雜性決定了他們不免碰壁。他還指出,這些問題不是機器人技術所獨有的。同樣的問題也適用於大語言模型(LLM)等技術。這些模型在面對現實世界時,會遇到與機器人學類似的復雜性問題。

最近,他寫了一篇題為「The Tragedies of Reality Are Coming for You(現實的悲劇正在向你襲來)」的網誌來闡述這一觀點。

現實的悲劇正在向你襲來

2023 年,我參加了一次 ML 會議。夜未央,酒酣耳熱,話題轉到了一個問題上:「如果你能把任何一個機器學習子領域的資源都給另一個子領域,你會砍掉哪個,把資源給誰?」

我不記得別人是怎麽說的,但有一個人說他們會砍掉機器人。當我進一步追問時,他們說機器人技術進展太慢,相對於其他領域來說,什麽都沒有發生。

他們說機器人技術比純軟件的機器學習子領域進展緩慢,我認為他們說得沒錯,但我還想補充兩點:

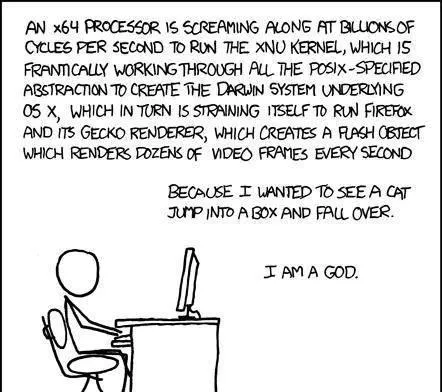

在機器人技術領域,人們常說的一句話是「現實是混亂的」。相對於程式碼而言,我會將其延伸為「現實是復雜的」。在機器人技術中,你往往要將混亂的現實推向一個足夠好的抽象層,以便程式碼能夠在其上發揮作用。作為一個領域,電腦科學花了數十年時間在硬件和軟件之間建立了良好的抽象層。程式碼描述了如何將電力輸送到硬碟、處理器和顯視器,它足夠可靠,我甚至不需要考慮它。

這樣做有很多好處。一旦你完成了這項艱巨的工作,並將你的工作進展轉移到抽象的邏輯空間中,一切都會變得更容易。程式碼和數據的可復制性令人難以置信。我在 3 台器材上同步了代表這篇博文草稿的檔副本,甚至不用花費任何精力思考。

不過,就像 Joel Spolsky 所說,所有抽象在某種程度上都有漏洞,而我發現機器人技術中的漏洞往往更大。有很多出錯的方式與程式碼的正確性無關。

這和這個學科的一些基本原理有關嗎?有一點。很多機器人硬件比筆記電腦或 Linux 伺服器更具實驗性。消費類機器人還不是一大產業。「實驗性」往往意味著「奇怪的、更容易出現故障的狀態」。

但是,我不認為硬件是造成問題的主要原因。現實才是問題的根源。Benjamin Holson 在他的「Mythical Non-Roboticist(神話般的非機器人學家)」一文中說得非常好:

第一個難點在於,機器人要處理的是現實世界中不完美的感知和不完美的執行。全域可變狀態是一種糟糕的編程風格,因為它真的很難處理,但對於機器人軟件來說,整個物理世界都是全域可變狀態,你只能不可靠地觀察它,並希望你的行動能接近你想要實作的目標。

機器人研究依賴於在現實與軟件之間搭建新的橋梁,但這也發生在機器人研究之外。任何與現實對接的軟件,對現實的了解都是不完美的。任何試圖影響現實世界變化的軟件,都必須應對現實的全域可變狀態。任何軟件,如果其行為依賴於現實中發生的事情,就會招致對抗性的雜訊和復雜性。

遊戲 AI 就是一個很好的例子。國際象棋 AI 是可靠的超人。然而,如果你以特定方式下棋,一些超人圍棋 AI 是可以擊敗的,正如 Tony T. Wang 等人在 ICML 2023 論文「Adversarial Policies Beat Superhuman Go AIs」中發現的那樣。對抗性技術找到了足夠清晰以至於人類可以復制的策略。

在附錄 G.2 中,我們的一位作者,一位圍棋專家,能夠在沒有任何演算法幫助的情況下,透過學習對手的對局記錄來實作這種 [cyclic] 攻擊。他們在 KGS 線上圍棋伺服器上以標準人類條件對局,在與作者無關的頂級 KataGo 機器人對局中取得了超過 90% 的勝率。

作者甚至在給機器人 9 個讓子的情況下獲勝,這是一個巨大的優勢:擁有這些讓子的人類職業棋手在面對任何對手(無論是人類還是人工智能)時,勝率幾乎都是 100%。他們還擊敗了 KataGo 和 Leela Zero,二者每局棋的搜尋次數都達到了 10 萬次,這通常遠遠超出了人類的能力範圍。此後,其他人類也利用 cyclic 攻擊擊敗了其他各種頂級圍棋 AI。

與此同時,幾年前,OpenAI 建立了一個系統,該系統擊敗了 Dota 2 的衛冕世界冠軍。在向公眾開放該系統以測試其穩健性後,一個團隊設計了一套策略,取得了 10 場連勝。

基於這一點,你可能會持一種悲觀的觀點,認為即使是連線 19 x 19 圍棋棋盤或 Dota 2 這樣一個簡單的「現實」,其額外復雜性就足以使穩健行為具有挑戰性。我認為這種觀點有失公允,因為這兩個系統都沒有將穩健性作為最高目標,但我確實認為它們是一個有趣的案例研究。

最近,圍繞 LLM 的炒作浪潮一浪高過一浪 —— 他們能做什麽,他們能在哪裏套用。這其中隱含的一個信念是,LLM 可以極大地改變人們在工作和休閑中與技術互動的方式。換句話說,LLM 將改變我們與現實互動的方式。事實上,我也加入了這股炒作浪潮,具體來說,我懷疑基礎模型短期炒作過度,長期炒作不足。然而,這也意味著,對於一個歷來不善於考慮現實的領域來說,現實的一切混亂都將到來。

就在這個人說機器人技術是浪費資源的同一個 ML 會議上,我提到我們正在用真實機器人進行基礎模型實驗。有人說這似乎有點嚇人,我向他們保證這只是一個研究原型。但我也覺得 LLM 生成和執行軟件有點嚇人,我覺得他們隱隱擔心一個卻不擔心另一個很有意思。矽谷的人有點自相矛盾。他們既相信軟件能推動初創企業實作驚人的變革,又相信他們的軟件不值得深思或反省。我認為,位元世界與原子世界一樣,都是現實的一部份。它們在不同的層面上執行,但都是現實的一部份。

我註意到(有些幸災樂禍),LLM 從業者也開始遭遇之前機器人技術碰到過的痛點。比如「我們無法復制這些訓練,因為這太耗費資金了」。是啊,這個問題在機器人領域已經討論了至少十年。再比如,「我沒法讓必應告訴我【阿凡達 2】的上映日期,因為它一直在調出關於自己的新聞報道,並在生成前進行自我修正。」

我們現在所處的世界,任何公開的互聯網文本都會不可逆轉地影響檢索增強生成。歡迎來到全域可變狀態。每當我看到有人聲稱 ChatGPT 的行為出現了倒退,我就會想起我和其他人為了解釋機器人效能突然莫名下降而想出的各種「陰謀論」,以及問題究竟是出在模型、環境,還是我們的過度推斷。

俗話說「所有的機器人 demo 都在撒謊」,人們發現所有的 LLM demo 也都在撒謊。我認為,從根本上說,這是無法避免的,因為人類的註意力是有限的。重要的是評估謊言的類別、大小和重要性。他們是否展示了模型 / 機器人如何泛化?他們有沒有提到這些例子是如何精挑細選的?一旦將現實聯系起來,這些問題就會變得更加復雜。梅西目前看起來是個不錯的球員,但「他能在斯托克城寒冷的雨夜做到這一點嗎」?

讓問題變得復雜的是,這些問題的答案並不總是「否」。梅西可以在斯托克城的寒冷雨夜做到這一點。他足夠優秀。這讓問題變得困難,因為正確地回答一個「是」比正確地回答一個「否」要重要得多。隨著 LLM 越來越優秀,隨著 AI 在日常生活中越來越常見,作為一個社會,我們需要越來越善於判斷模型是否已經證明了自己。我對未來的主要擔憂之一,就是我們不善於評估模型是否已經證明了自己。

但是,我期望機器人學家會走在曲線的前面。在 LLM 操縱通用基準測試的說法出現之前,我們就在抱怨評估問題。早在「我們需要更好的數據覆蓋率」成為基礎模型預訓練團隊的口號之前,我們就在努力獲取足夠的數據,以捕捉自動駕駛的長尾效應。機器學習一直生活在一個令機器人專家、化學家、生物學家和神經科學家羨慕不已的泡沫中,隨著它真正開始發揮作用,我們所有人都將遇到其他人多年來一直在應對的同樣的現實壁壘。這些挑戰是可以克服的,但會很艱難。歡迎來到現實世界。歡迎來到痛苦的世界。

原文連結:https://www.alexirpan.com/2024/07/08/tragedies-of-reality.html