作者 | 徐豫

編輯 | 漠影

AI手機、AI PC、AI眼鏡等智能器材正逐步AI Agent化,但這些小型終端要用上大模型能力,還差一把關鍵鑰匙,即一套端邊雲聯動的解決方案。

智東西1月6日報道,目前, 大模型行業正呈現出端邊雲協同,以加速端智能場景落地的新趨勢 。

過去一年,智能門鎖、AI看護機、AI眼鏡、無人機等多種形態的端側AI產品密集湧入市場,主打輕量化部署,其內建的AI模型通常小而易用。 然而,端側器材的功耗和算力仍十分受限,涉及復雜計算的推理任務正在向邊緣和雲端轉移。

換句話說,大模型所具備的算力優勢與小模型側重的低成本部署之間,還缺少一座連線的橋梁。字節跳動旗下的雲服務平台火山引擎給出了它們的最新解法。

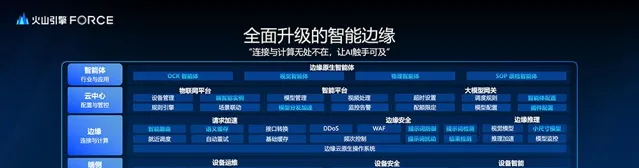

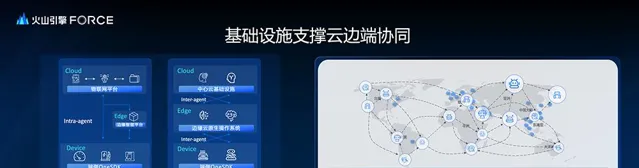

在2024年冬季火山引擎FORCE原動力大會上,火山引擎邊緣雲官宣全面升級其 智能邊緣 ,最佳化了物聯網平台、智能平台、邊緣大模型閘道器服務,並推出了邊緣原生智能體。這可以看作是一整套基礎設施,可以用這個系統 連線起端側小模型套用和邊雲大模型能力 。

火山引擎邊緣智能技術負責人謝皓解釋道,端側主要提供了OneSDK一站式解決方案,使得端側的嵌入式器材也能用上大模型;邊緣側上線了大模型閘道器,提升了大模型呼叫過程的效率和穩定性;中心側會編排一些智能體,降低大模型部署套用的難度;而邊緣原生智能體可面向不同行業客製個人化的智能體。

對於邊緣智能最新技術優勢、邊緣智能新套用場景和邊緣智能下一步發展重點,謝皓也向智東西分享了他的看法。

他認為,邊緣AI的發展當前可以分為基礎設施和套用場景兩個方面來看,前者主要負責解決連線和計算問題,並提供大模型排程和計算推理能力。而邊緣AI套用場景的發展目前仍受限於碎片化和難規模化,謝皓稱,一套支持端邊雲聯動的智能邊緣架構 多數情況可復用 ,在一定程度上能拓寬邊緣AI的部署範圍。

為什麽要強化AI Agent與大模型的連線,如何安全地實作計算任務的端邊雲協同處理,邊緣智能解決方案能應對AI Agent時代的哪些難題? 與火山引擎邊緣智能技術負責人謝皓深入溝通後,我們詳細拆解了一站式邊緣智能解決方案的兩大技術優勢。

一、大中小廠都在用,AI Agent調動大模型有新招

從卷大模型技術到卷大模型套用,2024年AI Agent生態迎來了小高潮。據Cookie.fun最新數據顯示,截至2025年1月4日,AI Agent整體市值已經達到 173.6億美元 ,過去7天的漲幅接近 50% 。

除了資本市場熱度升溫,AI Agent自身能力也得到快速發展。【福布斯】2024年12月底援引業內人士觀點稱,預計2025年將出現能夠依據簡短提示詞執行復雜任務的AI Agent。

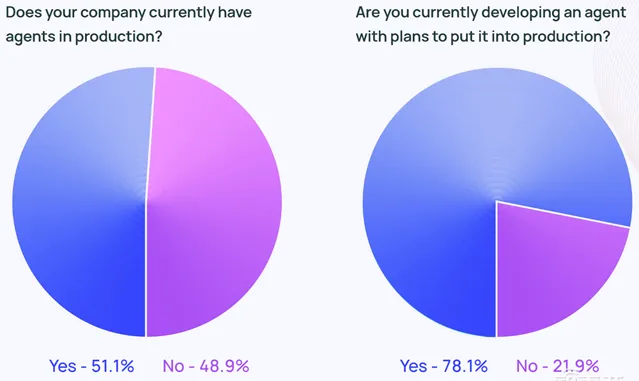

在LangChain一份針對2024年AI Agent現狀的調研報告中,1300多名受訪者超半數已經在生產過程中使用Agent。其中員工規模介於100至2000名的中型公司占比 63% ,最常用Agent來為生產過程提效。

如果該調研進一步擴大篩選範圍,把有計劃套用AI Agent或正在開發AI Agent的公司都算在內,那麽AI Agent的潛在和實際使用者比例則高達 78.1% 。

這也意味著,過去一年大多數公司有意願引入AI Agent,但可能實際部署時遇到了各式各樣的絆腳石,從而滯後了相關計劃。其中可能不乏一些早前積累了AI模型資源的公司,那麽基於一個更通用的邊緣AI基礎架構,按需把AI模型能力遷移至端側器材,或許是其新的出路。

據公開資訊顯示,國內的潤欣科技、地瓜機器人、上海一高校等不同領域的公司和單位,都開始加速落地大模型,以刺激業務增長。而這背後用到了火山引擎的邊緣智能基礎架構。

為了更好地適應AI Agent時代,該邊緣智能基礎架構最佳化了 4大方面 ,包括簡化端智能接入流程,提升邊緣雲推理請求的加速效能、推理能力和安全性,增強大模型檔分發、智能體配置等功能,以及新增了多個行業智能體。

謝皓接受智東西采訪時提到這套解決方案所涉及的AI模型,雲上服務主要使用豆包大模型,而解析提示詞等步驟則會用到一些帶有行業內容的、自家微調的傳統CV模型,或者開源的小模型。

二、會節約算力的智能決策器,私密安全為最高優先級

通常情況下,AI Agent需要依賴雲端伺服器為其提供大量的算力和演算法支持,但同時也面臨著算力資源爭搶和部署成本高昂的問題。相對於雲服務而言,端智能在本地器材等端側處理計算任務,能夠有效降低時延和運算成本。

端智能在落地過程中可能會遇到以下四個方面的挑戰,包括 多平台整合、多SDK適配、多重器材身份管理和多種模型協同 。對於上述多點聯動的難題,火山引擎邊緣智能上線了 OneSDK、OneCredential和OneStop端智能一站式服務解決方案 。

1、一站式軟件開發端智能解決方案OneSDK

端側會整合一個 軟體開發套件(SDK) ,基於該SDK可一站式解決線上升級(OTA)、日誌記錄、遠端登入、器材管理等器材運維需求,器材金鑰、器材證書等器材安全需求,以及多模型和多智能體呼叫的器材智能需求。

同時,端側還提供硬件抽象層(HAL)介面,以便在即時作業系統(RTOS)、其他嵌入式作業系統以及無作業系統的器材上遷移SDK。

2、一站式跨雲服務許可權端智能解決方案OneCredential

該解決方案 支持雲上多個平台間的身份互認和許可權穿透 ,使得器材端可共享一套金鑰和證書,從而允許存取邊緣大模型閘道器、物聯網平台等多項服務。

這一舉措將有效降低器材端的資源占用,以及多份證書的重復建立成本,並且也避免了重復身份認證所帶來的額外服務呼叫。同時,在滿足安全性的前提下,該做法還提升了器材端的整體效能。

另外,在OneCredential端智能解決方案中,每個器材粒度可按需token配額,以提供針對端側更劃得來的計量和計費策略。

3、一站式企業部署端智能解決方案OneStop

透過深度融合端雲技術,OneStop主要為企業降低了端側智能體的開發與接入門檻。

不過,上述端智能解決方案雖然給端側器材接入AI Agent提供了更多技術支持,但還不能一攬子突破端側AI的算力上限。由於算力和記憶體等條件的限制,端側AI大多采用的是小模型,這也導致其難以兼顧一些復雜的計算任務,或者更加多元化的套用場景。

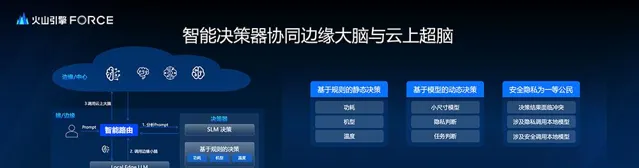

如果AI Agent消耗算力時,也可以「吃多少拿多少」, 自行匹配每次計算任務是呼叫端側的小模型,還是邊緣或雲端的大模型, 便能以性價比更高的方式應對較為復雜的人機互動場景。火山引擎邊緣雲2024年年底推出的智能決策器,就充當了這個分配過程的 總控室 。

據公開資訊顯示,該智能決策器可以依據 提示詞等 資訊,將任務按需分發至本地、邊緣或雲中處理。AI Agent推理請求難點主要是其對提示詞的理解,因此該智能決策器的前端設定了一套提示詞解析流程,即借助 一個 本地邊緣大模型解析提示詞 ,然後透過中心位的智能路由把解析結果傳輸給智能決策器。

那麽接到一個計算任務時,該智能決策器 如何界定 需要用到本地、邊緣還是雲端的AI模型來處理呢?

其對於計算任務復雜程度的定性主要考慮 兩大方面 ,一方面是基於規則的 靜態決策 ,會綜合考慮功耗、機型和溫度等因素;另一方面是基於模型的 動態決策 ,會從小模型、私密判斷和任務判斷等維度考量適用情況。

但當決策結果出現矛盾時,數據安全和私密將成為首要考慮原則。 其決策先後順序大致分為以下幾步:計算任務的安全和私密級別較高時,智能決策器的推理過程被要求僅呼叫本地模型;而計算任務的安全和私密級別適中時,智能決策器再結合計算任務的復雜程度分流,涉及私密的優先在本地處理,較為復雜的則傾向於排程至邊緣或雲端開展推理。

以 智能座艙 為例,車內網絡攝影機可能會拍攝記錄到一些涉及私密的對話和行為,謝皓稱這種情況下智能決策器會傾向於本地化處理,但如果是需要聯網、涉及影像外掛程式等較為復雜的操作,更多時候會交給雲上大模型處理。

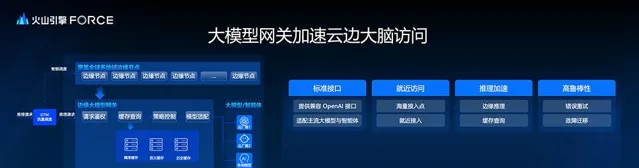

在智能決策器決定將推理請求轉發至本地器材外的過程中,具備標準介面、就近存取、推理加速和高魯棒性四大核心能力的火山引擎邊緣大模型閘道器,會提供進一步的支持,以提升邊緣和雲端「大腦」的存取效率。

具體來看,在 標準介面 方面,邊緣大模型閘道器適配 約20家 主流大模型廠商,以及多家智能體提供商,實作 與OpenAI相一致的標準介面 ,從而簡化了開發流程。

在 就近存取 方面,邊緣大模型閘道器透過全球範圍的邊緣節點和智能流量排程策略,來實作端側器材的就近快速接入,並降低延遲。

在 推理加速 方面,邊緣大模型閘道器采用了多種緩存技術和邊緣推理方法,有效提高了查詢速度,並增強了整體效能。

在 高魯棒性 上,邊緣大模型閘道器設定了跨模型廠商的故障遷移機制,並套用了錯誤重試策略,以此增強請求處理的魯棒性,使得計算任務處理的連續性和可靠性更強。

三、能聯動四方的邊緣原生智能體,支持AI Agent就近上雲

邊緣原生智能體是AI模型端側落地的一個重要形式。

火山引擎方面提出了邊緣原生智能體的四大必備能力,包括理解器材能力、連線物理世界、單智能體協同和多智能體協同。 這也各自對應了人機互動場景中動態捕捉和理解資訊、自主感知或操作器材、單智能體完成特定任務、多智能體配合完成復雜任務的需求。

其中,為了完善邊緣原生智能體自主感知、操作器材的效果,火山引擎選擇聯動自家的低程式碼平台「扣子」,透過客製外掛程式和工作流來實作邊緣智能與家用器材、工業器材、車載器材等物理世界實體的連線。火山引擎方面稱,目前邊緣原生智能體已套用於相關智能數碼工廠和智慧園區,涉及工業質檢、園區安防等領域。

現階段,火山引擎邊緣雲的分布式雲網基礎設施在海內外共有 2500多個 邊緣節點,其網絡時延控制在較低的 1至40毫秒 區間,支持 端邊互聯、邊邊互聯和邊雲互聯 場景,從而實作智能套用就近上雲。

同時智能套用從端側遷移到邊緣或雲端的過程中,無論是單智能體內部的端邊雲互傳,還是多智能體之間的協同連線,都依賴於一個安全傳輸網絡。對此,火山引擎邊緣雲在DDoS防護、邊緣WAF和頻次控制等傳統安全防護措施的基礎上,新增了針對AI Agent的邊緣安全防護功能, 包括提示詞檢測、系統提示詞防禦、結果檢查等 。

結語:從各司其職到取長補短,端邊雲協同成AI套用大勢

當前,雖然大模型種類、效能及其開發商都較為多元,可供支持部署AI Agent的選擇比較多,但芯片、算力、能源等大模型相關資源仍處於僧多粥少的階段,因此中小型公司在AI Agent的部署上,常常難以搶跑大公司。但如果只用成本較低的端側AI,又還不足以覆蓋公司所有的生產提效需求和場景。

端邊雲協同處理AI任務將有效降低AI套用部署的成本,節約算力和功耗,進一步降低中小型公司引入AI Agent的門檻。

同時,支持端邊雲協同的邊緣智能基礎架構,有助於不同行業快速借鑒、客製可行的AI模型落地樣本。從火山引擎邊緣雲現階段公開的成果來看,具身智能、端智能芯片、智能玩具、創新教育等行業內都拿出了實戰案例。