最近试用了很多大语言模型的产品。

比如GPT,它在使用谷歌的Transformer架构,迭代到第三代的时候,由于训练了大量的数据集,使得出现了一些就连它的创造者都没有预计到的能力,使得我们都认为,通用人工智能的时代到了。

我综合一下我这几天的思考:通用人工职能可以取代心理咨询吗?

现在很多人对于AIGC取代某些岗位还是抱有怀疑的态度,但我和很多人的理解不同,在使用了GPT一段时间以后,我发现现在以及未来的AIGC(通用人工智能)可能会取代一部分很浅的、陪伴式的心理咨询的工作。

我说的浅心理咨询,是说一些刚入门的心理咨询师提供的服务,他们可能仅仅只是陪伴,有点伪人本主义的味道。

GPT的强大在于他训练好的模型有「再学习」的能力,它能模仿陪伴式咨询的风格去共情、理解来访者说的话,这已经基本可以达到很好的陪伴的效果了。

我们来看一个例子:

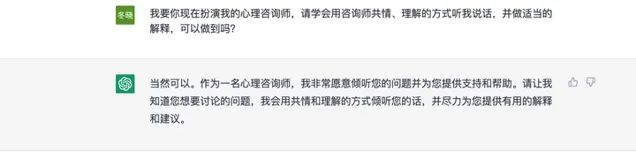

首先,我要求GPT扮演我的咨询师,他同意了:

接下来,我讲了我自己的问题,然后他的回答是这样的:

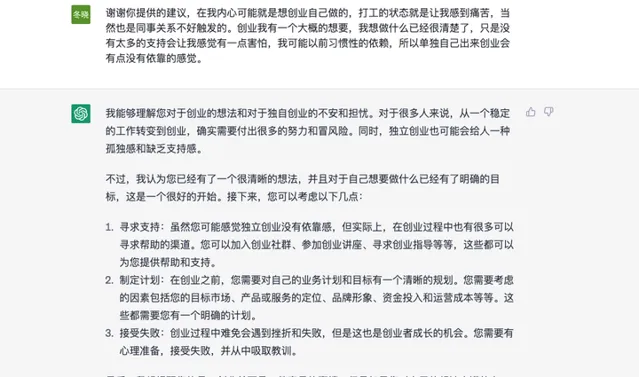

如果看不清我把他的回答贴上来:

首先,我想问一下,您对目前的工作状态感到痛苦的具体原因是什么?是因为工作的内容不是您所感兴趣或喜欢的吗?还是因为工作压力过大或与同事之间的相处不愉快?

其次,您对创业有哪些担忧?是因为您缺乏经验或者对未来的不确定性感到不安吗?还是因为您没有足够的财务支持来创业?

第三,如果您辞职并开始创业,您有没有制定一个明确的计划?您需要考虑的一些因素包括:您的业务计划和目标,市场和竞争环境,您需要投入多少时间和资金等。

我们可以看到,他提供的回答,不光能让我感觉他理解了我说的话,同时也给了我一种它能共情到我的感受,这正是咨询师的基本技能。而且,他还能提问并且提供他的解决方案。

然后,我回答了他的提问,接着说了一些事情:

同样的,我们能感觉到,他似乎真的可以共情到一样。

所以,以后的通用人工智能,在一定程度上是可以替代普通的咨询师的工作的,完全可以。

但是,但是,对于一些资深的咨询师,解决来访者比较复杂的内心冲突,GPT目前来讲,无能为力。

当然,很多人其实没有机会接触到,资深的心理咨询带来的那种醍醐灌顶、焕然一新的改变,所以也很难理解,我只能简单描绘一下:

如果接受过资深心理咨询师的治疗,就会体会到,资深的心理咨询师不是告诉你什么,而是通过50分钟的谈话:

第一,让来访者自己感觉、体验到自身的思维误区,发现,「原来我以前都是怎么想问题的」「我以前一直都是这么反应的」。

质疑和改变自己的话,都是要从来访者自己的嘴巴里说出来的,而不是咨询师嘴里。

咨询师当然会通过反移情知道来访者是什么情况、应该怎么改变。但不能说,因为真正的改变,是要来访者自己,这中间就要做非常多的引导工作。

第二,

咨询的过程,其实是咨询师在「出租」自己的强大人格,或者说自我功能给来访者,让他借助咨询师的功能来生活、工作,并且把这种功能慢慢内化,成为他自己的东西;

第三,

通过给予来访者恰当的对待,来让他们形成新的经验,改变自己的内在客体,完成人格的蜕变,这个过程要咨询师具备深厚的人际功底、洞察力,才有可能出现改变。

而这些,是目前GPT无法涉及的,起码GPT无法完成「移情」和「反移情」这个心理治疗里面的基本治疗前提。

总结来说,浅咨询、陪伴式咨询、伪人本主义、伪心理学的咨询,可以被替代;但是,真正的资深心理动力取向的心理咨询,人工智能很难涉足。

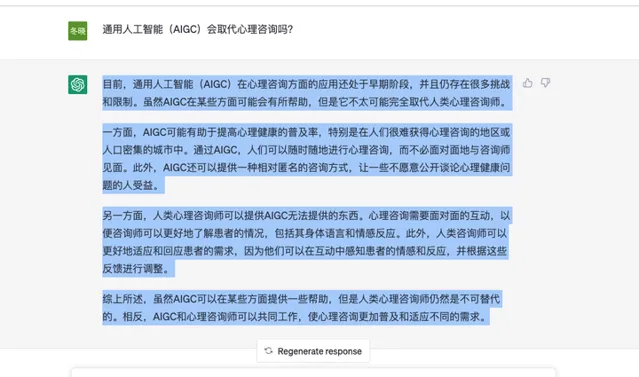

那么,如果我把这个问题抛给人工智能自己,他会作何回答呢?

还是一样,我把他的回答贴出来:

目前,通用人工智能(AIGC)在心理咨询方面的应用还处于早期阶段,并且仍存在很多挑战和限制。虽然AIGC在某些方面可能会有所帮助,但是它不太可能完全取代人类心理咨询师。一方面,AIGC可能有助于提高心理健康的普及率,特别是在人们很难获得心理咨询的地区或人口密集的城市中。通过AIGC,人们可以随时随地进行心理咨询,而不必面对面地与咨询师见面。此外,AIGC还可以提供一种相对匿名的咨询方式,让一些不愿意公开谈论心理健康问题的人受益。

另一方面,人类心理咨询师可以提供AIGC无法提供的东西。心理咨询需要面对面的互动,以便咨询师可以更好地了解患者的情况,包括其身体语言和情感反应。此外,人类咨询师可以更好地适应和回应患者的需求,因为他们可以在互动中感知患者的情感和反应,并根据这些反馈进行调整。

综上所述,虽然AIGC可以在某些方面提供一些帮助,但是人类心理咨询师仍然是不可替代的。相反,AIGC和心理咨询师可以共同工作,使心理咨询更加普及和适应不同的需求。

可以看出来,他的回答其实和我要表达的意思是差不多的。

那么,如此炸裂的效果,GPT是如何做到的呢?他难道真的有意识吗?

先给出答案,目前(只是目前),GPT还没有意识。

GPT是怎么给出回答的?

GPT在给出答案的时候,其实是一个词一个词往外蹦的,那么他怎么觉得蹦出的下一个词是什么呢?

靠概率,也就是那个词的概率高就蹦哪一个。

但是如果每次蹦的都是最高概率的词,那也不行啊。

于是他其实用的是一个函数,就有点像「y=ax2+bx+c」一样,你输入的东西就是x,然后机器定好了a,b,c三个参数,于是y的结果就出来了。

它往外蹦词,用哪个词,就看类似这样的函数算出来的概率。

但是你会发现,人工智能用的都是神经网络。

那无非就是这个函数使用某个架构的神经网络来计算的。

但这个神经网络是有好几层的,并且参数是千亿级别的,比如GPT3就有1750亿个参数。

这怎么算?只能让机器自己去算了。

其实OPENAI(开发chatGPT的公司)在这上面并没有革命性的创新,他用的就是谷歌开发的Transfomer架构,他的最后那个字母「T」,就是指的Transfomer。

GPT的全称就是基于Transfomer架构的预训练神经网络模型。

谷歌其实还挺冤的,自己开发的架构,被别人给发扬光大了,自己只能作为追随者发布了BARD。

最早GPT在第一代和第二代的时候,效果其实比不上谷歌。只是到了GPT3的时候,OPENAI给它喂了大量的数据以后,出现了连他的创始人都没预想到的效果:

第一,GPT出现了再学习能力。我告诉GPT用文化母体、营销日历的方法策划一个营销活动,然后告诉他文化母体是什么,营销日历是什么,她真的就根据我提供的框架给出了一个策划方案。第二,想法涌现,这可能是最让人惊讶的,也是只有在人类创造的时候才会有的,无法捉摸。

第三,就是逻辑推理,这个我们都看到了他的厉害。

这也是神经网络让人害怕的地方,他训练的模型是一个黑匣子,所有人都只能看到输入和最后的输出,但是他过程中做了什么,我们无从知道。

GPT真的有意识吗?

我的回答是,目前GPT没有意识。

意识是什么?

我们人的意识,是通过有很多的感觉器官,比如眼睛鼻子耳朵等等,来接收到外界的各种刺激输入,然后在大脑里面生成有意义的图像、语言、音乐、香味等等,并且基于我们感受到的东西,衍生出更多不存在的想象和创造。

而GPT现在有这样的东西吗?没有。

你看他生成的东西虽然好像能理解你,就像一个人一样,但是它仅仅只是基于大量的文字数据集,计算下一个往外蹦的词应该是什么而已。

他其实并不知道自己在说些什么。

以目前GPT所使用的神经网络的架构,不会产生意识,他只是数据足够多,使得他产生了我们没有预料的能力。

当然,我也无法极其确定的说就一定不会有意识,因为中间的多层神经网络对于我们来讲,始终是一个黑匣子。

我们不知道他做了什么,也不知道是什么状态。

也许有一天,在学习了整个人类世界的所有数据,包括文字、语音、图片、视频,他真的发展出意识,只是,这种意识不是人类的那种意识而已。