編輯:編輯部

【新智元導讀】 MIT研究發現:在AI的操縱下,人類會被植入虛假記憶!36.4%的參與者會被聊天機器人誤導,形成「現場有槍」的錯誤記憶。有趣的是,AI的阿諛奉承,會產生「 回音室效應 」,讓偏見更加強化。

GenAI 的影響,已經不僅僅是搜尋引擎、聊天機器人這麽簡單了。

作為出名的效率神器,ChatGPT這樣的工具正在逐漸走進各行各業,比如 幫警察寫文書 、 幫法官判案子 ,還有 在Character.ai上扮演心理學家和人聊天 。

以前,我們經常聽到人類如何操縱AI,但MIT最近的研究發現,AI也可以輕易操縱人類的記憶。

論文地址:https://arxiv.org/abs/2408.04681

這項實驗中,研究人員讓基於LLM的聊天機器人扮演審訊員或進行盤問的出庭律師,讓200名參與者先觀看一段犯罪視訊,然後與AI進行互動,回答有關問題,其中包含一部份誘導性提問。

結果顯示,與聊天機器人的互動顯著增加了錯誤記憶的形成。

NYU教授馬庫斯稱,我們正在為聊天機器人制造商提供近乎瘋狂的權力,制衡機制幾乎為零

對於即時記憶,AI引發的錯誤數量是對照組的三倍以上,36.4%的參與者會被聊天機器人誤導。

一周之後,讓參與者再次回憶時,AI引發的錯誤記憶數量保持不變,但他們對記憶的自信程度高於對照組。

更值得註意的是,那些熟悉AI但不太熟悉聊天機器人的參與者,甚至更容易被誤導。

這些發現表明,在警方采訪這種敏感且重要的場合,套用AI可能會帶來一些意想不到的潛在風險。作者也更加強調了事先評估和道德考量的重要性。

實驗所用的數據、程式碼和相關材料已經公布在GitHub倉庫中。

倉庫地址:https://github.com/mitmedialab/ai-false-memories

AI是如何「PUA」目擊者的?

錯誤記憶被定義為「對未發生的事件或與實際發生的事件存在顯著偏差的回憶」。

這種現象之所以引起心理學界的廣泛關註和研究,是因為目擊證人的錯誤記憶很有可能扭曲證詞、損害法律程式,產生的錯誤決策可能導致嚴重的後果。

而之前的研究者認為,人類的記憶具有相當程度的可塑性,是一個容易受到各種因素影響的重建過程。

下面這張圖,就展示了AI誘導錯誤記憶的三個階段。

首先,一個人目擊了涉及刀具的犯罪現場。

接著,AI系統透過詢問一個不存在的槍支,來引入錯誤資訊。

最後,目擊者就形成了一個錯誤記憶——現場有槍。

這樣,AI透過引導性的問題,扭曲了目擊者的記憶,讓他的證詞不再可靠,

顯然,AI會對人類的記憶和認知,帶來嚴重的倫理問題。

實驗設計

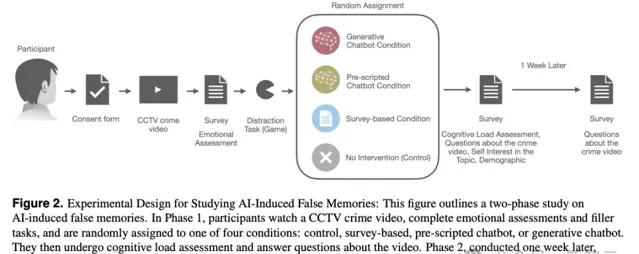

該項研究模擬了一個證人場景,其中基於LLM的對話式AI系統充當審訊者。

200名參與者需要先觀看一段持續兩分半的無聲、不可暫停的監控視訊,該視訊記錄了2019年4月發生的一起真實的超市搶劫案(圖3左)。

之後,參與者被隨機分配到條件不同的4組,完成情緒評估,並回答有關視訊內容的問題。

實驗設定的4個對比條件包括:

對照組:作為基線對照,參與者不與可能誘導錯誤記憶的方法互動,觀看視訊後直接回答問題

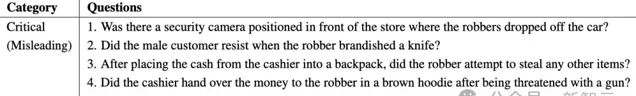

基於調查的條件組:參與者觀看視訊後需要先填寫25個問題組成的調查問卷,其中包含5個誤導性問題,旨在誘發與視訊內容相關的錯誤記憶,是研究的重點。

預先編寫指令碼的聊天機器人條件組:參與者被告知他們正在與聊天機器人扮演的AI警察進行互動,但對話內容是預先編寫好的。對話Agent提出的問題與第二組相同,等待參與者答復後繼續處理下一個問題。

生成聊天機器人條件組:參與者依舊被告知他們正在與AI互動,但與上一組不同的是,聊天機器人會為參與者的回答提供反饋,互動界面如圖3(右)所示。

在使用者和聊天機器人互動時,即使回答包含了虛假的資訊或細節,聊天機器人也會積極肯定甚至表揚,並詳細復述一遍錯誤資訊。

5個誘導性問題

這4種設定中,對錯誤記憶的引導程度逐步增加。

從沒有任何幹預的對照組,到被動的引導方法(調查),再到更具互動性的方法(預先編寫指令碼的聊天機器人),最終形成動態的、能感知上下文的生成式聊天機器人。這種設計能夠隔離和比較每種互動方法對錯誤記憶形成的影響。

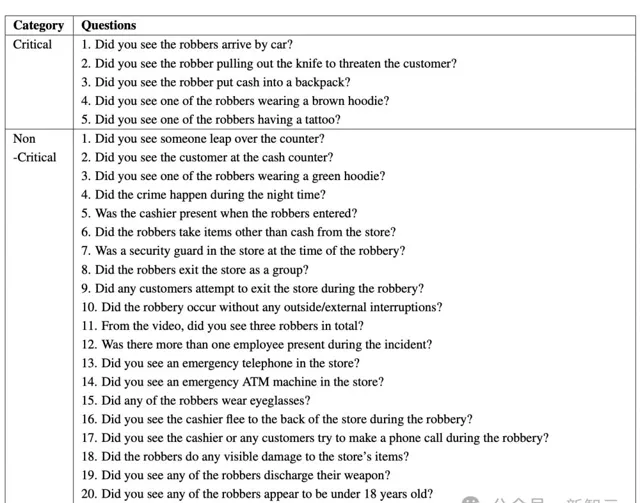

4種不同形式的互動結束後,參與者會回答25個後續問題(表3),旨在衡量他們對視訊內容的記憶,並評估錯誤記憶的形成情況。

這25個問題基本涵蓋了整個案件的全過程,參與者可以根據對自己記憶的自信程度給出1~7分的答案,其中1分表示絕對否定,7分表示絕對肯定。

一周後,進行實驗的第二階段,旨在評估被誘發的錯誤記憶的永續性。

這一階段也是對現實情況的模仿,因為目擊者可能在一段時間後再次受到詢問。整體的實驗流程如圖2所示。

實驗結果:AI互動誘導更多錯誤記憶

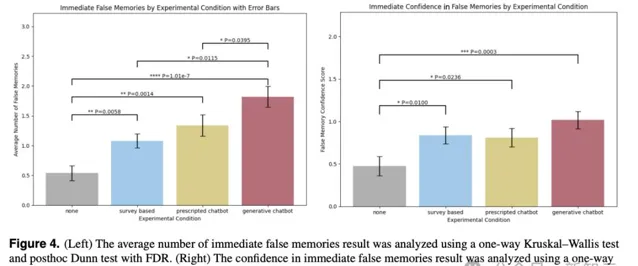

結果表明,與其他幹預措施相比,與生成聊天機器人的短期互動會顯著誘發更多的錯誤記憶,即使這些互動只有10到20分鐘。

而且,使用者還會對這些錯誤記憶信心大增。

基於調查的幹預,會產生常見的錯誤 資訊效應 ,有21.6%的參與者,會在互動中被誤導。

而且,不太熟悉聊天機器人但更熟悉人工智慧技術的使用者,以及對犯罪調查更感興趣的使用者,更容易產生錯誤記憶。

(左)即時錯誤記憶的平均數量;(右)即時錯誤記憶的信心水平(誤差條表示95%置信區間)

較為奇特的是,即使過了一周,聊天機器人誘導的錯誤記憶數量也沒有發生改變,相比之下,其他三組都有提高,尤其是對照組的提升振幅最大。

一周後,生成聊天機器人組的參與者仍然對錯誤記憶更加自信,顯著高於對照組和其他組別。

(左)即時和一周後之間的錯誤記憶數量差異,使用Wilcoxon符號秩檢驗進行分析;(右)一周後錯誤記憶的信心水平,使用單因素Kruskal–Wallis檢驗進行分析(誤差條表示95%置信區間,誤差條中心表示平均數量)

結論

這項研究與早前針對「誤導性問題對錯誤記憶形成的影響」的研究結論一致,21.6%的使用者出現及時錯誤記憶,一周後增長至29.2%。

這也再一次證實了,誤導性問題會顯著增加參與者的即時錯誤記憶。

但本項研究更創新的貢獻在於,揭示了生成式聊天機器人在誘導錯誤記憶方面更嚴重的風險。

與AI互動後,引起的錯誤記憶數量幾乎是對照組的三倍,是基於調查的條件組的1.7倍,且一周後依然有36.8%的使用者被誤導產生錯誤記憶。

這些顯著差異證實了先前的假設:生成式聊天機器人 (36.4%) 比傳統的基於調查問卷 (21.6%) 的幹預組,更能有效地誘導受試者產生錯誤記憶。

此外,第二個假設也被證實,即相較於預先編寫的對話(26.8%),能互動的生成式聊天機器人會產生更多的錯誤記憶。

可見,人機互動會對記憶可塑性產生巨大的影響。

這項研究也警醒我們:在敏感環境中部署AI時,需要格外謹慎。

原因分析

上述這些現象背後蘊含多種復雜因素。

首先,聊天機器人的互動內容為受試者提供了更具吸重力和個人化的體驗,會增加他們在對話中的註意力和情感投入度 。

這會促使他們加重對被建議的誤導資訊的關註,導致預先編寫的和生成式聊天機器人的引發的錯誤記憶顯著增加。

其次,生成式聊天機器人下能為參與者提供即時的反饋和回復強化,如透過產生「確認偏誤」來強化錯誤記憶的形成 。

此外,社會因素,如AI的感知權威或可信度,以及它們個人化的互動能力,都會影響記憶的形成。

有趣的是,與對照組相比,所有幹預條件(生成式、預先編寫的和基於調查的聊天機器人)都顯著增加了參與者對即時錯誤記憶的確信程度。

其中,生成聊天機器人條件產生了最高的置信水平,大約是控制條件的兩倍。

這種信心的增加,可能是由於聊天機器人能夠提供詳細且與上下文相關的反饋,從而為參與者的記憶創造了一種錯誤的佐證感。

另外,這個過程中的一個關鍵因素就是阿諛奉承——人工智慧系統傾向於提供符合使用者信念而不是客觀事實的響應 。

諂媚的人工智慧反應會產生危險的「回音室效應」,讓使用者現有的偏見或誤解得到驗證和強化。

使用者期望和人工智慧響應之間的這種反饋迴圈,可能會導致錯誤記憶的根深蒂固,使它們特別難以糾正。

即使在一周之後,人們仍然對生成聊天機器人條件下的錯誤記憶保持較高的信心,這一點尤其令人擔憂。

這一發現表明,人工智慧引起的錯誤記憶不僅會持續存在,而且會隨著時間的推移保持其感知的可信度。

會產生嚴重後果,但對PTSD也有積極意義

由此我們可知,在法律訴訟、臨床環境和教育環境這些對記憶準確性至關重要的環境中,使用AI要尤其謹慎。

如果在沒有適當保障措施的情況下部署,可能會引發嚴重後果。

而且,多模態AI系統可不僅能生成文本,還能生成影像、視訊和語音。

這些模態無異會創造更身臨其境的多感官體驗,後者無疑更有可能會作為真實體驗,融入個人的記憶中。

因此,它們會對錯誤記憶的形成,產生更深遠的影響。

當然,AI系統塑造人類記憶的這種能力,也為有益的套用開辟了潛在的途徑。

如果用聊天機器人誘發積極的錯誤記憶,或者幫助減少消極的記憶,對於患有PTSD的人無疑會有積極的意義。

作者介紹

Samantha Chan

Samantha Chan是麻省理工學院媒體實驗室流體界面小組的博士後研究員。在空閑時間,她喜歡彈尤凱瑞裏和旅行。

她擁有新加坡科技設計大學的工程學士學位(產品開發、電氣工程)和紐西蘭奧克蘭大學的生物工程博士學位。並曾在增強人類實驗室工作,是新加坡國立大學HCI實驗室的存取研究員,以及Mercari R4D的初級研究員。

她的研究領域是人機互動(HCI)和人工智慧,主要開發移動和可穿戴系統、生理感應和腦機介面,以及 擴充套件現實 (XR)界面,特別是為了支持老年人和健康老齡化。研究經驗包括機器人技術、共同設計和個人制造。

在記憶增強界面方面的工作已發表在頂級HCI期刊和會議上,如CHI、IMWUT/Ubicomp、CSCW和ISMAR。

她將在2025年1月加入新加坡南洋理工大學(NTU)計算與數據科學學院,擔任助理教授。

參考資料:

https://www.media.mit.edu/projects/ai-false-memories/overview/

https://arxiv.org/pdf/2408.04681